服务器可以做负载均衡吗

- 行业动态

- 2025-04-06

- 1

服务器可以做负载均衡,以下是关于服务器负载均衡的详细说明:

1、基本概念

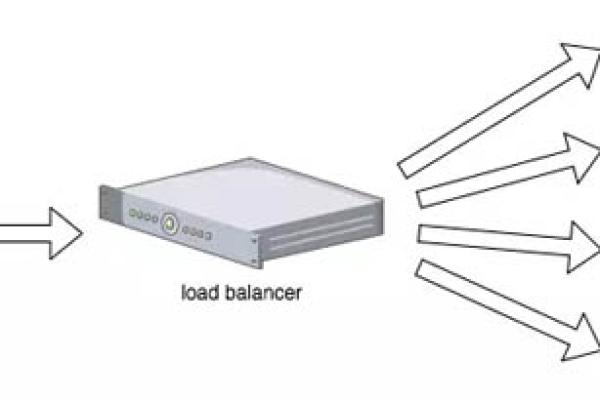

负载均衡(Load Balance)指将负载流量(工作任务、访问请求)平衡、分摊到多个操作单元(服务器、组件)上去执行的过程,目的在于提供负载配比,解决性能、单点故障(高可用)和扩展性(水平伸缩)等问题。

2、工作原理

负载均衡服务器实时监测服务器的状态,当某个服务器出现故障时,自动将请求转移到其他正常服务器上,从而保证系统的可靠性。

负载均衡服务器可以很容易地添加或删除服务器,从而根据业务需求灵活调整系统的规模。

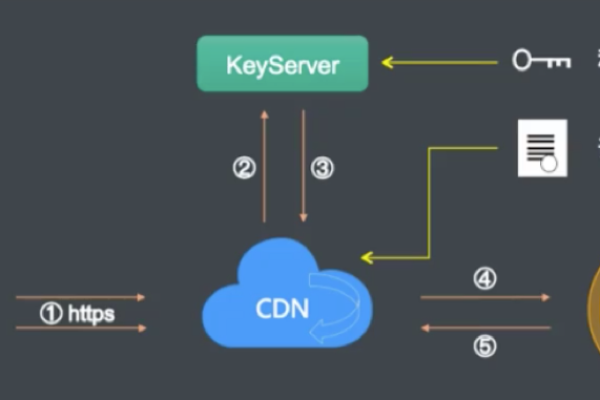

负载均衡服务器可以配置缓存,将经常访问的数据缓存到内存中,减少对后端服务器的请求,提高系统的响应速度。

负载均衡服务器可以配置安全策略,例如防火墙、SSL加密等,保护系统免受网络攻击,提高系统的安全性。

3、实现方式

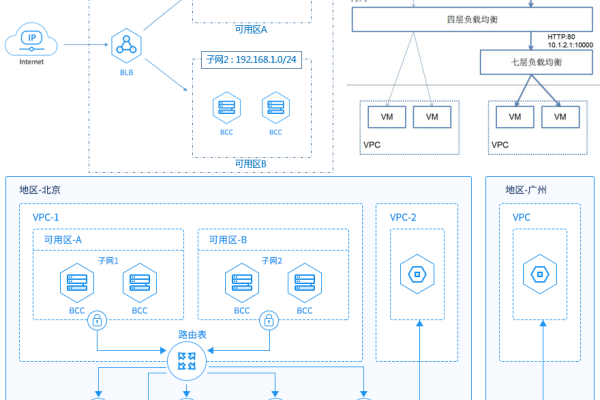

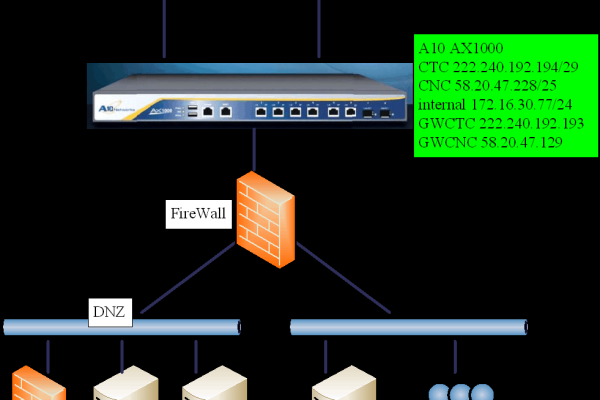

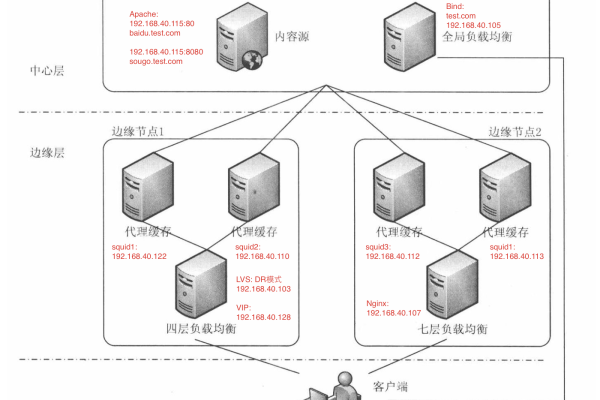

硬件负载均衡器:独立的硬件设备,通常部署在数据中心的网络入口处,通过专用的硬件芯片来处理大量的并发连接和数据包转发,具有高性能、低延迟的特点,适用于对性能要求极高的场景,但成本较高,且配置相对复杂。

软件负载均衡器:安装在服务器上的软件应用程序,通过在操作系统级别或应用级别进行流量分发来实现负载均衡,常见的有Nginx、HAProxy、LVS等,软件负载均衡器成本较低,配置灵活,但性能可能不如硬件负载均衡器。

4、常见算法

轮询算法(Round Robin):依次将请求分配给不同的服务器,确保每个服务器接收到的请求数量大致相同,适用于服务器性能相近的场景。

最小连接数算法(Least Connections):优先将请求分配给当前连接数最少的服务器,使得服务器的负载更加均衡,适用于服务器性能差异较大的场景。

源地址哈希算法(Source IP Hash):根据请求的源IP地址进行哈希运算,将请求分配给固定的服务器,适用于需要根据用户地理位置或IP段进行分流的场景。

5、应用场景

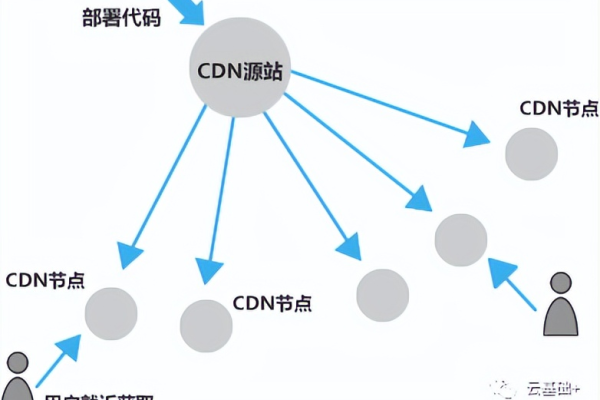

Web应用:对于高流量的网站,如电商平台、社交媒体等,负载均衡可以将用户请求均匀分配到多个Web服务器上,提高网站的响应速度和可用性。

数据库应用:在数据库集群中,负载均衡可以将读写请求分配到不同的数据库节点上,提高数据库的性能和可扩展性。

文件存储:对于大规模的文件存储系统,负载均衡可以将文件上传和下载请求分配到不同的存储节点上,提高存储系统的性能和可靠性。

相关问题与解答

1、问题:如何选择合适的负载均衡算法?

解答:在选择负载均衡算法时,需要考虑服务器的性能差异、业务需求等因素,如果服务器性能相近,可以选择轮询算法;如果服务器性能差异较大,可以选择最小连接数算法;如果需要根据用户地理位置或IP段进行分流,可以选择源地址哈希算法。

2、问题:负载均衡器是否会影响系统的性能?

解答:负载均衡器本身会对系统的性能产生一定的影响,主要体现在以下几个方面:一是处理请求的开销,负载均衡器需要对每个请求进行处理和转发,这会增加一定的处理时间和资源消耗;二是缓存命中率,如果负载均衡器的缓存命中率不高,可能会导致大量的请求被转发到后端服务器上,增加后端服务器的负载;三是网络延迟,负载均衡器可能会增加网络传输的延迟,影响系统的响应速度,在选择负载均衡器时,需要综合考虑其性能、功能和成本等因素。