服务器可以深度学习吗

- 行业动态

- 2025-04-09

- 2

服务器可以进行深度学习,以下是详细说明:

1、硬件基础

强大的计算能力:深度学习需要大量的计算资源来处理复杂的数学运算和矩阵操作,服务器通常配备了高性能的CPU或GPU(图形处理器),能够提供强大的计算能力,加速深度学习模型的训练过程,NVIDIA的Tesla系列GPU在深度学习领域被广泛使用,其具有高度并行处理能力,可以显著提高模型训练的速度。

大容量的内存和存储:深度学习模型在训练过程中需要处理大量的数据,并且模型本身也可能非常庞大,服务器通常具备大容量的内存和存储设备,能够满足深度学习任务对数据存储和读取的需求,一些大型的深度学习模型可能需要数百GB甚至数TB的内存来存储模型参数和中间结果。

2、软件支持

操作系统和驱动程序:服务器上通常运行着各种操作系统,如Linux、Windows Server等,这些操作系统为深度学习软件的运行提供了稳定的环境,服务器还需要安装相应的GPU驱动程序,以便充分发挥GPU的性能。

深度学习框架:有许多流行的深度学习框架可以在服务器上运行,如TensorFlow、PyTorch、Keras等,这些框架提供了丰富的工具和函数,方便开发者构建、训练和优化深度学习模型,TensorFlow是一个开源的深度学习框架,它支持多种编程语言和平台,可以在不同的服务器环境中使用。

数据处理和分析工具:深度学习需要大量的数据进行训练和测试,因此服务器上通常还会配备一些数据处理和分析工具,如NumPy、Pandas等,这些工具可以帮助开发者对数据进行清洗、预处理和分析,提高数据的质量和可用性。

3、网络环境

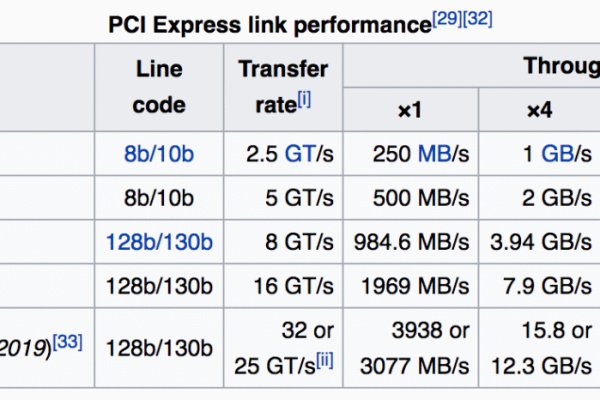

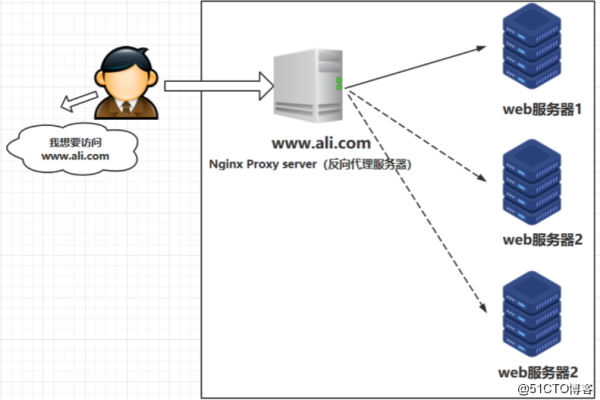

高速网络连接:服务器通常需要通过网络与其他计算机或设备进行通信,以便获取数据、传输模型参数和接收训练结果等,高速的网络连接可以保证数据传输的速度和稳定性,提高深度学习任务的效率,在云计算环境中,服务器之间通过高速网络连接可以实现快速的数据传输和共享。

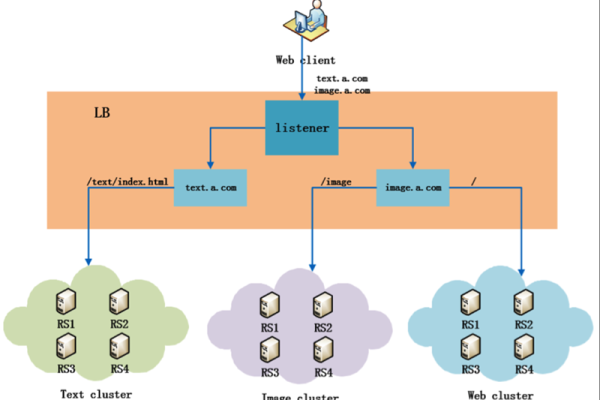

分布式计算支持:在一些大规模的深度学习任务中,可能需要多台服务器协同工作,进行分布式计算,服务器之间的网络通信和协调就非常重要,一些深度学习框架和平台提供了分布式计算的支持,可以方便地在多台服务器上部署和运行深度学习模型。

4、应用场景

模型训练:服务器是深度学习模型训练的理想平台,尤其是在处理大规模数据集和复杂模型时,通过利用服务器的强大计算能力和大容量存储,可以快速地训练出高质量的深度学习模型,在图像识别、自然语言处理等领域,研究人员经常使用服务器来训练深度神经网络模型。

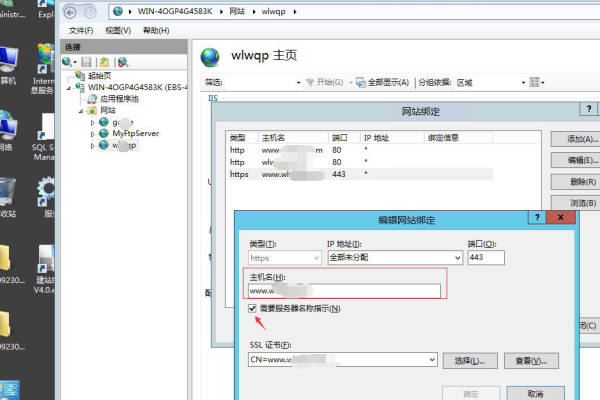

模型部署:训练好的深度学习模型需要在实际应用中进行部署和使用,服务器可以作为模型部署的平台,将模型部署到服务器上后,可以通过网络接口接收输入数据,进行预测或分类,并将结果返回给用户,在智能客服、自动驾驶等领域,深度学习模型被部署在服务器上,为用户提供实时的服务和支持。

数据分析和挖掘:深度学习不仅可以用于模型训练和预测,还可以用于数据分析和挖掘,服务器上的大数据处理和分析工具可以与深度学习模型相结合,对海量的数据进行分析和挖掘,发现其中的规律和价值,在金融、医疗等领域,深度学习可以帮助分析市场趋势、疾病诊断等。

服务器凭借其强大的硬件基础、完善的软件支持、良好的网络环境以及广泛的应用场景,完全可以满足深度学习的需求,为深度学习的发展和应用提供了重要的支撑。