GPU服务器为何频繁提示请稍后再试?

- 行业动态

- 2025-04-16

- 2

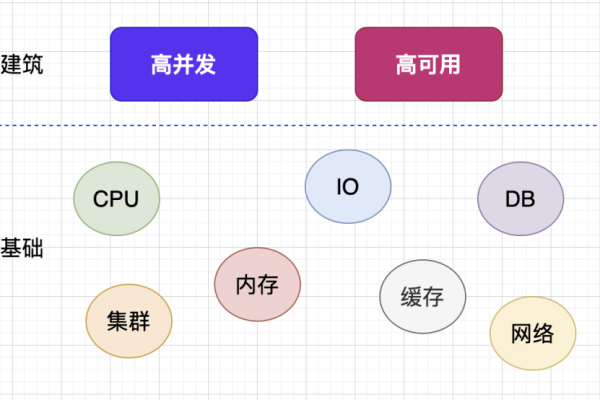

GPU服务器提示“请稍后再试”通常由高并发请求或资源过载引发,可能是暂时性服务限制或系统维护导致,建议稍后重试,检查网络连接,或联系管理员确认服务器状态,频繁出现需排查任务配置,优化资源使用策略以避免排队阻塞。

当您在使用GPU服务器时遇到“请稍后再试”的提示,可能是由多种原因导致的,本指南将详细解释潜在原因、解决方案及预防措施,帮助您快速定位问题并恢复服务。

常见原因分析

服务器资源超载

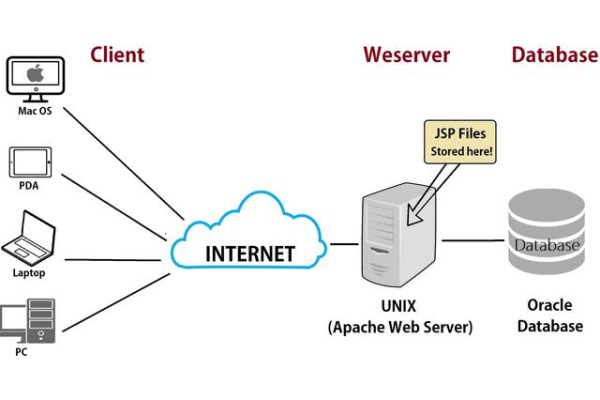

GPU服务器的高负载(如并行计算任务过多、显存不足)可能导致系统自动触发保护机制,暂时拒绝新请求,此时系统会提示“请稍后再试”以缓解压力。网络通信异常

服务器与客户端之间的网络延迟、丢包或防火墙拦截可能导致请求无法正常响应,触发系统保护提示。配置参数错误

错误的GPU驱动版本、CUDA库兼容性问题,或任务调度策略(如Kubernetes资源配额限制)配置不当,可能引发服务器自我保护。

软件服务限制

某些AI框架(如TensorFlow、PyTorch)或云服务平台的API可能存在并发请求限制,超出阈值时会被临时拦截。

分步解决方案

第一步:检查服务器负载状态

- 使用命令查看当前资源占用:

nvidia-smi # 查看GPU使用率与显存占用 top 或 htop # 检查CPU、内存负载

- 若显存或内存占用超过90%,建议:

- 终止非必要进程

- 调整任务优先级或分批处理

- 升级服务器配置(如增加GPU数量/显存)

第二步:排查网络问题

- 测试网络连通性:

ping <服务器IP> # 检查延迟与丢包率 traceroute <服务器IP> # 追踪路由节点

- 确保防火墙或安全组规则允许相关端口(如SSH、API端口)的出入站流量。

第三步:验证配置与依赖

- GPU驱动与CUDA版本

检查驱动是否与框架要求匹配(PyTorch需特定CUDA版本),可通过以下命令查看:nvcc --version # 显示CUDA版本 cat /usr/local/cuda/version.txt

- 任务调度配置

若使用容器化部署(如Docker/Kubernetes),确认资源限制(如nvidia.com/gpu配额)未超出物理资源上限。

第四步:检查服务限流策略

- 查阅所用平台的API文档(如AWS EC2、阿里云GPU实例),确认是否存在以下限制:

- 每分钟请求次数(RPM)

- 单用户并发连接数

- 地域或账户级配额

若需提升限制,需通过控制台或工单申请。

长期预防措施

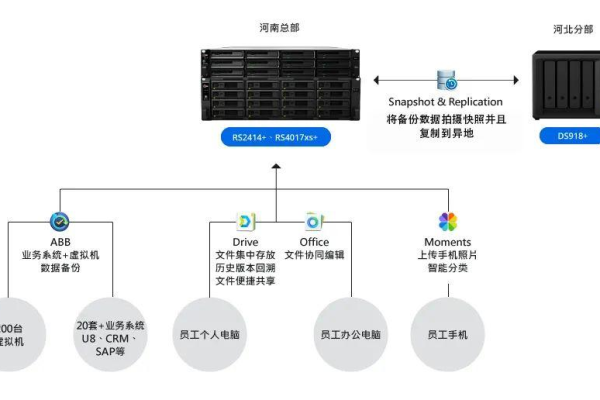

资源监控与告警

部署监控工具(如Prometheus+Grafana),实时跟踪GPU利用率、显存占用及网络状态,设置阈值告警。

弹性伸缩设计

在云环境中配置自动扩缩容(如AWS Auto Scaling组),根据负载动态调整GPU实例数量。代码级优化

- 使用混合精度训练(FP16/FP32)减少显存消耗

- 启用CUDA Stream或异步I/O提升任务并行效率

- 定期清理缓存数据(如

torch.cuda.empty_cache())

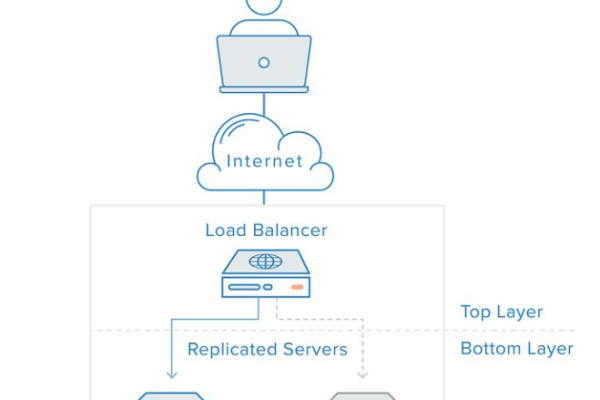

冗余与灾备

通过负载均衡器分发请求至多台GPU服务器,避免单点故障。

引用说明

- NVIDIA官方驱动兼容性指南:developer.nvidia.com/cuda-gpus

- Kubernetes资源配额配置文档:kubernetes.io/docs/concepts

- PyTorch显存优化建议:pytorch.org/docs/stable/notes/cuda.html

通过上述方法,您可系统性地诊断并解决GPU服务器的“请稍后再试”问题,如问题持续存在,建议联系服务器提供商的技术支持,并提供日志(如/var/log/syslog、dmesg输出)以进一步分析。