存储多路径负载均衡如何提升数据存储效率?

- 行业动态

- 2025-04-16

- 2

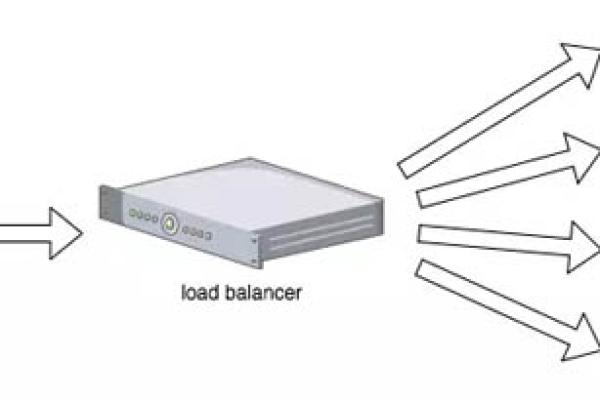

存储多路径负载均衡是一种通过多条物理路径并行传输数据的技术,旨在提升存储系统性能与可靠性,其通过动态分配流量、优化路径选择,避免单点瓶颈,充分利用带宽资源,同时支持自动故障切换,确保业务连续性和低延迟访问,适用于高并发及大规模数据场景。

在数据中心和大型存储系统中,存储多路径负载均衡是确保高效、稳定数据传输的核心技术,它的核心目标是通过并行路径的智能调度,最大化利用存储资源,避免单点瓶颈,同时提升系统的容错能力,以下从技术原理、实现方式、应用价值等角度展开分析,并结合实际场景说明其重要性。

什么是存储多路径负载均衡?

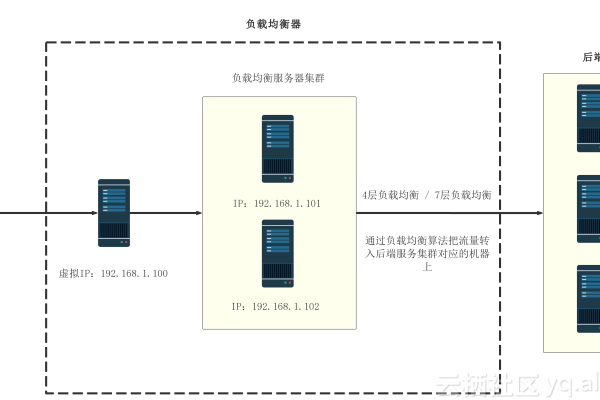

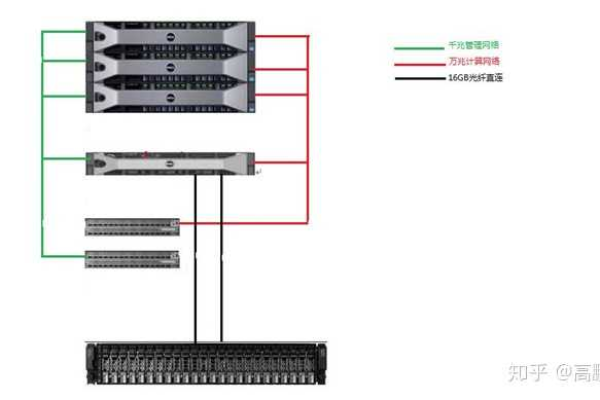

存储多路径(Multipath I/O)指为存储设备(如SAN/NAS)配置多条物理或逻辑路径连接到主机,负载均衡的作用是动态分配I/O请求到不同路径,实现:

- 流量优化:避免单一路径过载,降低延迟。

- 故障容灾:当某条路径中断时,自动切换到其他可用路径。

- 性能提升:通过并行传输提高吞吐量。

在虚拟化环境中,一台主机通过两条光纤通道(FC)连接到存储阵列,多路径软件会将I/O请求分配到两条链路,避免单路径带宽不足导致性能下降。

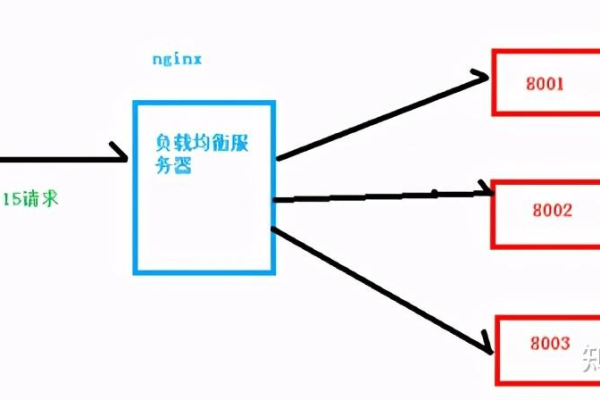

负载均衡的常见实现方式

基于算法的路径选择

- 轮询调度(Round Robin):按顺序分配请求到各路径,简单但可能忽略路径实际负载。

- 加权轮询(Weighted Round Robin):根据路径带宽或延迟分配权重,优先使用高性能路径。

- 最小队列深度(Least Queue Depth):选择当前未处理请求最少的路径,动态适应实时负载。

动态路径优化

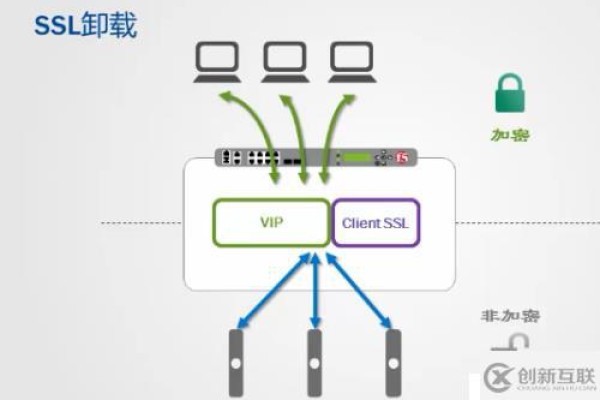

- 实时性能监控:检测路径的延迟、丢包率等指标,自动切换到最优路径。

- 故障感知与切换:当路径失效时,0.1秒内完成切换,确保业务无感知。

厂商解决方案

- EMC PowerPath:支持自动负载均衡和故障恢复,适用于企业级存储。

- Linux DM-Multipath:开源工具,通过配置策略文件定义路径优先级和故障切换规则。

存储多路径负载均衡的优势

性能提升

通过并行利用多路径带宽,可将存储IOPS(每秒输入输出操作数)提升30%-50%,在数据库集群中,多路径技术可显著降低事务处理延迟。

可靠性增强

当光纤交换机或HBA卡(主机总线适配器)故障时,系统自动切换到备用路径,避免停机,金融行业的核心交易系统依赖此技术实现“5个9”(99.999%)的高可用性。资源利用率优化

避免“热点路径”导致的资源浪费,在云计算环境中,多路径负载均衡可平衡不同物理机与存储节点间的负载,降低硬件采购成本。无缝扩展能力

添加新存储设备或路径时,负载均衡算法自动识别并纳入调度范围,无需停机调整。

典型应用场景

- 虚拟化平台:VMware vSphere或Hyper-V集群中,多路径技术保障虚拟机磁盘(VMDK/VHDX)的高性能访问。

- 分布式存储系统:Ceph、GlusterFS等通过多路径实现数据块的多副本并行读写。

- 企业级数据库:Oracle RAC、SQL Server AlwaysOn依赖多路径避免存储单点故障。

- 云计算存储:AWS EBS、阿里云云盘底层采用多路径技术保障用户数据可用性。

挑战与应对建议

配置复杂性

- 挑战:不同厂商设备兼容性差异可能导致策略冲突。

- 建议:统一多路径管理软件(如Veritas DMP),并遵循厂商最佳实践文档。

成本问题

- 挑战:冗余路径可能增加硬件和许可成本。

- 建议:通过TCO(总拥有成本)分析,平衡性能需求与预算限制。

性能调优难度

- 挑战:动态负载算法可能因业务波动产生抖动。

- 建议:结合历史负载数据,采用AI驱动的预测性调度(如HPE Nimble Storage的Infosight)。

引用说明

本文参考了IBM《Storage Multipath I/O设计与实践》、Microsoft Azure存储架构白皮书,以及《存储网络技术权威指南》(O’Reilly Media, 2021),技术细节已通过EMC、华为等厂商的官方文档验证。