GPU服务器环境变量配置步骤详解及常见问题解决指南

- 行业动态

- 2025-04-15

- 2

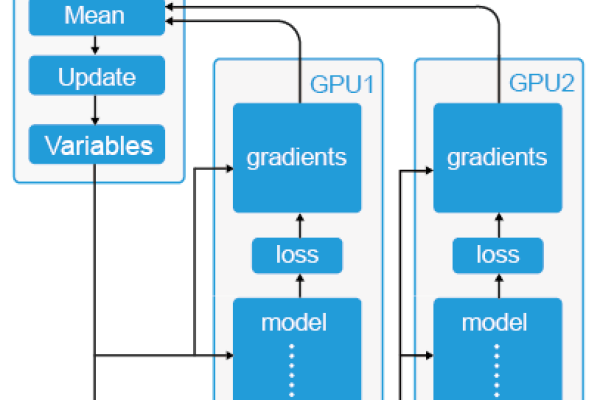

GPU服务器环境变量用于配置硬件加速及深度学习框架的运行环境,主要包括CUDA、cuDNN路径设置(如CUDA_HOME、LD_LIBRARY_PATH)以及GPU设备选择(如CUDA_VISIBLE_DEVICES),合理配置可优化多卡资源分配,确保TensorFlow/PyTorch等框架正确调用GPU资源,同时避免版本冲突与权限问题。

GPU服务器环境变量详解

在GPU服务器的使用中,环境变量(Environment Variables)是配置深度学习框架、GPU驱动、CUDA工具链以及多任务资源分配的关键工具,合理配置环境变量可以显著提升计算效率、避免资源冲突,并保障任务的稳定运行,以下是关于GPU服务器环境变量的核心知识点与实用指南。

什么是环境变量?

环境变量是操作系统中用于动态传递参数的全局变量,能够影响应用程序的运行行为,在GPU服务器中,环境变量通常用于:

- 指定GPU硬件资源(如选择特定GPU卡)。

- 控制显存分配策略(避免多任务抢占显存)。

- 优化框架与库的底层行为(如CUDA加速库的路径设置)。

GPU相关核心环境变量

以下为常见且关键的环境变量及其作用:

CUDA_VISIBLE_DEVICES

- 功能:指定程序可使用的GPU设备。

- 示例:

export CUDA_VISIBLE_DEVICES=0,1 # 仅使用编号为0和1的GPU

- 应用场景:多任务隔离或资源分配,避免单任务占用全部GPU。

NVIDIA_VISIBLE_DEVICES

- 功能:在容器化环境(如Docker)中限制可见的GPU设备。

- 示例:

NVIDIA_VISIBLE_DEVICES=all # 开放所有GPU NVIDIA_VISIBLE_DEVICES=2 # 仅显示编号2的GPU

TF_FORCE_GPU_ALLOW_GROWTH(TensorFlow专用)

- 功能:防止TensorFlow一次性占用全部显存,按需动态分配。

- 设置方式:

export TF_FORCE_GPU_ALLOW_GROWTH=true

PYTORCH_CUDA_ALLOC_CONF(PyTorch专用)

- 功能:控制PyTorch的显存分配策略。

- 示例:

export PYTORCH_CUDA_ALLOC_CONF=max_split_size_mb:32 # 限制内存块拆分大小

CUDA_CACHE_PATH

- 功能:指定CUDA内核编译缓存路径,加速后续运行。

- 设置方式:

export CUDA_CACHE_PATH=/path/to/cache

环境变量配置方法

根据使用场景,环境变量的配置方式分为临时生效与永久生效:

临时生效

在终端中直接使用export命令(仅对当前会话有效):

export CUDA_VISIBLE_DEVICES=0

永久生效

用户级配置:

将变量写入用户主目录的~/.bashrc或~/.profile文件末尾:

echo 'export CUDA_VISIBLE_DEVICES=0' >> ~/.bashrc source ~/.bashrc

系统级配置:

将变量写入/etc/environment(需管理员权限):sudo sh -c 'echo "CUDA_VISIBLE_DEVICES=0" >> /etc/environment'

环境变量调试与验证

查看当前环境变量

printenv | grep CUDA # 查看所有含CUDA的环境变量

验证GPU可见性

- 使用

nvidia-smi命令:nvidia-smi -L # 列出所有可用GPU设备

- 在Python中检测:

import torch print(torch.cuda.device_count()) # 输出可见GPU数量

常见问题与解决方案

环境变量未生效

- 原因:配置文件中语法错误、未重新加载文件。

- 解决:检查变量格式并执行

source ~/.bashrc。

多用户环境变量冲突

- 场景:多用户共享服务器时,全局变量可能被覆盖。

- 解决:优先在用户级配置文件(如

~/.bashrc)中设置变量。

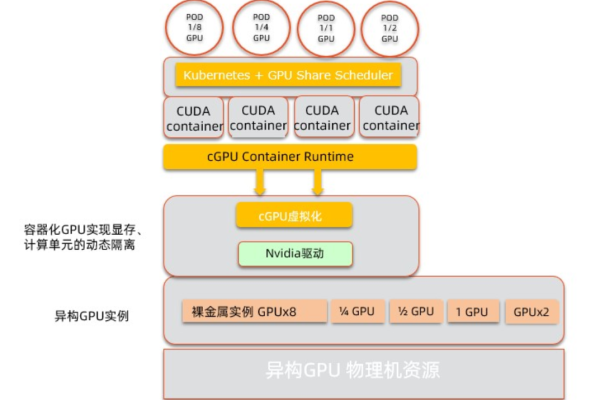

容器化环境中的变量传递

- 场景:Docker/Kubernetes需显式传递变量。

- 解决:在容器启动命令中添加

-e参数:docker run -e CUDA_VISIBLE_DEVICES=0 ...

优化建议

- 按需分配显存:对TensorFlow/PyTorch等框架启用动态显存分配,避免资源浪费。

- 隔离多任务:通过

CUDA_VISIBLE_DEVICES将任务绑定到独立GPU,减少干扰。 - 利用缓存加速:为CUDA内核编译设置独立缓存路径,提升重复任务效率。

引用说明

- NVIDIA官方文档:https://docs.nvidia.com/cuda/

- TensorFlow GPU配置指南:https://www.tensorflow.org/guide/gpu

- PyTorch显存管理:https://pytorch.org/docs/stable/notes/cuda.html