如何实现服务器的负载均衡布置?

- 行业动态

- 2025-01-01

- 4022

服务器布置负载均衡,通过分配任务到多台服务器,确保高效运行和稳定性。

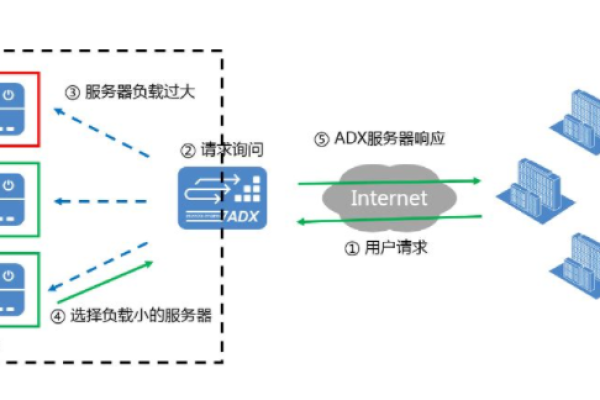

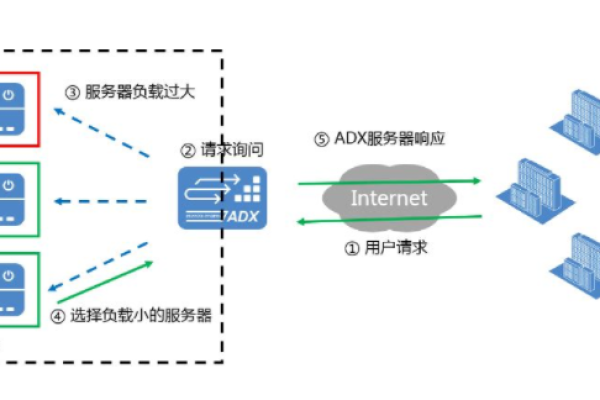

负载均衡是一种通过将请求分配到多个服务器上,从而优化资源使用、提高响应速度并增强系统可靠性的技术手段,在互联网高速发展的今天,负载均衡已经成为分布式系统和互联网应用中不可或缺的一部分,以下是关于服务器布置负载均衡的详细介绍:

1、负载均衡的背景

互联网的高速发展:随着互联网用户数量的增加,应用程序的并发请求量显著增长,早期的单台服务器模式已无法满足需求,因此需要将负载分摊到多台服务器上。

高可用性与故障容忍的需求:单点故障会导致系统不可用,通过冗余的方式将负载分布到多台服务器上,可以提升系统的容错能力。

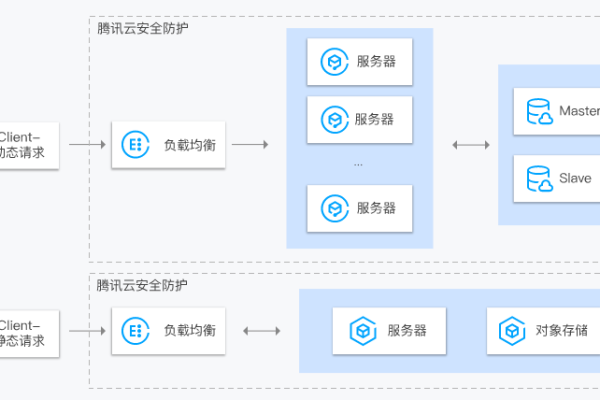

动态扩展和弹性需求:互联网业务具有不确定性,特别是在遇到促销活动或突发流量时,系统需要动态扩展来应对流量高峰。

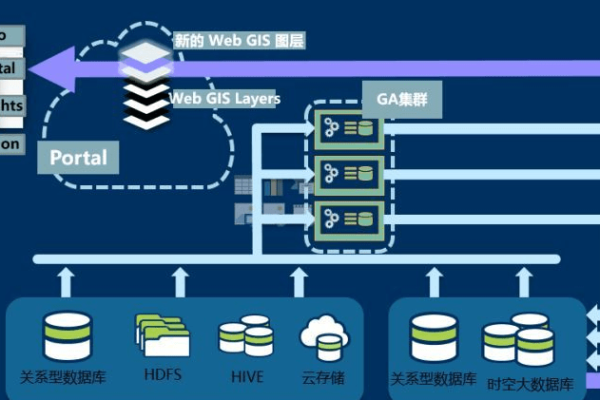

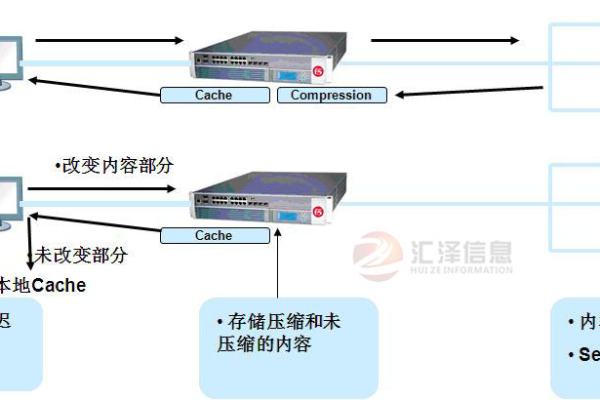

2、负载均衡的实现技术

硬件负载均衡:如F5、NetScaler等专用设备,适用于对性能和可靠性要求极高的场景。

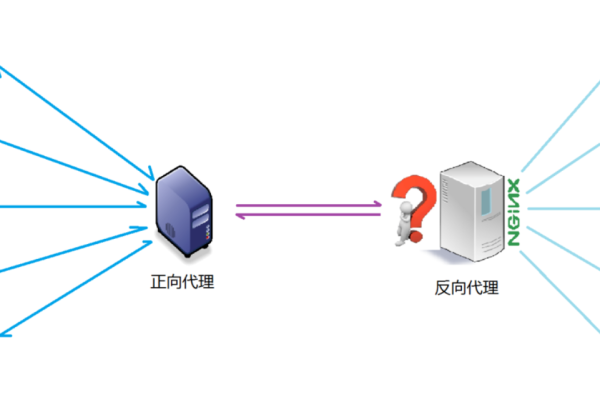

软件负载均衡:如Nginx、HAProxy等开源解决方案,配置简单且经济。

四层与七层负载均衡:四层基于传输层协议(如TCP/UDP),速度快;七层基于应用层协议(如HTTP/HTTPS),可以进行更精细化的流量分发。

3、常见的负载均衡算法

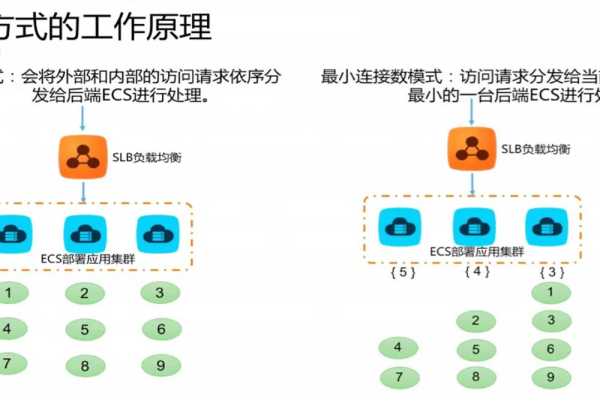

轮询(Round Robin):将请求依次分配给每个服务器,适用于服务器性能相近的情况。

加权轮询(Weighted Round Robin):根据服务器的性能分配不同的权重,性能更好的服务器处理更多的请求。

IP哈希(IP Hash):根据客户端的IP地址计算哈希值,将请求分配给特定的服务器,适用于需要保持客户端会话一致性的场景。

最少连接(Least Connections):将请求分配给当前连接数最少的服务器,适用于处理长连接请求的场景。

最短响应时间(Least Response Time):将请求分配给响应时间最短的服务器,适用于对响应时间有严格要求的应用场景。

4、负载均衡的作用范围

服务端负载均衡:将外部请求分发到内部服务器集群,以实现高性能和高可用性。

客户端负载均衡:由客户端自行选择合适的服务器进行请求,通常应用于微服务架构中。

DNS负载均衡:通过配置DNS记录,将同一个域名指向不同的IP地址,实现最简单的流量分发。

5、负载均衡的配置策略

需求采集与分析:确定应用的特定需求,如流量类型、用户分布和关键业务指标。

算法选择:选择适合业务需求的算法,如轮询、最少连接、加权轮询或IP散列等。

健康检查设置:定期检测服务器的可用性和响应性,确保流量只分配到可运行的节点。

6、负载均衡的技术实现与配置

选择合适的负载均衡器:评估并选择云供应商提供的负载均衡服务,如AWS ELB、Azure Load Balancer。

网络配置:设置合适的虚拟网络和安全组规则,确保负载均衡器与服务器间的高可靠连接。

自动化和可扩展性:通过基础设施即代码工具,实施自动化的配置和扩展策略。

7、负载均衡的监控优化与性能评估

实时监控:利用监控工具实时追踪负载均衡器的关键性能指标。

定期性能测试:实施常规压力和负载测试,评估负载均衡配置对实际应用流量的处理能力。

优化配置调整:基于监控数据,调整服务器的分配策略和算法参数。

8、负载均衡的故障排查与持续改进

日志分析与故障诊断:收集并分析负载均衡器和服务器日志,快速识别和解决流量分配或网络连接中的异常。

冗余与备份策略:实施地理冗余和多区域部署策略,增加故障恢复能力。

持续优化方案:运用机器学习模型进行流量模式分析,预测负载变化并自动优化配置。

负载均衡技术是现代互联网应用中不可或缺的一部分,它通过将请求分配到多个服务器上,优化了资源使用、提高响应速度并增强系统可靠性,在选择负载均衡策略时,需要根据实际应用场景、服务器性能、网络状况等因素进行综合考虑,以达到最佳的负载均衡效果,随着AI和自动化技术的深入发展,未来的负载均衡将变得更加智能化和自适应,为现代企业提供更具竞争力的技术解决方案。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/379802.html