如何使用MapReduce框架来实现DBSCAN聚类算法?

- 行业动态

- 2024-12-30

- 4689

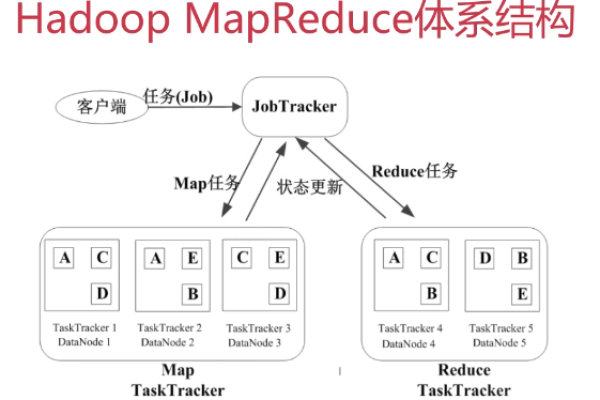

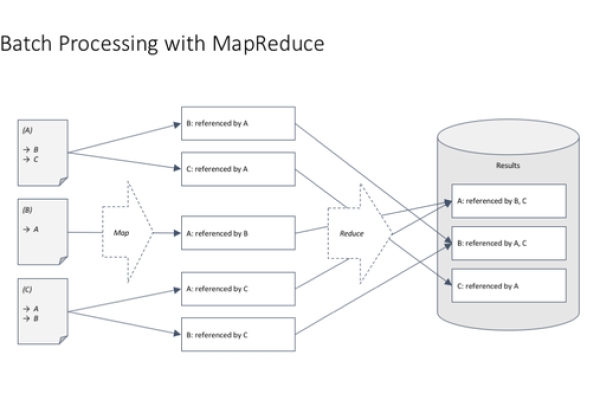

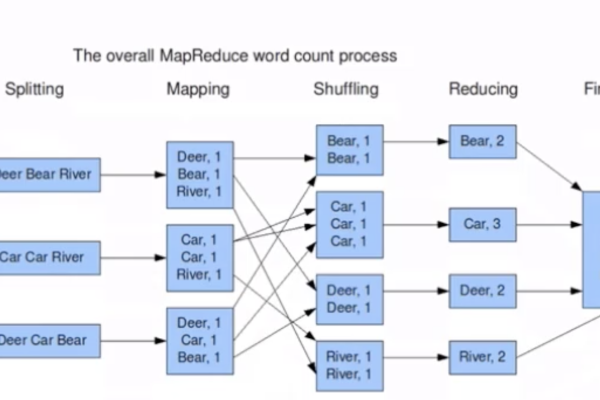

MapReduce 是一种编程模型,用于处理和生成大规模数据集。DBSCAN(Density-Based Spatial Clustering of Applications with Noise)是一种基于密度的聚类算法。将 DBSCAN 与 MapReduce 结合可以实现分布式的聚类分析。,,在 MapReduce 中,Map 阶段负责数据的预处理和初步分组,而 Reduce 阶段则负责进一步处理和合并结果。通过这种方式,可以有效地对大规模数据进行聚类分析。

MapReduce是一种用于处理大规模数据集的编程模型,它由Google开发并在Hadoop框架中广泛应用,DBSCAN(Density-Based Spatial Clustering of Applications with Noise)是一种基于密度的聚类算法,能够识别任意形状的簇并有效处理噪声数据,将DBSCAN与MapReduce结合,可以实现对大规模数据的高效聚类,下面将详细介绍如何在MapReduce框架下实现DBSCAN算法。

MapReduce实现DBSCAN的步骤

1、数据预处理:在MapReduce任务开始前,需要对数据进行预处理,包括数据清洗、格式转换等,以确保输入数据符合DBSCAN算法的要求。

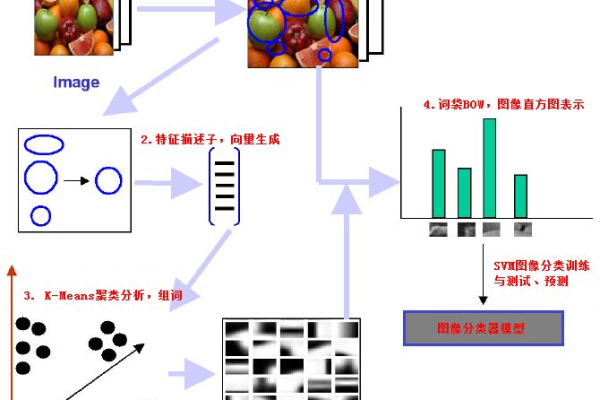

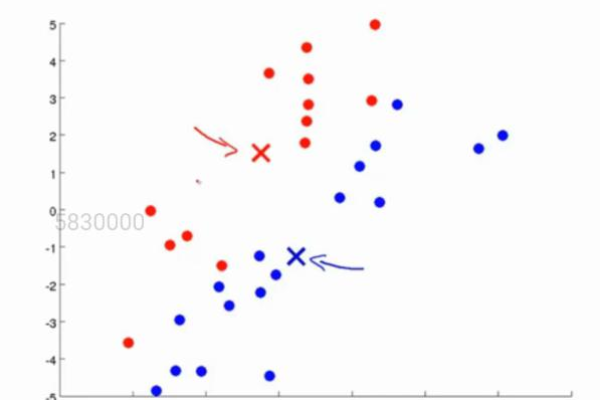

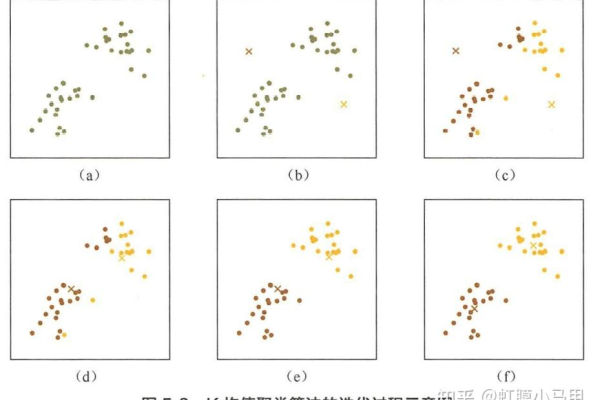

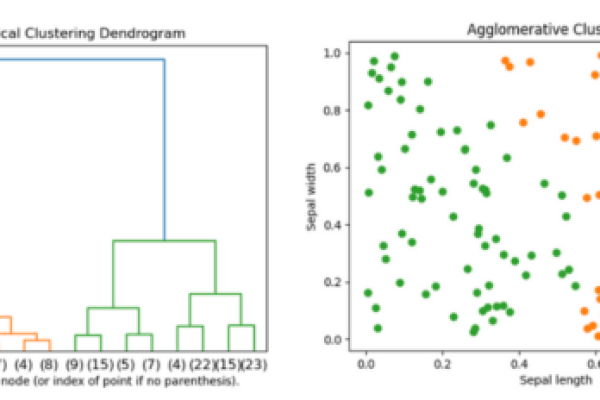

2、划分子空间:使用MapReduce程序将输入数据从空间划分为多个子空间,这一步的目的是将大规模数据分解成更小的数据块,以便后续在每个子空间中并行执行DBSCAN算法。

3、局部DBSCAN聚类:在每个子空间中,利用MapReduce模型中的Map任务执行局部的DBSCAN聚类,Map任务会读取子空间中的数据点,并根据DBSCAN算法的核心思想(即基于密度的聚类)找出相邻的点。

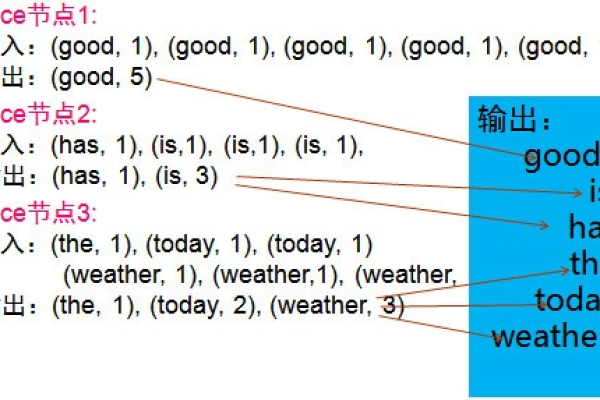

4、合并局部聚类结果:在Reduce阶段,将上一步中各个子空间的聚类结果进行合并,这一步是整个算法的关键,需要确保合并后的结果是全局一致的,合并过程中可能涉及到边界点的重新分配、噪声点的过滤以及不同子空间聚类的融合。

5、迭代优化:根据需要,可以对上述过程进行多次迭代,以优化聚类结果,每一次迭代都会根据上一次的聚类结果调整参数或重新划分子空间,以提高聚类的精度和效率。

6、输出最终结果:将最终的聚类结果输出到HDFS或其他存储系统中,供后续分析和使用。

示例代码

由于篇幅限制,这里只给出一个简化的MapReduce实现DBSCAN的示例代码框架:

// Mapper类

public class DBSCANMapper extends Mapper<LongWritable, Text, Text, Text> {

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 解析输入数据点

String[] parts = value.toString().split("\s+");

String pointId = parts[0];

double[] coordinates = new double[parts.length 1];

for (int i = 1; i < parts.length; i++) {

coordinates[i 1] = Double.parseDouble(parts[i]);

}

// 根据DBSCAN算法计算该点的邻居点

List<String> neighbors = findNeighbors(coordinates);

// 输出键值对,键为点ID,值为邻居点列表

for (String neighbor : neighbors) {

context.write(new Text(pointId), new Text(neighbor));

}

}

private List<String> findNeighbors(double[] coordinates) {

// 实现寻找邻居点的逻辑

return new ArrayList<>();

}

}

// Reducer类

public class DBSCANReducer extends Reducer<Text, Text, Text, Text> {

@Override

protected void reduce(Text key, Iterable<Text> values, Context context) throws IOException, InterruptedException {

// 收集所有邻居点

Set<String> neighbors = new HashSet<>(values);

// 输出聚类结果,键为点ID,值为所属簇ID或“Noise”

if (!neighbors.isEmpty()) {

context.write(key, new Text("Cluster_" + neighbors.iterator().next()));

} else {

context.write(key, new Text("Noise"));

}

}

}FAQs

Q1: MapReduce实现DBSCAN时如何保证数据的一致性?

A1: 在MapReduce实现DBSCAN时,保证数据一致性的关键在于合理设计Map和Reduce任务,以及确保在Reduce阶段正确合并局部聚类结果,可以通过以下方式来保证数据一致性:

在Map阶段,确保每个数据点都被正确处理,并且输出的键值对格式统一。

在Reduce阶段,采用合适的合并策略,如基于核心点的合并或基于边界点的合并,确保不同子空间的聚类结果能够无缝衔接。

如果需要,可以在Reduce阶段之后增加一个额外的MapReduce作业来进一步优化聚类结果。

Q2: MapReduce实现DBSCAN的性能瓶颈在哪里?如何优化?

A2: MapReduce实现DBSCAN的性能瓶颈主要在于以下几个方面:

数据划分不均如果数据划分不均,会导致某些Map任务处理时间过长,从而影响整体性能,可以通过优化数据划分策略来减少这种不均衡现象。

网络传输开销在Map和Reduce之间传输大量数据会增加网络负担,可以通过压缩数据传输、优化数据传输格式等方式来降低网络传输开销。

合并算法复杂度合并局部聚类结果是一个复杂的过程,可能会消耗大量计算资源,可以通过优化合并算法、采用更高效的数据结构等方式来提高合并效率。

为了优化MapReduce实现DBSCAN的性能,可以考虑以下措施:

使用更高效的数据划分算法,确保数据划分均匀。

在Map和Reduce之间使用压缩技术减少数据传输量。

优化合并算法,采用更高效的数据结构和算法来提高合并效率。

根据实际需求调整Map和Reduce任务的数量和并行度,以达到最佳的性能平衡。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/377858.html