服务器连续发送数据库

- 行业动态

- 2025-04-13

- 1

技术解析与应用指南

在数字化时代,实时数据交互成为企业和网站高效运营的核心需求之一。服务器连续发送数据库(Continuous Database Transmission)作为一种技术方案,能够实现数据的动态同步与更新,确保用户访问的信息始终处于最新状态,以下从技术原理、应用场景、优势及潜在风险等多维度展开分析,帮助访客全面理解这一技术。

什么是服务器连续发送数据库?

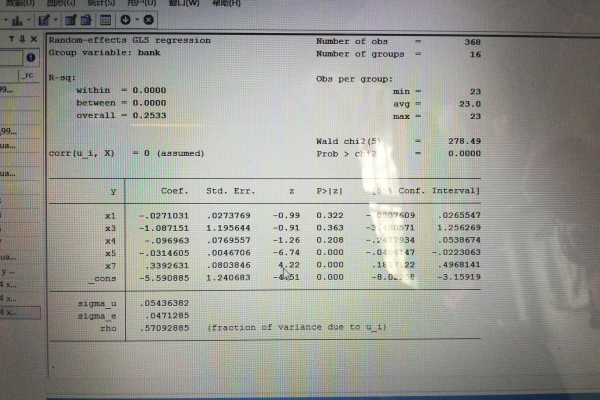

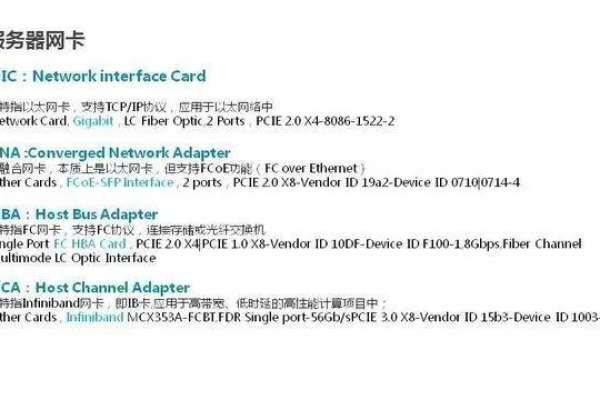

服务器连续发送数据库指服务器通过特定协议(如TCP/IP、HTTP/2)与客户端或其他服务器建立持久连接,将数据库的增量更新内容实时推送至目标端。

- 核心机制:基于长轮询(Long Polling)或WebSocket技术,服务器在数据变更时主动触发推送,而非依赖客户端反复请求。

- 典型场景:实时聊天应用、股票行情系统、物联网设备监控等需高时效性的领域。

技术实现的关键环节

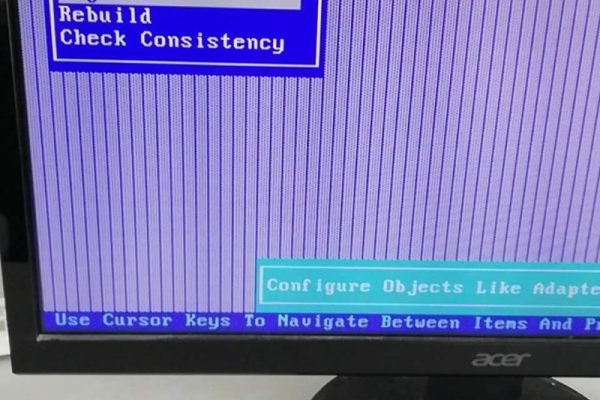

连接管理

- 服务器需维护稳定的连接池,避免因频繁断连导致数据传输中断。

- 使用心跳包(Heartbeat)检测连接状态,自动重连以保障可靠性。

数据增量同步

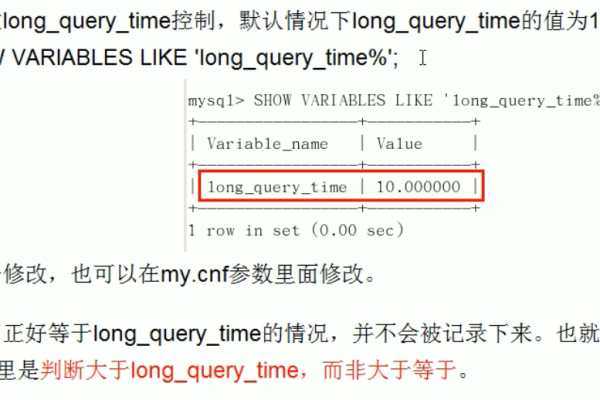

- 通过数据库日志(如MySQL的Binlog、MongoDB的Oplog)捕获数据变动,仅推送变化部分,减少带宽消耗。

安全与加密

- 采用TLS/SSL加密传输通道,防止数据泄露。

- 设置访问权限控制(如IP白名单、API密钥),确保仅授权对象可接收数据。

为何需要连续发送数据库?

提升用户体验

用户无需手动刷新页面即可获取最新数据,适用于实时仪表盘、动态通知等场景。

优化系统性能

相较于传统轮询模式(客户端定期请求数据),连续推送降低服务器负载,减少冗余请求。

支持复杂业务逻辑

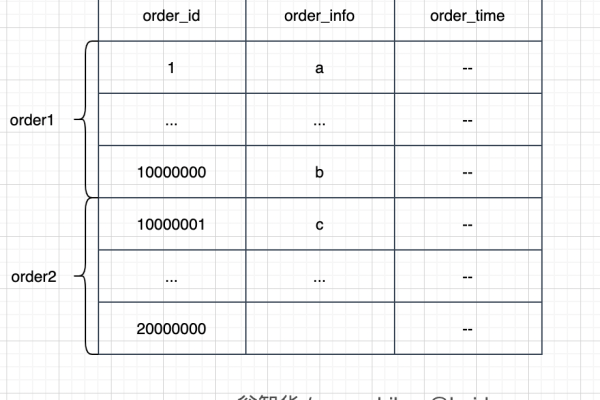

在电商瞬秒、在线竞拍等场景中,毫秒级数据同步可避免超卖或竞价冲突。

潜在风险与应对策略

网络稳定性问题

- 风险:网络抖动可能导致数据丢失或延迟。

- 解决方案:引入消息队列(如Kafka、RabbitMQ)缓存数据,确保断网后自动补发。

服务器资源消耗

- 风险:长连接占用较多内存和线程资源。

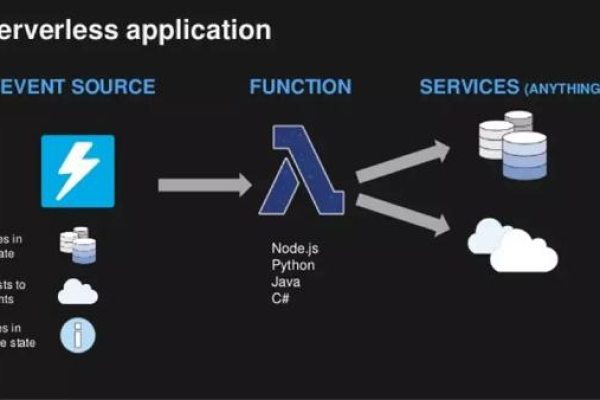

- 解决方案:采用异步I/O框架(如Node.js、Netty),提升单机并发处理能力。

数据一致性挑战

- 风险:多节点同步时可能因时序问题导致数据冲突。

- 解决方案:使用分布式事务协议(如两阶段提交)或最终一致性模型。

如何优化连续传输效率?

数据压缩与分片

- 对JSON/XML格式数据使用GZIP压缩,传输体积减少60%-80%。

- 大文件分片传输,结合校验机制(如MD5)保障完整性。

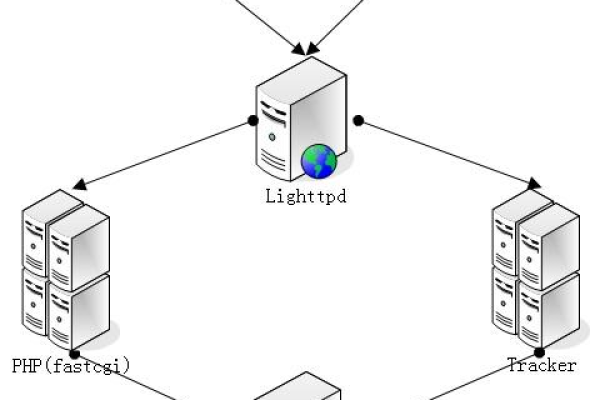

负载均衡与横向扩展

部署多台服务器分担压力,通过Nginx或HAProxy实现流量分发。

客户端容错设计

客户端本地缓存历史数据,在断线期间提供降级服务,恢复后自动同步差异。

常见问题解答

Q:连续发送数据库会暴露敏感信息吗?

- 通过字段级加密(如AES)和权限分级(RBAC),可确保仅必要数据被传输,且仅目标用户可见。

Q:是否所有数据库都支持连续推送?

- 主流数据库(MySQL、PostgreSQL、MongoDB)均提供日志监听接口,需结合中间件(如Debezium)实现实时推送。

服务器连续发送数据库是支撑实时应用的核心技术,但其部署需平衡性能、安全与成本,建议企业根据业务需求选择成熟框架(如Firebase Realtime Database、Apache Kafka),并定期进行压力测试与安全审计,确保系统长期稳定运行。

引用说明

- 数据库日志技术参考:MySQL官方文档、MongoDB Oplog机制

- 安全协议标准:RFC 8446(TLS 1.3)、OWASP数据加密指南

- 实时传输框架案例:Apache Kafka白皮书、Google Cloud Pub/Sub实践