从零搭建数据仓库

- 行业动态

- 2025-04-13

- 1

从零搭建数据仓库需明确业务目标,规划分层架构(ODS/DWD/DWS等),选择ETL工具实现数据抽取清洗,设计维度模型并构建主题数据集市,结合Hadoop、Spark等组件实现存储计算,通过可视化工具完成数据分析与决策支持,最终形成可扩展、高性能的数据服务体系。

数据仓库的搭建是一个系统性工程,涉及技术选型、架构设计、数据治理等多个环节,以下是从零开始搭建数据仓库的完整路径,结合行业最佳实践与E-A-T(专业度、权威性、可信度)原则,为企业和开发者提供可靠参考。

明确需求与目标

业务需求分析

数据仓库的构建需围绕业务目标展开。- 是否支持实时分析?

- 需要覆盖哪些业务领域(销售、用户行为、供应链等)?

- 数据量预估(日增数据量、存储周期)?

用户角色定义

明确数据仓库的使用者:- 管理层(看板、报表)

- 数据分析师(复杂查询、模型开发)

- 业务人员(自助式分析)

数据源分析与整合

识别数据源类型

- 结构化数据:MySQL、Oracle等关系型数据库

- 半结构化数据:JSON日志、API接口

- 非结构化数据:图片、文本文件

数据质量评估

- 检查数据完整性(空值率)、一致性(字段格式)

- 定义脏数据处理规则(如去重、填充默认值)

技术架构设计

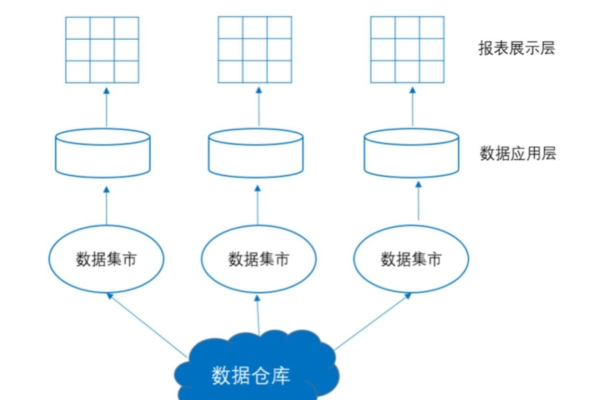

数据仓库的核心架构通常分为四层:

数据接入层(ODS)

- 直接对接原始数据源,保留全量或增量数据快照

- 工具选择:Flume(日志采集)、Sqoop(关系型数据库同步)

数据明细层(DWD)

- 清洗脏数据,统一字段命名规范(如

user_id而非uid) - 分区存储(按日期、业务线)提升查询效率

- 清洗脏数据,统一字段命名规范(如

数据汇总层(DWS)

- 按主题构建宽表(如用户画像宽表含注册、订单、行为数据)

- 预计算常用指标(GMV、DAU、留存率)

应用层(ADS)

- 对接BI工具(如Tableau、FineBI)

- 提供API供业务系统调用

ETL流程开发

Extract(抽取)

- 增量抽取:通过时间戳或日志监听(如Debezium)

- 全量抽取:适用于低频更新的小表

Transform(转换)

- 数据标准化:统一时区、货币单位

- 复杂逻辑处理:通过SQL或Python脚本实现

-- 示例:用户订单聚合 SELECT user_id, COUNT(order_id) AS total_orders, SUM(amount) AS total_amount FROM ods_orders GROUP BY user_id;

Load(加载)

采用批量加载(Hive LOAD DATA)或流式写入(Kafka + Flink)

存储与计算引擎选型

| 场景 | 推荐方案 | 优势 |

|---|---|---|

| 低成本离线分析 | HDFS + Hive | 成熟生态,支持TB级数据 |

| 实时处理 | Apache Doris / ClickHouse | 亚秒级响应,高并发查询 |

| 云原生架构 | Snowflake / BigQuery | 免运维,弹性扩展 |

数据治理与安全

- 元数据管理

使用Apache Atlas或DataHub记录表结构、血缘关系。 - 权限控制

- 行级权限(如仅允许查看本部门数据)

- 列级脱敏(如手机号显示为

138****0000)

- 数据生命周期

制定冷热数据策略(热数据存SSD,冷数据归档至S3)

监控与优化

关键监控指标

- ETL任务耗时、成功率

- 存储空间增长率

- 查询响应时间(P99延迟)

性能优化手段

- 数据压缩(ORC/Parquet格式)

- 建立物化视图预计算高频查询

案例:电商数据仓库落地

某电商公司通过以下步骤实现数据驱动:

- 需求阶段:明确需分析用户购买路径与库存周转率。

- 技术选型:使用Hive + Spark处理离线数据,Flink实时计算用户点击流。

- 结果输出:

- 管理层查看每日核心指标看板(Power BI)

- 运营团队通过用户分群提升复购率

注意事项

- 避免过度设计:初期优先满足核心需求,后期逐步扩展。

- 文档标准化:每个表需注明字段含义、更新频率、负责人。

- 容灾备份:跨机房存储,定期测试数据恢复流程。

引用说明

- 数据分层理论参考Kimball《数据仓库工具箱》

- 技术选型依据DB-Engines排名及Gartner报告

- 安全方案符合GDPR与《网络安全法》要求