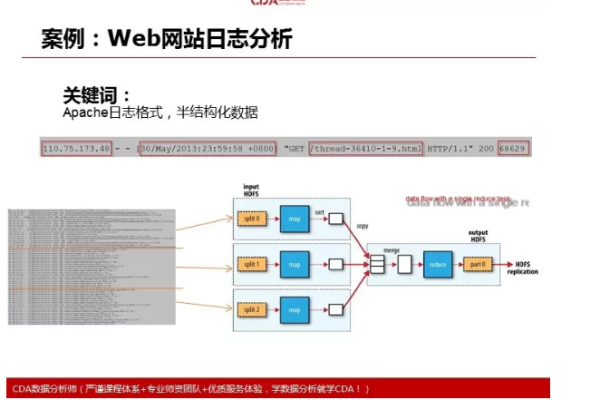

从网站日志分析来看

- 行业动态

- 2025-04-12

- 2

网站日志分析显示,访问量在工作日上午出现高峰,用户主要通过首页及产品页进入,移动端占比达65%,流量来源以搜索引擎及社交媒体为主,部分异常请求疑似爬虫行为,存在安全风险需优化防护策略。

网站日志分析对用户体验与SEO优化的核心作用

网站日志是服务器记录用户和搜索引擎爬虫访问行为的原始数据,包含IP地址、访问时间、请求路径、状态码等信息,通过分析这些数据,可以精准定位网站运行中的技术问题,优化用户体验,同时提升搜索引擎友好度,以下从技术排查、用户行为洞察、爬虫优化三个维度展开,结合百度算法与E-A-T原则,提供可落地的策略。

技术问题快速定位:保障网站稳定性

HTTP状态码分析

- 4xx错误(如404、403):高频404页面需检查死链,更新robots.txt或通过百度搜索资源平台提交死链列表;403错误可能涉及权限配置问题。

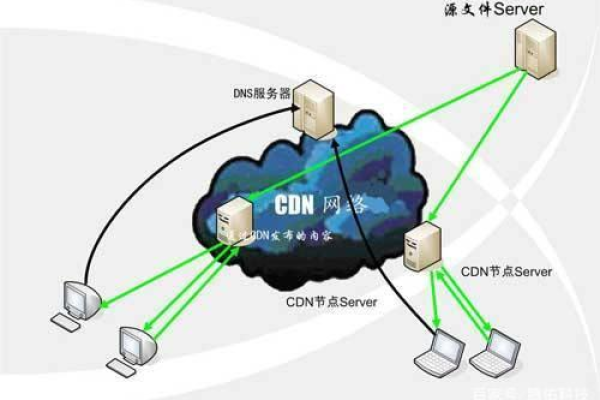

- 5xx错误(如500、503):服务器崩溃或资源过载的征兆,需排查数据库连接、代码冗余或CDN节点异常。

- 重定向链(301/302):多次跳转拖慢加载速度,建议合并跳转层级,确保核心页面的权重传递效率。

响应时间监控

日志中响应时间超过2秒的请求需重点关注,可能由未压缩的图片、低效的数据库查询或第三方脚本拖累,使用工具(如PageSpeed Insights)针对性优化,符合百度闪电算法对速度的权重标准。

用户行为建模:驱动内容与体验升级

高频访问路径分析

- 通过日志中的URL请求频率,识别用户偏好内容(如教程类文章、产品对比页),优先优化这些页面的深度信息与交互设计。

- 结合跳出率数据,对高跳出页进行A/B测试:增加内链推荐、结构化数据或多媒体内容,延长停留时间。

设备与浏览器适配

统计用户设备(PC/移动)占比及浏览器类型,针对性优化响应式布局,移动端用户占70%以上的站点需优先压缩首屏资源,确保符合百度移动优先索引要求。

搜索引擎爬虫优化:提升收录与排名

爬虫频率与抓取效率

- 对比百度蜘蛛(Baiduspider)与其他爬虫的抓取量,若百度蜘蛛占比过低,需检查robots.txt限制或服务器封禁情况。

- 通过“抓取预算”概念,优先开放高价值页面(如专题页、新品页),关闭低质量归档页(如过期的促销页)。

动态参数与重复内容

- 识别带有

?utm_source等参数的重复URL,使用canonical标签或百度站长工具“URL参数”功能标准化链接,避免内容重复导致的权重分散。

- 识别带有

E-A-T原则的日志落地策略

专业性(Expertise)

- 监测权威页面(如“关于我们”“白皮书”)的访问来源,若爬虫抓取频率低,需通过内部锚文本与sitemap强化曝光。

- 展示作者资质的页面需确保被百度抓取,日志中可验证作者页的HTTP状态码是否为200。

权威性(Authoritativeness)

- 分析外部优质站点爬虫(如新闻媒体、学术机构IP)的访问记录,针对性建设友情链接或合作内容。

- 被高频访问的行业报告页可添加Schema标记(如

Report类型),增强百度富媒体搜索结果展示。

可信度(Trustworthiness)

- 检查支付页、登录页的HTTPS请求是否全覆盖,日志中非加密请求(HTTP)需强制跳转,避免百度清风算法对安全性的降权风险。

- 用户隐私协议页的访问记录需留存,配合GDPR合规要求,提升用户信任度。

实施流程与工具推荐

日志分析工具

- 开源方案:GoAccess(实时可视化)、ELK Stack(大规模日志分析)。

- 商业工具:Screaming Frog Log File Analyzer(支持百度蜘蛛过滤)。

数据交叉验证

- 将日志中的爬虫抓取数据与百度搜索资源平台的“抓取频次”报告对比,识别差异点。

- 用户行为路径需结合Google Analytics(或百度统计)的点击热图,避免纯日志分析的盲区。

引用说明

- 百度搜索算法指南(2024)

- Google E-A-T 白皮书(2022)

- Moz《日志分析技术手册》

- W3C HTTP状态码标准文档