Databricks数据洞察特点

- 行业动态

- 2025-04-13

- 2

Databricks数据洞察是基于Apache Spark的统一分析平台,提供云端托管服务,支持多数据源整合与实时处理,其核心优势在于协作式交互分析、高性能计算优化及自动化集群管理,内置Delta Lake保证数据可靠性,集成MLflow简化机器学习全流程,助力企业快速构建数据湖仓,实现大规模数据处理、AI建模与智能决策,降低运维复杂度并提升团队协作效率。

Databricks数据洞察特点

作为全球领先的一体化数据分析平台,Databricks凭借其技术创新和行业实践,成为企业实现数据驱动决策的核心工具之一,其数据洞察能力尤其受关注,以下是其核心特点的详细解析:

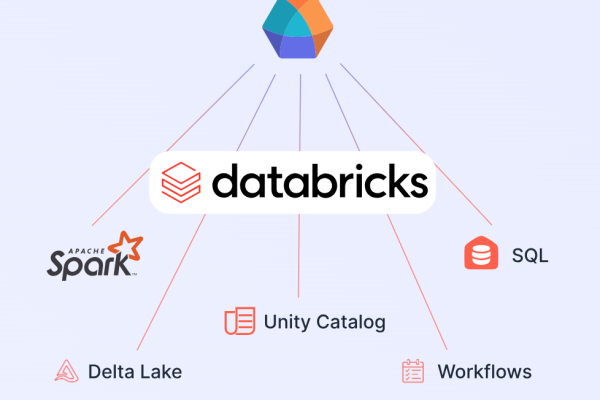

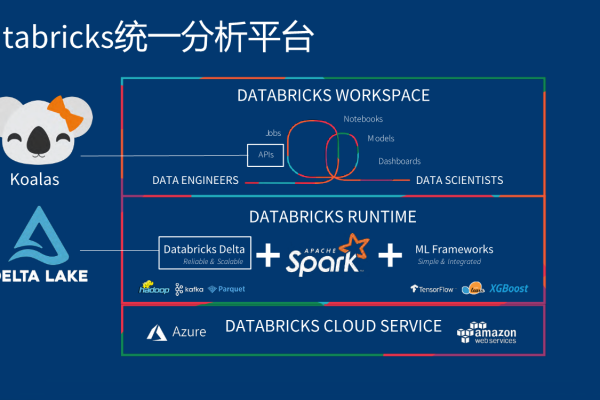

统一的数据分析平台

Databricks以Lakehouse架构为基础,结合了数据湖的灵活性与数据仓库的高性能,支持从原始数据到高级分析的端到端流程,用户无需在多个工具间切换,即可完成数据摄取、清洗、分析、机器学习及可视化,显著提升效率。

- 支持多数据源:无缝集成结构化、半结构化和非结构化数据。

- 简化数据治理:通过统一的元数据管理层,确保数据的一致性和可追溯性。

高性能的实时处理能力

Databricks通过Delta Engine和Photon引擎技术,大幅优化数据处理速度:

- 实时流处理:支持Apache Spark Structured Streaming,实现毫秒级延迟的实时数据分析。

- 交互式查询:复杂的SQL查询可在数秒内返回结果,适用于BI工具对接和即席分析场景。

深度集成机器学习与AI

Databricks为数据科学家提供端到端的MLOps支持,覆盖从实验到生产的全生命周期:

- MLflow集成:简化模型开发、部署和监控,支持多框架(TensorFlow、PyTorch等)。

- AutoML功能:自动化特征工程、模型选择和超参数调优,降低AI应用门槛。

高效的团队协作能力

平台围绕协作设计,支持跨角色(数据工程师、分析师、科学家)的协同工作:

- 共享工作区:通过Notebook、Dashboard共享代码、可视化结果和文档。

- 版本控制:集成Git,确保代码、数据和模型版本的可追溯性。

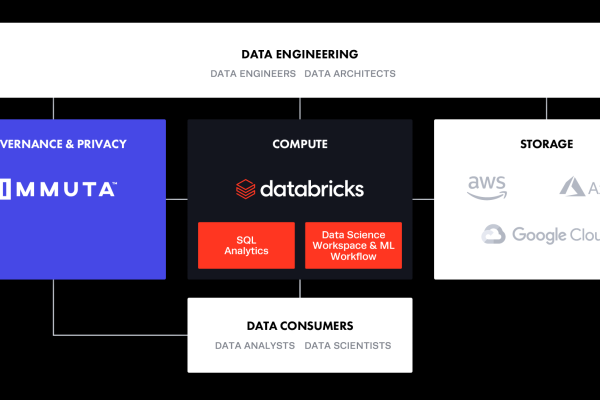

云端原生与弹性扩展

Databricks深度集成主流云服务(AWS、Azure、GCP),提供Serverless架构:

- 弹性资源调度:根据负载自动扩展计算资源,避免资源浪费。

- 按需付费模式:企业仅为实际使用的计算和存储资源付费,降低TCO(总拥有成本)。

企业级安全与合规

Databricks通过零信任安全模型满足严格的企业合规要求:

- 数据加密:支持传输和静态数据的端到端加密。

- 精细化权限控制:基于角色的访问控制(RBAC),细粒度到表、列级别。

- 合规认证:符合GDPR、HIPAA、SOC 2等全球主流合规标准。

成本优化与资源管理

通过智能优化技术,Databricks帮助企业降低数据洞察成本:

- 自动调优:动态调整集群规模,优化资源利用率。

- 成本监控工具:提供实时资源消耗分析,支持预算预警和优化建议。

为什么选择Databricks?

- 行业认可:Gartner连续多年将其评为“数据分析与机器学习平台领导者”。

- 开源开放:基于Apache Spark、Delta Lake等开源技术,避免厂商锁定风险。

- 规模化实践:已被全球超万家企业采用,覆盖金融、零售、制造等高数据密度行业。

引用说明 参考自:

- Databricks官方技术文档(https://docs.databricks.com/)

- Gartner《2024云数据库管理系统魔力象限报告》

- Apache Spark社区技术白皮书