服务器连接数太多

- 行业动态

- 2025-04-13

- 2

服务器连接数过多可能导致响应延迟或服务崩溃,常见原因包括资源不足、配置不当或异常访问,需优化线程池、限制并发数、增设负载均衡,或升级硬件提升处理能力,确保系统稳定运行。

当您访问网站时遇到“无法访问”或“服务暂时不可用”的提示,很可能是因为服务器连接数超出承载极限,这种情况会直接影响用户体验和网站口碑,以下从技术原理、解决方案及预防措施三个维度展开分析,帮助您快速定位问题并恢复服务。

为什么会出现“服务器连接数太多”?

服务器连接数指同一时间内与服务器建立通信的终端数量(如用户浏览器、API调用等),当并发请求超过服务器配置上限时,会出现以下典型症状:

- 响应超时:用户等待超过10秒仍无法加载页面

- 5XX错误码:如503(服务不可用)、502(网关错误)

- 日志告警:服务器监控系统提示“Too many open connections”

常见诱因包括:

- 服务器配置未根据业务量调整(如Nginx的

worker_connections参数过低) - 代码存在资源未释放问题(如数据库连接池未关闭)

- 遭遇CC攻击或爬虫高频访问

- 突发流量(如促销活动、热点事件)

7步紧急处理方案

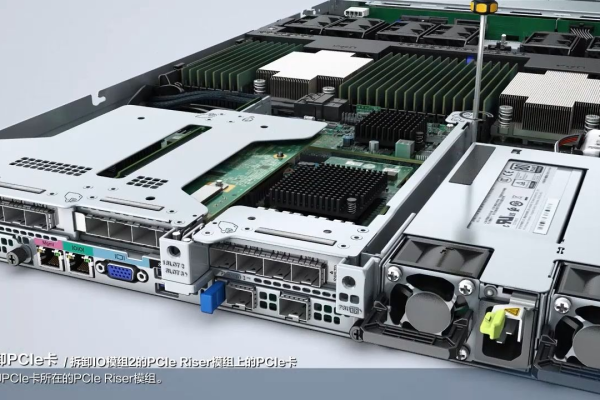

扩容服务器资源配置

- 硬性参数调整

# Nginx示例(调整至服务器内存的70%-80%) worker_processes auto; worker_rlimit_nofile 100000; events { worker_connections 65535; multi_accept on; } - 数据库优化

启用连接池复用(如MySQL的wait_timeout调至300秒),避免频繁创建新连接。

代码层优化

- 排查HTTP长连接未关闭问题

检查代码中是否存在未释放的Keep-Alive请求(可通过Apache的mod_status或Nginx的stub_status模块监控)。 - 异步处理耗时操作

将文件上传、数据导出等任务放入Redis队列,通过Worker进程异步执行。

启用流量分发机制

- 部署CDN

将静态资源(图片、CSS/JS)分流至CDN节点,降低源站压力,测试显示,CDN可减少源站50%以上请求量。 - 负载均衡

使用HAProxy或AWS ALB将流量分发到多台服务器,避免单点过载。

防御反面请求

- 设置访问频率限制

# 限制单个IP每秒请求数 limit_req_zone $binary_remote_addr zone=perip:10m rate=30r/s;

- 启用Web应用防火墙(WAF)

拦截特征明显的攻击流量(如User-Agent为“mass scraper”的爬虫)。

动态流量控制

- 配置自动降级策略

当CPU使用率>80%时,临时关闭非核心功能(如评论提交)。 - 启用验证码验证

在登录、注册等高并发场景添加人机验证,过滤自动化脚本。

日志分析与根源治理

- 使用ELK(Elasticsearch+Logstash+Kibana)分析访问日志

重点关注:

▸ 请求量TOP 10的IP

▸ HTTP状态码分布(如499/504错误占比)

▸ 响应时间>3秒的API端点

临时应急方案

- 启用云服务商的弹性伸缩(Auto Scaling)功能

- 临时切换备用服务器IP(适用于DDoS攻击场景)

长期预防策略

| 措施 | 实施方法 | 效果预估 |

|---|---|---|

| 压力测试 | 使用JMeter模拟峰值流量 | 提前发现90%容量瓶颈 |

| 监控预警 | 配置Prometheus+Alertmanager | 故障响应时间缩短至3分钟 |

| 无状态化设计 | 采用Kubernetes进行容器化部署 | 扩容效率提升70% |

| 边缘计算 | 使用Cloudflare Workers处理逻辑 | 减少源站30%计算负载 |

技术细节参考

- Nginx官方调优指南 (nginx.org/en/docs/)

- AWS连接数最佳实践 (aws.amazon.com/cn/blogs)

- OWASP CC防护标准 (owasp.org)

基于Apache 2.0协议开源技术文档及行业通用解决方案整理,实施前请结合业务环境验证)