从网站抓取数据软件

- 行业动态

- 2025-04-14

- 2

网络数据抓取软件可自动采集网页内容并转换为结构化数据,支持批量处理与定时更新,常用工具包括Python的Scrapy、BeautifulSoup框架,以及八爪鱼、火车采集器等可视化工具,适用于市场调研、舆情监控和学术研究,使用时需遵守平台协议与数据安全法规。

在数字化时代,网站数据抓取(Web Scraping)成为企业及个人获取信息的重要手段,选择合适的工具并合规操作需兼顾技术、法律与伦理,以下从技术工具、选择建议、法律风险及最佳实践角度详细解析。

常见的网站数据抓取工具

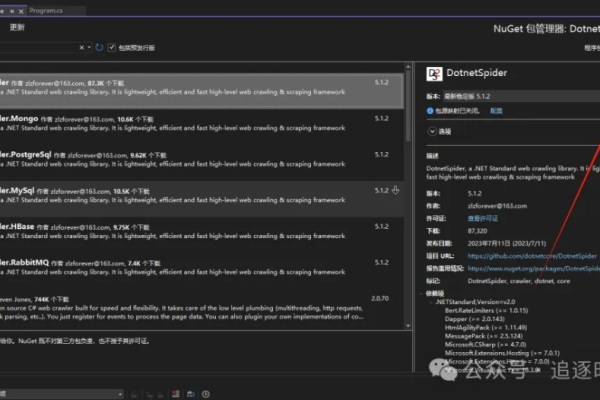

Scrapy(Python框架)

- 特点:开源、模块化设计,支持异步处理和大规模数据抓取。

- 适用场景:电商价格监控、新闻聚合等结构化数据提取。

- 优势:社区活跃,扩展性强;可集成代理IP和验证码破解插件。

- 局限:需Python编程基础,对动态渲染页面(如JavaScript加载内容)支持较弱。

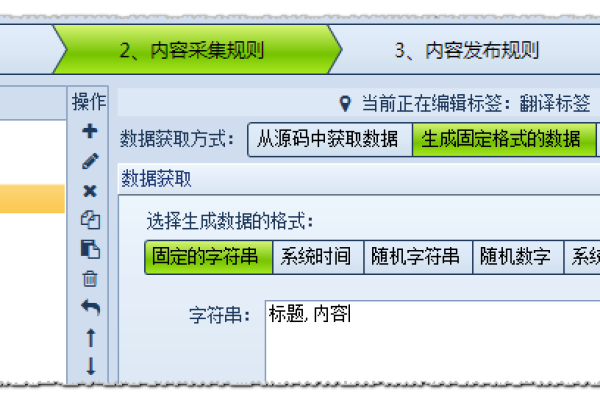

Octoparse(可视化工具)

- 特点:无需编码,通过拖拽操作定义抓取规则,支持云服务器部署。

- 适用场景:社交媒体数据采集、竞品分析等非技术用户需求。

- 优势:内置反爬策略(如随机延迟),支持导出Excel、JSON等格式。

- 局限:免费版功能受限,复杂页面需定制规则。

Apify(云平台)

- 特点:基于云的自动化抓取服务,提供预构建模板(如Amazon产品爬虫)。

- 适用场景:企业级数据采集、API集成。

- 优势:支持动态页面渲染(Headless Chrome),自动处理分页和验证码。

- 局限:按用量计费,成本较高。

Beautiful Soup(Python库)

- 特点:轻量级HTML/XML解析库,常与Requests库配合使用。

- 适用场景:小型项目或教学用途。

- 优势:学习成本低,灵活性强。

- 局限:需自行处理反爬机制,不适合复杂任务。

选择工具的核心考量

- 合规性:遵守目标网站的

robots.txt协议,避免抓取个人隐私或版权内容。 - 技术门槛:非技术人员优先选可视化工具(如Octoparse);开发者可选Scrapy或自定义脚本。

- 反爬应对能力:动态IP池、请求头随机化、验证码识别等功能直接影响成功率。

- 数据存储与处理:是否支持直接导出至数据库(如MySQL)或大数据平台(如Hadoop)。

- 成本:开源工具免费但需自建架构;云服务省时但按需付费。

法律风险与伦理规范

法律边界

- 违反《计算机信息系统安全保护条例》可能面临民事索赔或行政处罚。

- 欧盟《通用数据保护条例(GDPR)》要求抓取个人数据需获用户明确同意。

伦理建议

- 限制频率:设置合理抓取间隔(如每秒1次),避免影响目标网站正常运营。

- 数据用途:仅用于分析或公益目的,禁止商业化转卖。

- 明确声明:在抓取结果中标注数据来源,尊重原作者权益。

最佳实践指南

前期调研

- 检查目标网站的API接口,优先使用官方提供的数据源。

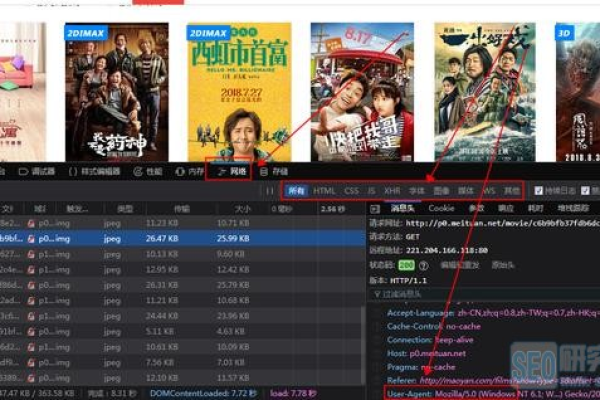

- 使用

Wappalyzer工具分析网站技术栈,针对性选择抓取方案。

规避反爬

- 轮换User-Agent和IP地址(推荐使用住宅代理而非数据中心IP)。

- 模拟人类行为:随机滚动页面、点击延迟、鼠标移动轨迹。

数据清洗与验证

- 去重:利用哈希算法(如MD5)排除重复条目。

- 异常检测:设定阈值过滤错误格式或超出范围的数据。

长期维护

- 监控脚本运行状态,定期更新规则以适应网站改版。

- 日志记录:保存抓取时间、数据量及错误信息,便于审计优化。

专家建议

- 技术层面:优先使用分布式架构(如Apache Nutch)应对大规模抓取任务。

- 法律层面:咨询专业律师,制定数据抓取合规手册。

- 伦理层面:遵循“最少必要原则”,仅抓取业务必需的数据字段。

参考文献

- Scrapy官方文档:https://scrapy.org

- 欧盟GDPR条款:https://gdpr-info.eu

- 中国网络安全法全文:http://www.cac.gov.cn

- Apache Nutch项目:https://nutch.apache.org