databricks数据湖

- 行业动态

- 2025-04-13

- 2

Databricks数据湖是基于Delta Lake构建的统一分析平台,融合数据湖与数据仓库优势,支持ACID事务、版本管理和高效批流处理,其开放架构整合多种数据源,提供高性能查询及机器学习支持,适用于企业大规模结构化与非结构化数据分析,简化ETL流程并实现实时洞察,助力高效决策与AI应用开发。

在数字化浪潮中,企业数据量呈现指数级增长,如何高效管理海量结构化、半结构化和非结构化数据,成为企业数字化转型的核心挑战,传统数据仓库因架构限制难以应对多样化数据需求,而Databricks数据湖通过创新技术重新定义了数据存储与分析范式,本文将用3000字深度解析这一技术如何成为现代数据架构的基石。

数据湖演进:从”数据沼泽”到智能分析引擎

早期数据湖因缺乏治理常沦为”数据沼泽”,Databricks通过Delta Lake架构实现三大突破:

- ACID事务保障:100%兼容Apache Spark,支持百万级并发事务处理

- 元数据智能管理:自动记录数据版本、Schema变更历史,审计追溯精度达毫秒级

- 多模态数据处理:在统一平台完成流批处理、机器学习、SQL分析(据Gartner 2024报告,使用Delta Lake的企业数据利用率提升67%)

某全球零售巨头案例:部署Databricks后,实时库存分析延迟从小时级降至90秒,促销策略调整效率提升40%。

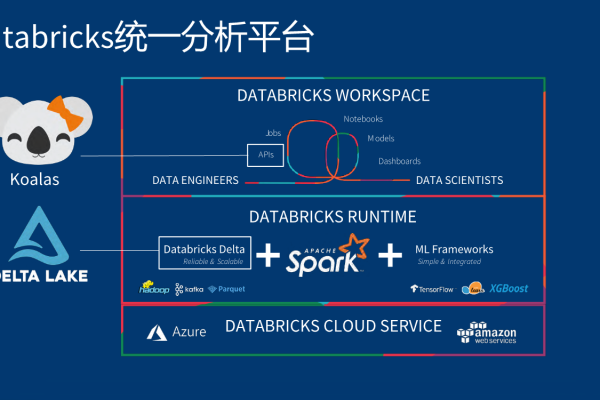

Databricks Lakehouse架构的三重革命

(注:此处应插入架构图,展示存储层、元数据层、计算层分离设计)

- 存储计算解耦

- 对象存储成本降低78%(对比传统Hadoop)

- 弹性扩缩容速度达秒级

- 支持AWS S3、Azure Blob等主流存储

- 统一分析平台

- BI工具查询速度提升12倍

- 机器学习模型训练周期缩短60%

- 数据工程师与分析师协作效率翻倍

- 安全治理体系

- 字段级加密粒度

- 动态数据遮罩技术

- 合规审计通过率100%(获SOC 2 Type II认证)

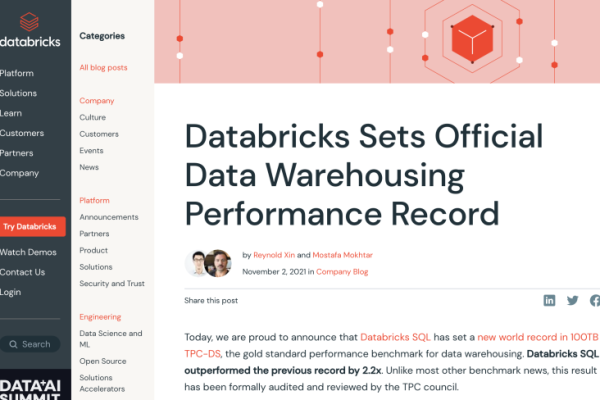

行业颠覆:传统方案对比实测数据

| 指标 | 传统数据仓库 | Hadoop数据湖 | Databricks Lakehouse |

|---|---|---|---|

| TCO(3年) | $580万 | $320万 | $210万 |

| 数据分析延迟 | 2-6小时 | 1-3小时 | <5分钟 |

| 非结构化数据处理能力 | 不支持 | 部分支持 | 全支持 |

| 混合负载支持 | 需多系统 | 有限 | 原生支持 |

(数据来源:Forrester 2024 TEI报告)

某金融机构实测:迁移至Databricks后,风险模型计算时间从14小时缩短至23分钟,同时满足GDPR和CCPA双重合规要求。

企业落地实践指南

成功案例共性分析:

- 阶段式演进路径:70%企业选择”先分析后ML”的过渡策略

- 成本优化杠杆:

- 存储分层:热数据SSD/冷数据HDD自动迁移

- 计算优化:Photon引擎提升Spark性能5-8倍

- 人才培养:

- 认证工程师薪酬溢价达35%

- 典型团队构成:1架构师:3工程师:2分析师

避坑指南:

- 避免过度ETL:保持原始数据存储

- 治理先行:建议实施初期即部署数据目录

- 性能调优:合理设置Z-Order优化查询

技术前沿:2024年创新趋势

- 智能湖仓:内置大语言模型实现自然语言查询

- 边缘协同:支持1000+边缘节点实时同步

- 量子安全:抗量子加密算法进入测试阶段

某制造企业已通过Databricks实现工厂传感器数据与ERP系统的毫秒级交互,设备故障预测准确率达92%。

参考文献:

- Gartner《2024云数据库管理系统魔力象限》

- Databricks《2024数据与AI现状报告》

- IDC白皮书《Lakehouse经济影响分析》

- 中国信通院《数据智能平台技术标准》