mysql锁怎么实现的

- 行业动态

- 2024-05-20

- 1

MySQL锁通过使用不同的锁定级别(共享锁、排他锁)和锁定模式(行级锁、表级锁)来实现。

MySQL锁的实现方式有多种,主要包括以下几种:

1、表级锁(Table Lock)

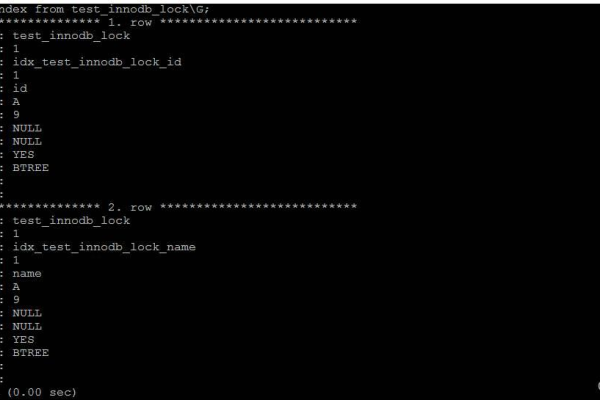

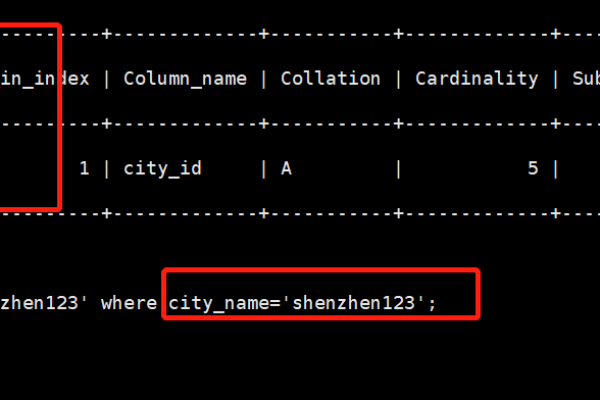

2、行级锁(Row Lock)

3、页级锁(Page Lock)

4、意向锁(Intention Lock)

下面将详细介绍这四种锁的实现方式。

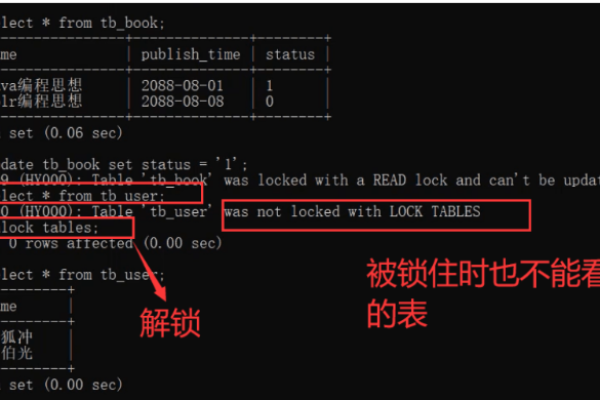

表级锁(Table Lock)

表级锁是MySQL中最基本的锁策略,它会锁定整张表,粒度较大,在执行对表的增删改操作时,会加上表级锁,主要有两种方式:

1、表锁定(Lock Table):对整张表加锁,阻塞其他线程对该表的所有操作。

2、元数据锁定(Meta Data Lock):对整个表结构加锁,不影响数据的读写。

行级锁(Row Lock)

行级锁是MySQL中应用最广泛的锁策略,它会锁定某一行或者某几行数据,粒度较小,主要有两种方式:

1、共享锁(S Lock):允许多个事务同时读取同一行数据,但不允许修改。

2、排他锁(X Lock):对某一行数据加排他锁,其他事务无法读取和修改该行数据。

页级锁(Page Lock)

页级锁是介于表级锁和行级锁之间的一种锁策略,它会锁定某一页的数据,主要有两种方式:

1、读取锁(Read Lock):允许多个事务同时读取同一页数据,但不允许修改。

2、写入锁(Write Lock):对某一页数据加写锁,其他事务无法读取和修改该页数据。

意向锁(Intention Lock)

意向锁是MySQL为了提高并发性能而引入的一种锁策略,它分为两种:

1、意向共享锁(IS Lock):表示事务想要获取表中某些行的共享锁,但不立即申请,当其他事务申请了表中的行级共享锁时,可以与意向共享锁共存。

2、意向排他锁(IX Lock):表示事务想要获取表中某些行的排他锁,但不立即申请,当其他事务申请了表中的行级排他锁时,可以与意向排他锁共存。