如何在Linux中实现数字和字母的切割?

- 行业动态

- 2024-09-17

- 8

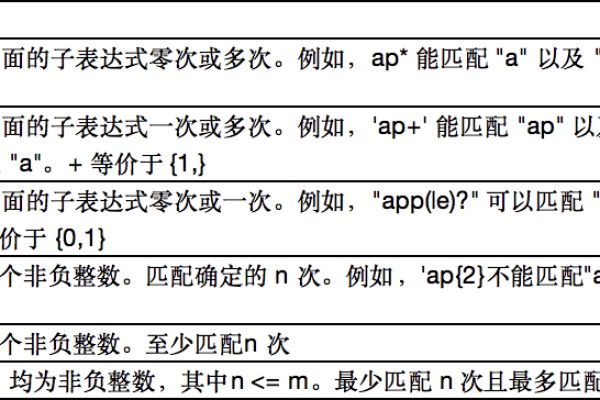

grep命令配合正则表达式来切割数字和字母。如果要从文本文件中提取所有数字,可以使用以下命令:,,“ bash,grep o '[09]+' 文件名,` ,,同样,如果要提取所有字母,可以使用以下命令:,,` bash,grep o '[azAZ]+' 文件名,“

在Linux系统中,处理文本数据是常见的任务之一,特别是在数据分析和系统管理中,本文将聚焦于使用Linux命令行工具切割数字和字母,探索不同的方法和实践技巧,通过深入理解这些工具的使用,用户可以更有效地处理和分析文本数据。

基本命令介绍

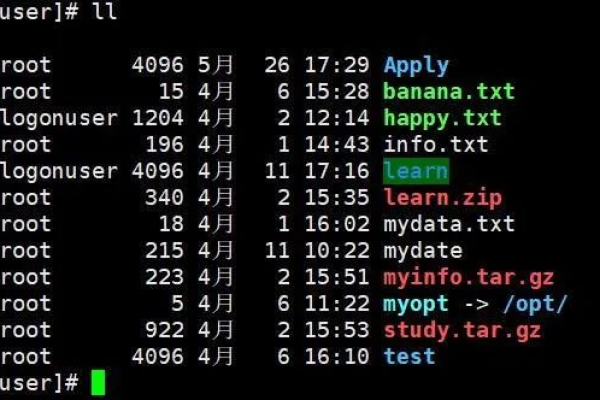

1、cut命令:cut命令是Linux下常用的文本处理工具之一,特别适用于按字段提取文本,它支持按字节(b)或字符(c)偏移量进行文本分割。cut b 15 file.txt命令从file.txt文件提取第1个字节到第5个字节的内容,这个命令对于处理固定格式的文本数据非常有用。

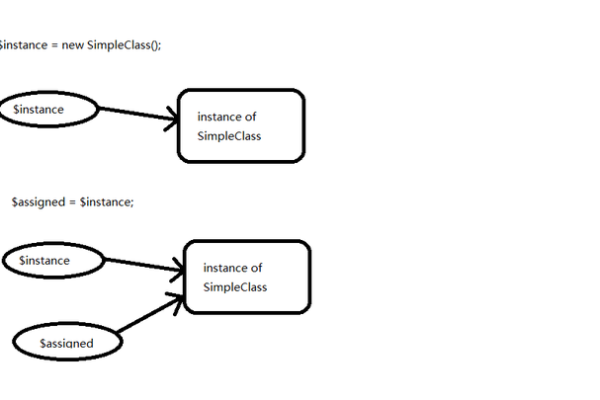

2、awk工具:awk是一个强大的文本分析工具,它能够以更为复杂的方式处理文本数据,使用awk,可以方便地进行字符串分割、基于模式的文本匹配等高级操作,命令echo "ceph_12.2.1.centos.x86_64.tar.gz2021100808" | awk '{split($1, arr, ""); print arr[5]}'实现了以""为分隔符的分割,并提取分割后的第五个元素。

3、tr指令:tr是另一个在文本处理中经常使用的Linux命令,主要用于字符替换或删除,虽然tr不直接支持文本分割,但它在处理特定字符替换后结合其他工具使用时非常有用,在某些情况下,可能需要先使用tr将特定字符替换,然后再利用cut或awk进行分割。

高级文本处理

1、分割与提取:在许多实际场景中,简单的按字节或按字符分割可能无法满足需求,此时可以利用awk的分割功能,对文本进行更细致的处理,在日志文件中,常常需要根据特定的分隔符(如逗号、破折号)提取信息。

2、字符串操作:除了使用命令行工具外,Linux下的Shell脚本也能执行复杂的字符串操作,通过Shell变量和内置指令,可以在不调用外部程序的情况下完成一些基本的字符串分割和提取任务。

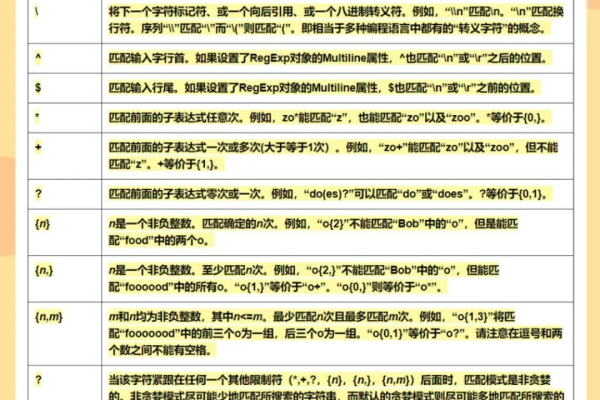

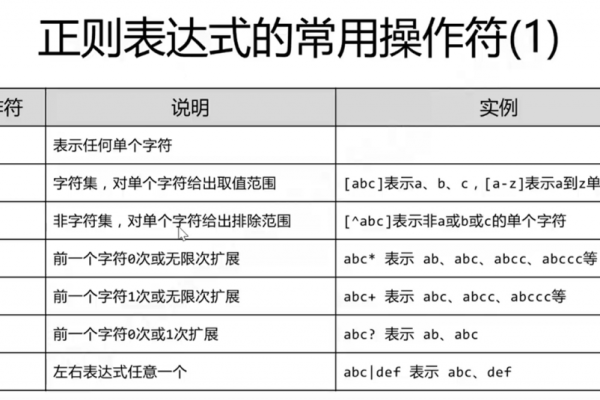

3、正则表达式:正则表达式是文本处理中不可或缺的工具,特别是在需要匹配和提取复杂模式时,在awk或sed等工具中使用正则表达式,可以实现高度定制化的文本处理。

实用技巧与注意事项

1、避免逻辑错误:在使用cut进行文本提取时,需要注意字符和字节的区别,特别是在处理多字节字符时,n标志的使用会忽略多字节字符边界,可能导致意料之外的结果。

2、兼容性考虑:Linux中的文本处理工具大多依赖于标准的Unix接口,这意味着在不同系统上的行为可能略有不同,特别是当处理特殊字符或非标准分隔符时,应进行充分的测试以确保结果的正确性。

3、效率问题:对于大规模文本数据处理,效率成为重要考虑因素,awk和其他工具在处理大文件时可能较为缓慢,适时采用其他高性能工具如Python或Perl,可能会更加高效。

随着对Linux文本处理命令的探讨,可以发现,无论是简单的字段提取还是复杂的字符串操作,Linux提供了丰富的工具和灵活的方法来满足各种需求,掌握这些工具不仅可以帮助用户更有效地处理文本数据,还可以提高工作的效率和准确性。

FAQs

Q1: cut命令的b和c选项有什么区别?

A1: cut命令的b选项用于指定字节范围进行分割,而c选项用于指定字符范围进行分割,主要区别在于b选项在计数时按字节计算,这可能会导致在多字节字符编码(如UTF8)中出现预期外的结果,相反,c选项则按实际字符计数,更适合处理文本数据。

Q2: 使用awk进行文本分割时,如何确保正确处理包含特殊字符的字符串?

A2: 当使用awk进行文本分割时,如果字符串中包含特殊字符(如正则表达式中的元字符),需要确保这些字符被适当地转义,可以使用gsub函数或其他相关函数来替换或去除这些特殊字符,或者在定义分隔符时使用适当的转义序列,使用awk的F选项可以指定一个固定的字段分隔符,这样可以避免因特殊字符导致的误解析。