CDN怎么与其他安全技术协同工作以提高网站安全性

- 行业动态

- 2024-05-27

- 4

CDN(内容分发网络)是一种用于加速网站加载速度的技术,但它也可以与其他安全技术协同工作以提高网站的安全性,下面是一些常见的CDN与其他安全技术的协同工作方式:

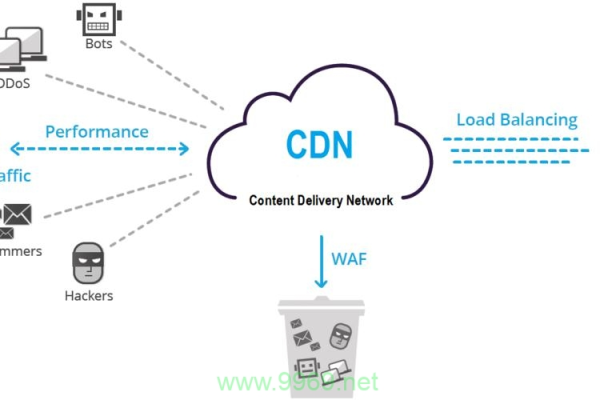

1、CDN与Web应用程序防火墙(WAF)的协同工作:

功能:CDN可以缓存静态内容,而WAF则专注于保护动态内容和应用程序。

协同工作方式:CDN可以将静态内容缓存在边缘服务器上,减少对源服务器的请求,从而减轻WAF的负担,WAF可以检测和阻止反面流量进入源服务器,提高网站的安全性。

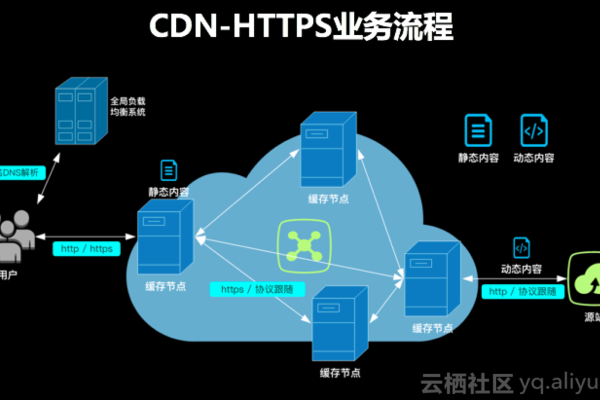

2、CDN与SSL/TLS加密的协同工作:

功能:CDN可以提供SSL/TLS加密来保护数据传输的安全性。

协同工作方式:CDN可以在用户和服务器之间建立安全的连接,使用SSL/TLS协议加密传输的数据,这可以防止数据被窃取或改动,并增加用户的信任度。

3、CDN与DDoS防护的协同工作:

功能:CDN可以提供DDoS防护来抵御分布式拒绝服务攻击。

协同工作方式:CDN可以通过流量分析和过滤机制来识别和阻止反面流量,它可以将反面流量分散到多个服务器上,以降低源服务器的压力,并确保正常用户的访问不受干扰。

4、CDN与载入检测和防御系统的协同工作:

功能:CDN可以提供载入检测和防御系统来监测和阻止潜在的载入行为。

协同工作方式:CDN可以实时监测网络流量,并使用载入检测和防御系统来识别异常行为和潜在威胁,它可以自动采取相应的措施,如封禁IP地址或触发警报,以保护网站的安全。

问题与解答:

Q1: CDN如何与Web应用程序防火墙(WAF)协同工作以提高网站安全性?

A1: CDN可以将静态内容缓存在边缘服务器上,减少对源服务器的请求,从而减轻WAF的负担,WAF可以检测和阻止反面流量进入源服务器,提高网站的安全性。

Q2: CDN如何与SSL/TLS加密协同工作以提高网站安全性?

A2: CDN可以在用户和服务器之间建立安全的连接,使用SSL/TLS协议加密传输的数据,这可以防止数据被窃取或改动,并增加用户的信任度。