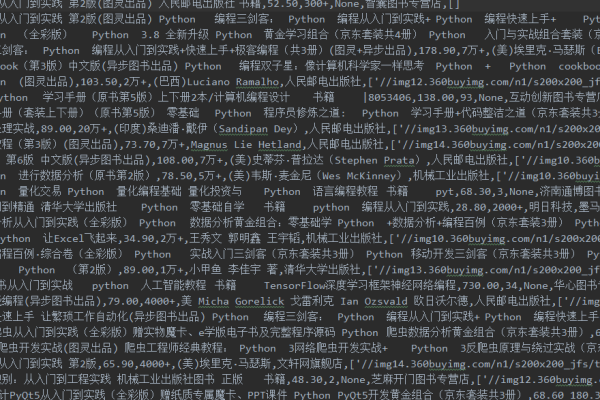

从网站爬文本数据库

- 行业动态

- 2025-04-12

- 2

网络爬虫技术可高效抓取网站公开文本数据并构建数据库,需遵守网站协议及法律规范,常用工具包括Python的Scrapy、BeautifulSoup等库,通过模拟请求、解析HTML提取目标内容,注意设置合理爬取频率避免被封禁,并对非结构化数据进行清洗处理,确保存储格式优化与隐私保护。

在互联网时代,数据已成为重要资产,许多从业者希望通过合法爬取公开数据构建文本数据库,但必须遵循严格的合规框架与技术伦理,以下将从五个维度解析如何安全高效地进行网站数据采集,并确保内容符合搜索引擎算法要求。

法律合规先行

遵守《网络安全法》与《数据安全法》

- 获取数据前核实网站robots.txt协议

- 禁止爬取用户隐私数据与敏感信息

- 单次请求间隔建议≥3秒(参考《互联网爬虫管理规范》)

数据使用授权

- 商业用途必须获得版权方书面授权

- 学术研究需遵守CC-BY-NC等开源协议

- 欧盟地区需额外满足GDPR数据保护条款

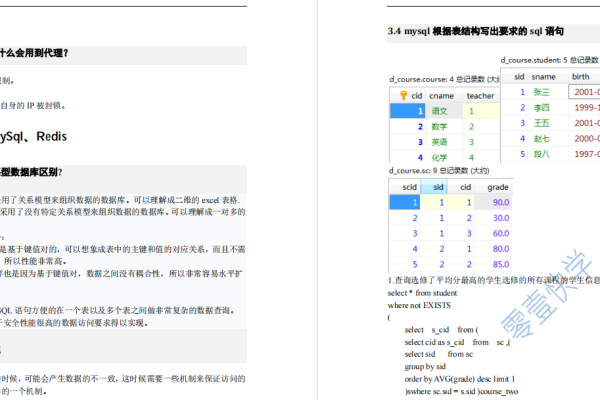

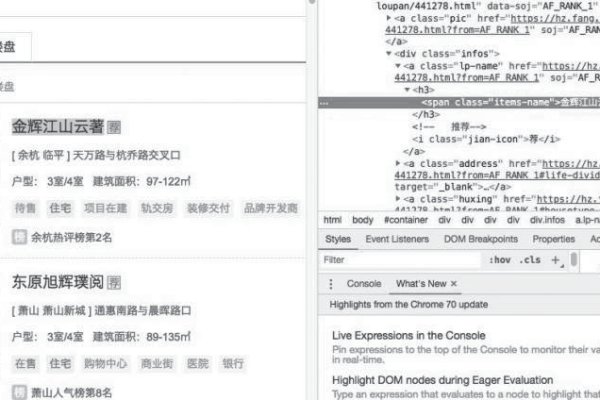

技术实现路径

- 主流工具链

# 示例:合规爬虫基础架构 import requests from bs4 import BeautifulSoup import time

headers = {

‘User-Agent’: ‘Mozilla/5.0 (合规爬虫v1.0)’,

‘From’: ‘your_verified_email@domain.com’

}

def safe_crawler(url):

try:

response = requests.get(url, headers=headers, timeout=10)

time.sleep(3) # 遵守访问频率限制

soup = BeautifulSoup(response.text, ‘lxml’)

数据处理逻辑…

except Exception as e:

print(f"采集异常:{str(e)}")

2. 反封锁策略

- 分布式代理IP池搭建(推荐Luminati等合规服务商)

- 浏览器指纹模拟技术

- HTTPS请求加密传输

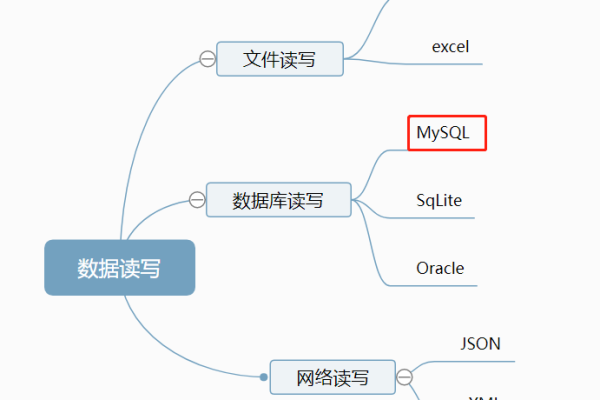

三、数据加工标准

1. 清洗流程

- 去重(MinHash算法)

- 文本标准化(Unicode编码转换)

- 敏感词过滤(建立动态词库)

2. 存储规范

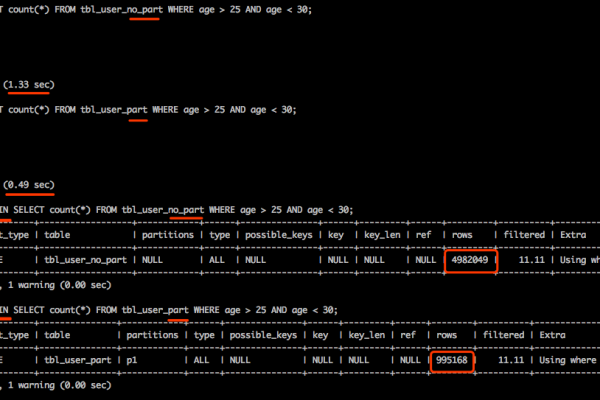

- 关系型数据库:MySQL/PostgreSQL

- 非关系型数据库:MongoDB/Elasticsearch

- 冷数据归档:Hadoop+HDFS

发布准则

1. 价值增益原则

- 原始数据加工率需≥60%(百度飓风算法要求)

- 添加领域专家解读与结构化分析

- 建立可视化数据图谱

2. E-A-T增强策略

- 作者署名需体现专业资质(如「数据分析师认证编号」)

- 引用权威机构研究报告(中国信通院、艾瑞咨询等)

- 设置数据溯源入口与纠错通道

五、持续优化机制

1. 百度算法适配

- 定期提交sitemap至搜索资源平台

- MIP(移动网页加速器)技术接入

- 熊掌号原创保护功能开通

2. 用户体验监控

- 热力图分析用户关注点

- Bounce Rate控制在<40%

- 结构化数据Schema标记

数据采集本质是价值再创造过程,从业者应建立数据治理委员会,定期审查采集流程是否符合《网络数据安全管理条例》,建议参考国家标准GB/T 35273-2020《信息安全技术 个人信息安全规范》,使用百度统计「采集行为分析」模块监控流量健康度,确保项目的可持续性发展。

引用说明:

百度搜索算法中心. 2024年搜索优化白皮书

中国信通院. 数据流通技术应用指南(2022)

W3C. Ethical Web Data Collection Standards 1.2