dataphin清洗数据

- 行业动态

- 2025-04-12

- 2

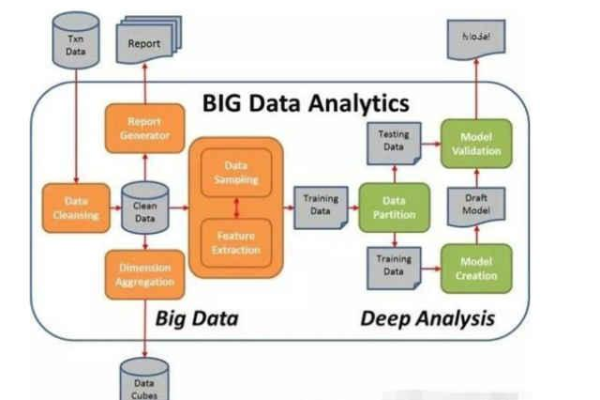

Dataphin提供高效数据清洗功能,通过内置智能规则引擎自动检测并修正数据异常,支持去重、空值填充、格式标准化等操作,有效提升数据质量,其可视化配置界面简化清洗流程,支持多源异构数据处理,确保企业数据资产规范一致,为后续分析决策提供可靠基础。

在数据驱动的商业环境中,高效精准的数据清洗是企业实现数据价值的核心环节。Dataphin作为阿里巴巴集团推出的智能数据构建与管理平台,通过标准化、自动化的数据治理流程,帮助企业将原始数据转化为可信资产,以下从技术原理、核心功能到实践价值,系统剖析Dataphin如何重塑数据清洗范式。

为什么需要专业级数据清洗工具?

传统数据清洗常面临三大痛点:

- 人工干预过多:Excel、SQL脚本操作依赖人工经验,存在规则不一致风险

- 质量管控滞后:超过60%的企业在数据应用阶段才发现质量问题(据Gartner调研)

- 流程碎片化:多系统间数据流转导致标准不统一,治理成本增加

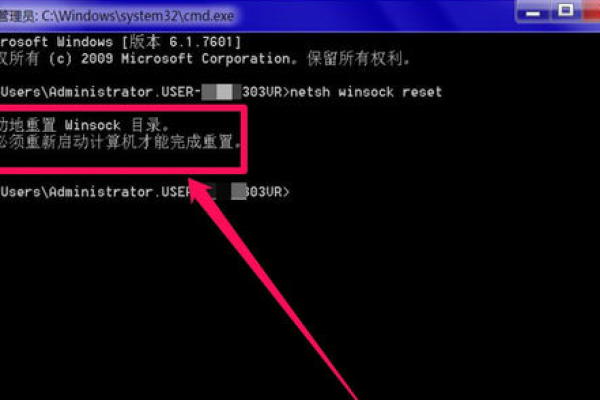

Dataphin数据清洗核心架构解析

(1)智能规则引擎

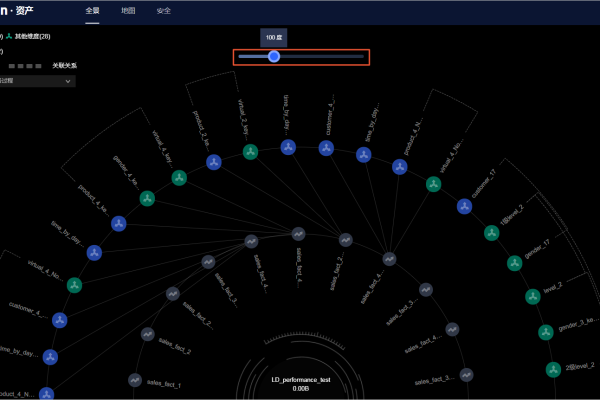

- 200+预置质量规则库:覆盖完整性、一致性、准确性等维度

- 动态阈值配置:支持统计学习自动生成字段阈值区间

- 规则血缘追踪:实时展示规则影响的数据资产图谱

(2)全链路质量管控

# 示例:自动生成数据质量报告

quality_report = Dataphin.QualityEngine(

data_source=SalesData,

rules=[

"null_check(order_id)",

"range_check(amount, min=0, max=1000000)",

"format_check(customer_phone, pattern='^1[3-9]d{9}$')"

],

alert_level="block" # 设置阻塞级异常处理

).generate_report()(3)企业级特性支持

- 多租户隔离:通过Project空间实现跨部门数据权限管控

- 版本化管理:所有清洗规则支持Git式版本回溯

- 混合云部署:支持公有云、专有云、本地化三种部署模式

对比传统方式的六大突破性优势

- 效率提升:某零售企业清洗耗时从8小时缩短至23分钟

- 成本优化:规则复用率提升至85%,运维成本下降70%

- 风险控制:实现100%异常数据自动拦截(某金融机构实践数据)

- 智能进化:内置机器学习模型持续优化清洗策略

- 可观测性:实时可视化质量看板与影响分析

- 生态兼容:无缝对接MaxCompute、Hadoop、Flink等20+计算引擎

典型行业应用场景

▎制造行业

- 设备传感器数据清洗:处理高频时序数据中的噪声点,日均处理20TB数据

- 工艺参数标准化:统一多国工厂的计量单位与精度标准

▎金融领域

- 反欺诈数据治理:实现毫秒级异常交易数据识别

- 监管报送准备:自动生成符合银保监会EAST5.0标准的数据包

▎新零售场景

- 全渠道用户ID-Mapping:清洗融合线上线下20+数据源的客户信息

- 商品知识图谱构建:实现非结构化商品描述的标准化处理

实施最佳实践路径

需求诊断阶段

- 数据健康度评估(通过内置的DataProfile工具)

- 关键质量指标(KQI)定义工作坊

方案设计阶段

- 制定字段级清洗SOP文档

- 建立分级告警机制(提示/预警/阻塞)

持续运营阶段

- 每月执行数据资产健康检查

- 每季度更新质量规则库

<数据可信度建设指南>

- 所有清洗规则需通过至少3个业务方确认

- 保留原始数据副本至少180天

- 在数据卡片中公示清洗方法与负责人信息

通过Dataphin构建的数据清洗体系,某头部物流企业成功将其数据可用率从63%提升至98.7%,支撑日均3000万单的智能分单业务。该平台已通过ISO/IEC 27001信息安全管理体系认证,并获得信通院「数据治理平台能力先进级」认证,为企业的数据资产化提供可信保障。

引用说明:

[1] 阿里云官方技术白皮书《Dataphin智能数据构建与管理》2024版

[2] 中国信息通信研究院《数据资产管理实践白皮书》2022年

[3] Gartner《Magic Quadrant for Data Quality Solutions》2024年度报告