bp 网络 回归

- 行业动态

- 2025-04-12

- 2

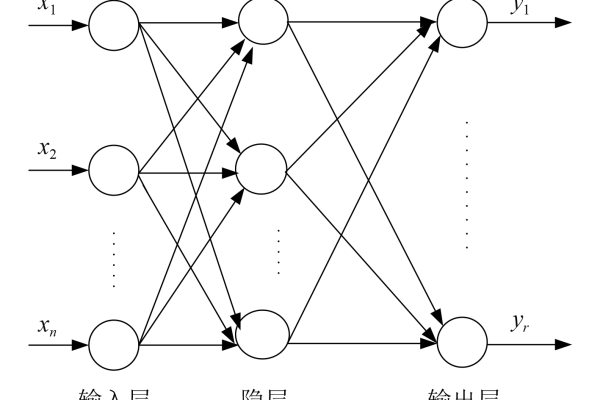

BP神经网络是一种基于反向传播算法的前馈神经网络,常用于回归预测任务,其通过误差反向传播和梯度下降策略调整网络参数,实现对复杂非线性关系的建模,该网络包含输入层、隐含层和输出层,具备较强的数据拟合能力,适用于预测分析、函数逼近等场景,但需合理设计网络结构和训练参数以避免过拟合。

在机器学习领域,BP神经网络(反向传播神经网络)因其强大的非线性拟合能力,被广泛用于解决回归问题,无论是股票价格预测、工业参数优化,还是医学数据分析,BP网络都能通过自主学习数据中的复杂规律,输出连续的预测结果,以下将从核心原理、应用流程、优化策略及适用场景展开分析,帮助读者全面理解这一技术。

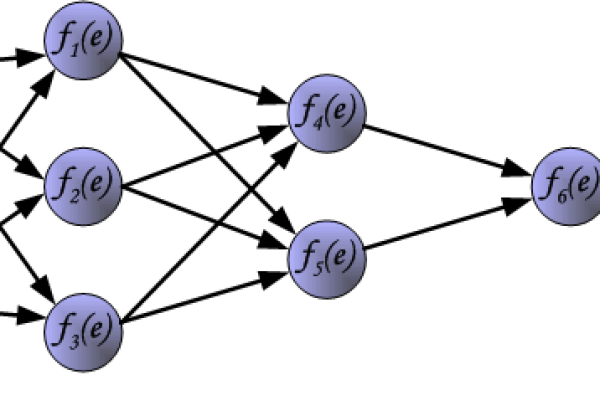

BP神经网络的核心原理

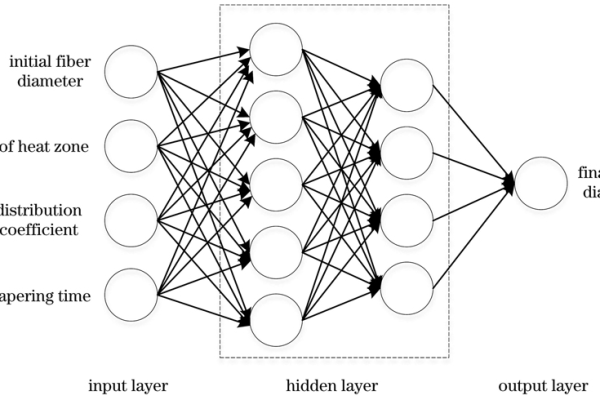

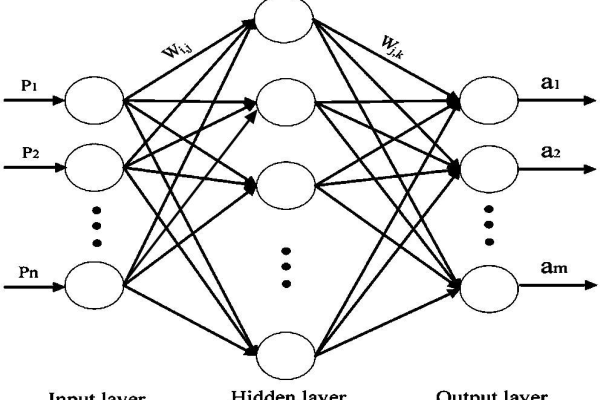

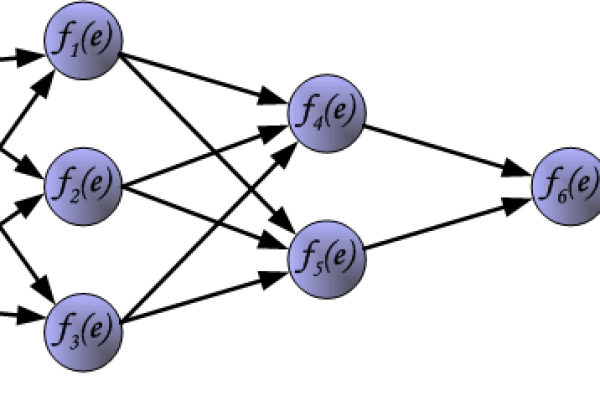

BP神经网络是一种多层前馈网络,通过反向传播算法调整网络权重,最小化预测值与真实值的误差,其结构通常包含:

- 输入层:接收特征数据(如房屋面积、楼层数);

- 隐含层:通过非线性激活函数(如ReLU、Sigmoid)提取高阶特征;

- 输出层:输出连续型预测结果(如房价)。

训练过程中,数据从输入层流向输出层(前向传播),计算损失后根据梯度下降法反向调整权重(反向传播),逐步优化模型。

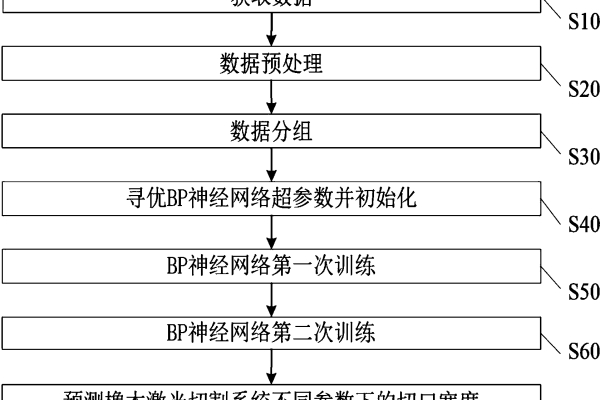

BP网络回归的应用流程

数据预处理

- 标准化/归一化:消除量纲差异,加速收敛;

- 划分数据集:按比例切分为训练集、验证集和测试集(如7:2:1)。

网络结构设计

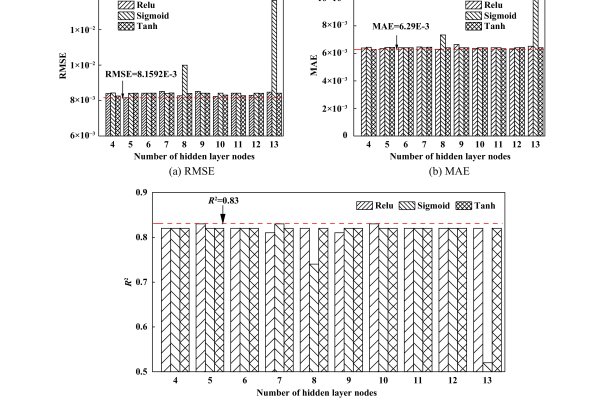

- 隐含层数:通常1~3层,过多易导致过拟合;

- 神经元数量:输入层节点数等于特征维度,输出层为1(单输出回归);

- 激活函数:隐含层常用ReLU,输出层用线性函数(如无激活)。

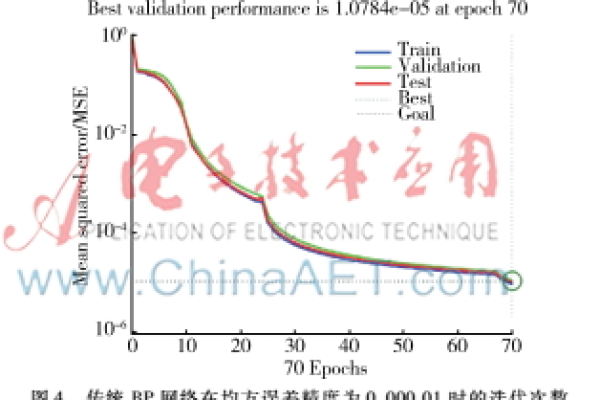

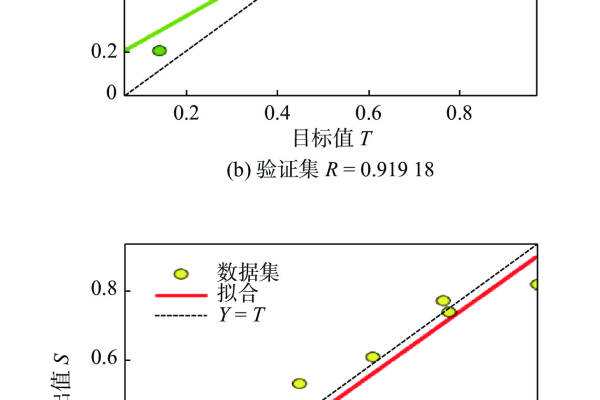

模型训练与调优

- 损失函数:均方误差(MSE)或平均绝对误差(MAE);

- 优化器:Adam、SGD等,平衡收敛速度与稳定性;

- 正则化:L2正则化或Dropout减少过拟合风险。

关键优势与局限性

优势

- 非线性建模能力:可拟合复杂曲线,优于线性回归;

- 自适应学习:无需手动设计特征组合;

- 广泛适用性:适用于高维数据和小样本场景(配合正则化)。

局限性

- 计算成本高:隐含层过多时训练时间显著增加;

- 局部最优陷阱:梯度下降可能收敛到非全局最优解;

- 数据依赖性:数据质量差或噪声多时性能下降。

实际应用中的优化策略

早停法(Early Stopping)

监控验证集损失,当连续若干次迭代未下降时终止训练,防止过拟合。

批量归一化(Batch Normalization)

对每层输入做归一化处理,提升训练稳定性。学习率衰减

动态降低学习率(如指数衰减),避免后期震荡。交叉验证

采用K折交叉验证评估模型泛化能力,确保参数选择合理。

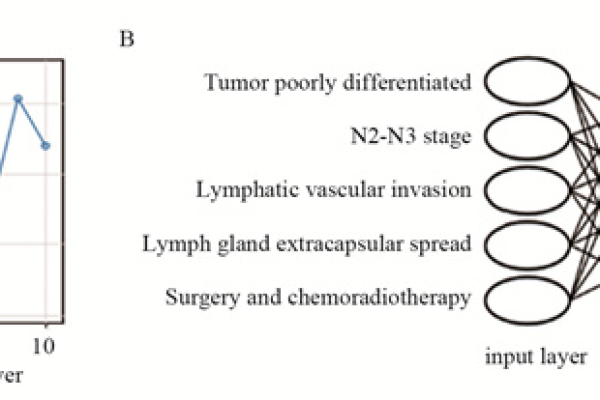

典型应用场景

- 金融领域

预测股票价格、汇率波动或用户信用评分。 - 工业控制

根据传感器数据预测设备故障时间。 - 医疗分析

基于患者体征数据预估疾病风险值。

常见问题解答

Q:BP网络需要多少数据量?

A:通常需数千条以上样本,具体取决于特征维度与问题复杂度,数据不足时可使用数据增强或迁移学习。

Q:如何选择隐含层节点数?

A:经验公式:隐含层节点数≈(输入维度+输出维度)/2,或通过网格搜索确定最优值。

Q:模型训练震荡严重怎么办?

A:降低学习率、增大批量大小(Batch Size)或改用动量优化器(如Adam)。

BP神经网络回归凭借其灵活性,成为处理非线性问题的利器,实际应用中需结合数据特点调整网络结构,配合正则化与优化策略,才能发挥最佳性能,对于希望深入研究的读者,建议结合TensorFlow、PyTorch等框架进行实践,理解参数调优的细节。

参考文献

- Rumelhart D.E., Hinton G.E., Williams R.J. (1986). Learning representations by back-propagating errors. Nature.

- 周志华. (2016). 《机器学习》. 清华大学出版社.

- Goodfellow I., Bengio Y., Courville A. (2016). Deep Learning. MIT Press.