大数据学究竟教会了我们什么?

- 行业动态

- 2024-12-11

- 4512

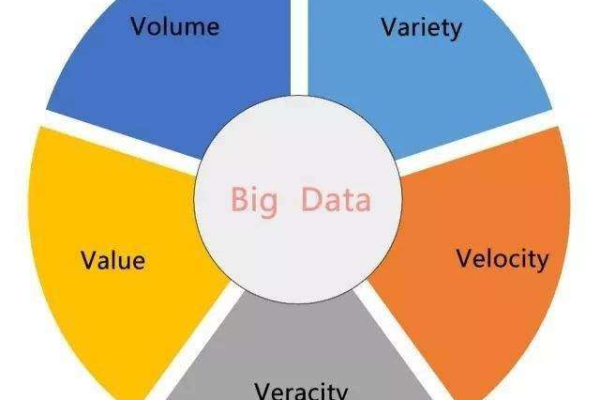

大数据学习让我理解了数据的价值,掌握了数据分析技能,并学会了从海量信息中提炼出有价值的洞察。

从大数据学到了什么

在当今数据驱动的世界中,大数据已经成为企业决策和运营的重要工具,通过系统学习大数据相关知识,我不仅掌握了技术技能,还对数据分析产生了浓厚的兴趣,本文将详细阐述我在大数据学习过程中所获得的知识和经验。

一、基础知识的掌握

1、编程语言:

学习了Java和Python两种编程语言,Java用于理解面向对象编程和大数据生态系统的基础架构,Python则因其简洁和强大的数据处理库(如Pandas、NumPy)而被广泛应用于数据分析和机器学习。

2、数据库知识:

熟悉了关系型数据库MySQL和非关系型数据库MongoDB的基本操作,包括数据的增删改查(CRUD)操作,以及复杂查询语句的编写。

3、操作系统:

学习了Linux操作系统的基本命令和操作,因为大多数大数据处理框架(如Hadoop、Spark)运行在Linux环境下,掌握了文件系统操作、用户管理与权限配置等基本技能。

4、分布式系统理论:

了解了CAP理论、数据一致性模型、负载均衡和容错处理等分布式系统的基本概念,这为后续学习大数据平台打下了坚实的理论基础。

二、大数据平台的深入理解

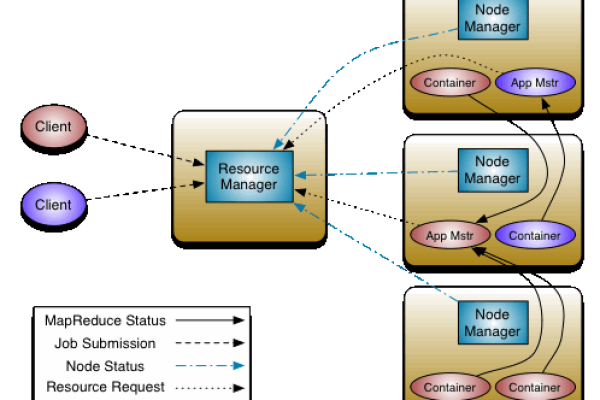

1、Hadoop生态系统:

深入学习了Hadoop的核心组件HDFS(分布式文件系统)和MapReduce(分布式计算框架),掌握了HDFS的文件管理和MapReduce的编程模型,理解了其工作原理和性能优化方法。

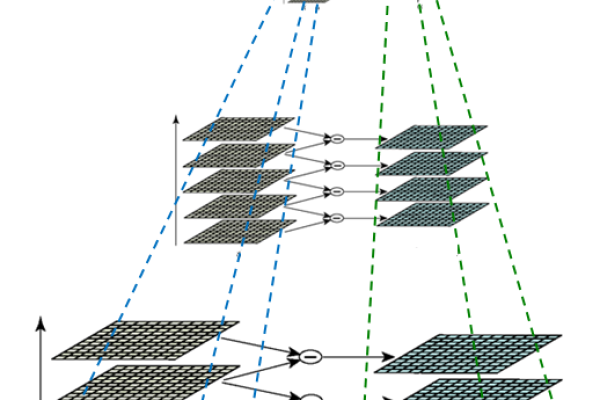

2、Spark生态系统:

学习了Spark的核心组件,包括Spark Core、Spark SQL、Spark Streaming和MLlib,掌握了Spark的内存计算模型和高效的数据处理能力,能够使用DataFrame和RDD进行复杂的数据转换和分析。

3、Flink生态系统:

了解了Flink的核心组件,如Flink Core、Flink Streaming和Flink ML,学会了使用Flink进行实时流处理和批处理,掌握了其事件时间和水印机制。

三、大数据应用场景的实践

1、日志分析:

通过分析服务器日志,学会了如何使用Hadoop和Spark进行日志数据的采集、存储和分析,从而了解用户行为和系统性能。

2、推荐系统:

学习了协同过滤算法和基于内容的推荐算法,并使用Spark MLlib实现了一个简单的电影推荐系统,理解了推荐系统的基本原理和实现方法。

3、用户画像:

通过分析用户的行为数据,构建了用户画像,帮助企业更好地了解用户特征和需求,从而进行精准营销和产品设计。

四、实践项目的经验积累

1、开源项目参与:

积极参与了一些大数据相关的开源项目,贡献代码并与其他开发者合作,提升了实际开发能力和团队合作精神。

2、企业实践项目:

参与了企业的数据仓库建设和数据挖掘项目,积累了实际项目经验,了解了企业级大数据应用的需求和技术实现。

3、个人项目开发:

结合自己的兴趣,开发了一些个人项目,如使用Python进行数据可视化分析,利用Spark进行大规模数据处理等,提高了独立解决问题的能力。

五、持续学习和交流的重要性

1、关注前沿技术:

持续关注大数据领域的最新技术和动态,了解新技术的发展和应用情况,保持技术的先进性。

2、线上课程学习:

参加了多个大数据相关的线上课程和培训,系统地学习了大数据知识和技能,不断提升自己的专业水平。

3、社区和论坛参与:

加入了一些大数据社区和论坛,与其他从业者交流经验和心得,获取最新的技术资讯和解决方案。

通过系统学习大数据相关知识和技能,我不仅掌握了技术层面的知识,还培养了数据分析思维和解决问题的能力,我将继续深入学习大数据技术,探索更多的应用场景,为企业的数据驱动决策提供更有力的支持,我也将保持持续学习和交流的态度,不断提升自己的专业素养和综合能力。

七、FAQs

Q1: 学习大数据需要哪些基础知识?

A1: 学习大数据需要掌握编程语言(如Java和Python)、数据库知识(包括关系型和非关系型数据库)、操作系统(特别是Linux),以及分布式系统理论等基础知识,这些知识为后续学习大数据平台和应用场景打下坚实的基础。

Q2: 大数据学习的路线图是什么?

A2: 大数据学习路线图通常分为几个阶段,包括基础知识学习(如编程语言、数据库、操作系统等)、大数据平台学习(如Hadoop、Spark、Flink等)、大数据应用场景实践(如日志分析、推荐系统、用户画像等)、实践项目经验积累以及持续学习和交流,每个阶段都有具体的学习目标和内容,通过逐步深入学习和实践,可以全面掌握大数据知识和技能,具体如下表所示:

| 阶段 | 主要学习内容 |

| 基础知识学习 | 编程语言、数据库、操作系统、分布式系统理论 |

| 大数据平台学习 | Hadoop、Spark、Flink等 |

| 大数据应用场景实践 | 日志分析、推荐系统、用户画像等 |

| 实践项目经验积累 | 开源项目参与、企业实践项目、个人项目开发 |

| 持续学习和交流 | 关注前沿技术、线上课程学习、社区和论坛参与 |

小编有话说

学习大数据是一个充满挑战和机遇的过程,在这个过程中,我深刻体会到了持续学习和实践的重要性,只有不断学习新知识、掌握新技术,才能跟上大数据领域的快速发展步伐,通过参与实践项目和企业合作,我积累了丰富的实际经验,这对我未来的职业发展有着重要的意义,希望我的经历能给大家带来一些启发和帮助,也欢迎大家一起交流和探讨大数据的奥秘!

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/367776.html