web应用防火墙在cdn中怎么运作来增强安全性的方法

- 行业动态

- 2024-05-27

- 1

Web应用防火墙(WAF)在CDN中的运作可以通过以下几个步骤来增强安全性:

1、检测和过滤反面流量:

WAF可以检测并过滤来自用户请求的反面流量,如SQL注入、跨站脚本攻击(XSS)、文件包含等。

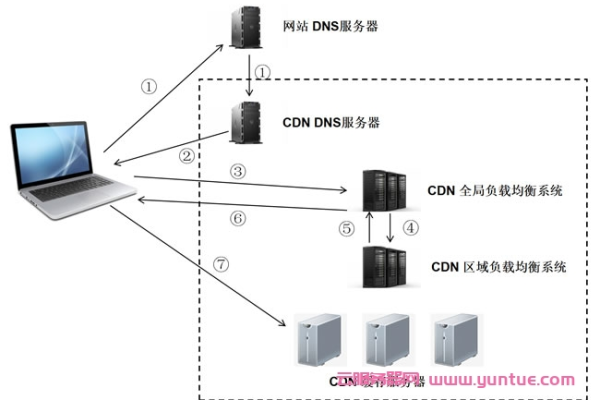

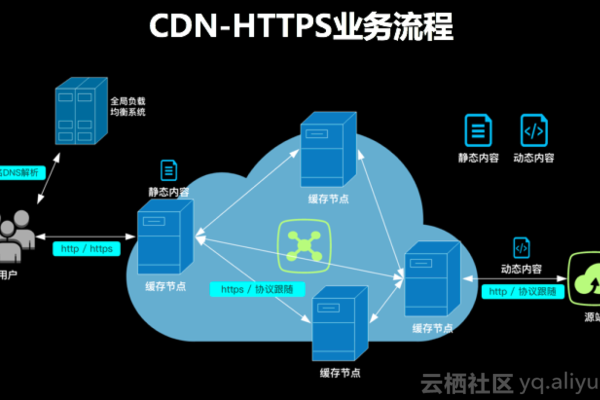

CDN可以将WAF集成到其网络架构中,以实时监测和阻止反面流量进入源服务器。

2、防止DDoS攻击:

DDoS攻击是一种通过向目标服务器发送大量请求来使其无法正常工作的攻击方式。

CDN可以利用其分布式网络架构来分散DDoS攻击流量,从而保护源服务器免受攻击。

WAF可以进一步分析请求并识别出潜在的DDoS攻击,从而采取相应的防御措施。

3、安全策略管理:

WAF可以为CDN提供安全策略管理功能,包括设置允许或拒绝特定HTTP方法、URL路径、参数等的规则。

CDN可以根据这些规则对用户请求进行过滤和处理,确保只有合法的请求能够访问源服务器。

4、日志和监控:

CDN可以收集和存储与WAF相关的日志信息,包括反面请求的详细信息、被阻止的攻击等。

这些日志可以用于后续的安全分析和审计,以及发现新的安全威胁和破绽。

5、自动化更新和规则同步:

WAF的规则库需要不断更新以应对新出现的安全威胁和破绽。

CDN可以与WAF进行自动化的更新和规则同步,确保WAF始终具备最新的安全防护能力。

相关问题与解答:

问题1:WAF在CDN中的作用是什么?

答案:WAF在CDN中的作用是检测和过滤反面流量、防止DDoS攻击、提供安全策略管理、收集和存储日志信息,并与WAF进行自动化的更新和规则同步,从而增强Web应用的安全性。

问题2:如何确保WAF与CDN的集成能够有效提高安全性?

答案:确保WAF与CDN的集成能够有效提高安全性的关键是通过实时监测和阻止反面流量进入源服务器,利用CDN的分布式网络架构来分散DDoS攻击流量,并根据安全策略管理功能设置合适的规则对用户请求进行过滤和处理,定期更新WAF的规则库以及与WAF进行自动化的更新和规则同步也是确保集成效果的重要步骤。