bp神经网络特点

- 行业动态

- 2025-04-11

- 2

BP神经网络(误差反向传播神经网络)是人工智能领域最经典的算法之一,其特点深刻影响了现代深度学习的发展,以下从专业角度解析该网络的六大核心特征:

误差反向传播机制

作为首个将反向传播算法(Backpropagation)系统化应用的神经网络,BP网络通过”前向计算损失,反向传递误差”实现参数优化,当网络输出与预期结果存在误差时,系统会逆向逐层调整各层权重,这种闭环反馈机制如同自动驾驶的纠偏系统,大幅提高了学习效率,1986年Rumelhart与Hinton团队在《自然》发表的论文奠定了这一算法的理论基础。

梯度下降优化原理

网络采用梯度下降法进行参数更新,通过计算损失函数对权重的偏导数确定调整方向,这相当于在山顶蒙眼下山时,通过感受坡度寻找最快下降路径,实际应用中常采用动量法、Adam优化器等改进算法,有效缓解传统梯度下降存在的震荡问题。

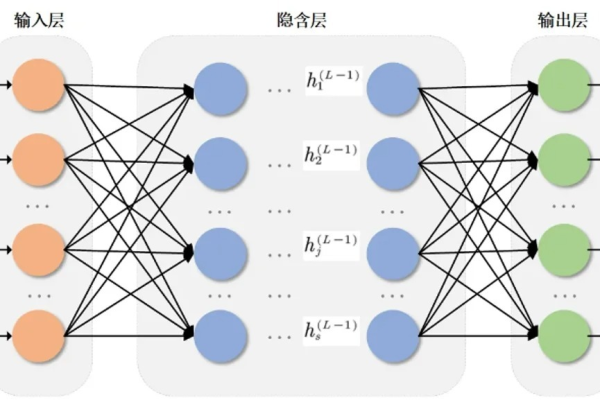

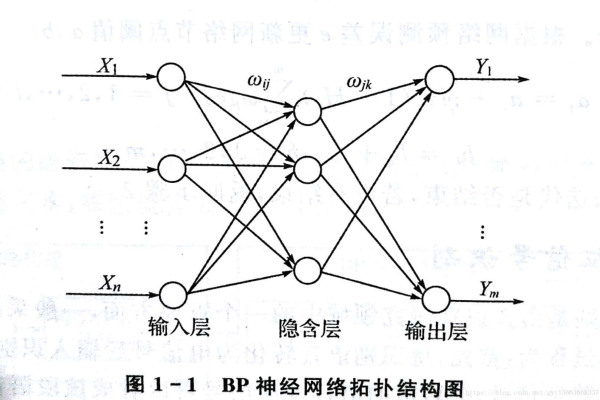

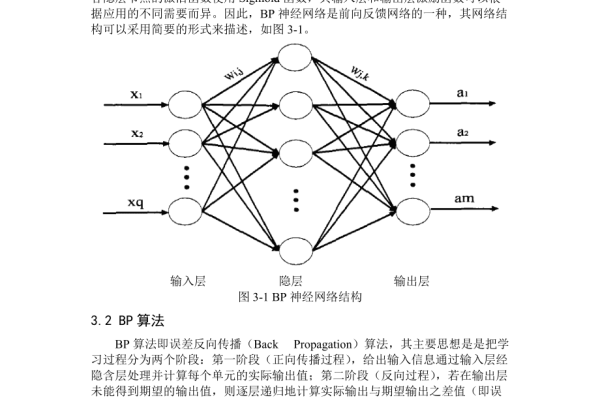

多层前馈架构

区别于单层感知机,BP网络包含输入层、隐藏层(≥1)、输出层的层级结构,以手写数字识别为例,输入层784个神经元对应28×28像素,经过多个隐藏层的非线性变换,最终输出层10个神经元分别代表0-9的概率分布,这种深度结构赋予网络强大的特征抽象能力。

非线性映射特性

通过Sigmoid、ReLU等激活函数引入非线性因素,使网络能够拟合任意复杂函数,研究表明(Cybenko, 1989),含单隐藏层的BP网络即可逼近任意连续函数,这为其在图像识别、金融预测等领域的应用提供了理论支撑。

参数敏感性与调优

学习率(0.01-0.1)、批量大小(32-256)、网络深度(3-10层)等超参数显著影响模型性能,例如在自然语言处理任务中,过大的学习率会导致损失值震荡,过小则收敛缓慢,工程师通常需要结合网格搜索、贝叶斯优化等方法进行参数调优。

工程实践挑战

虽然理论完备,但实际应用时需警惕梯度消失问题(使用ReLU缓解)、过拟合现象(采用Dropout正则化)、局部极小值陷阱(引入动量项),工业级部署时,计算资源消耗与推理速度也是关键考量因素。

引用说明

[1] Rumelhart D E, Hinton G E, Williams R J. Learning representations by back-propagating errors[J]. Nature, 1986.

[2] Haykin S. Neural networks and learning machines[M]. Pearson Education, 2009.

[3] Cybenko G. Approximation by superpositions of a sigmoidal function[J]. Mathematics of control, signals and systems, 1989.