服务器图形显卡

- 行业动态

- 2025-04-11

- 2

服务器图形显卡专为高性能计算设计,支持大规模并行运算与复杂 图形渲染,常用于深度学习、AI训练、科学模拟及虚拟化场景,其具备多GPU协作、高显存容量及优化散热架构,可稳定处理密集型任务,适用于数据中心、云计算及多用户远程图形工作站等环境。

高性能计算的“隐形引擎”

在数字化时代,服务器作为企业数据处理的“大脑”,其性能直接影响业务效率,而服务器图形显卡(GPU)作为关键硬件之一,正从传统的图形渲染工具演变为支撑人工智能、科学计算等复杂任务的核心组件,本文将从技术原理、应用场景、选型建议到维护技巧,全面解析服务器显卡的价值与使用逻辑。

服务器显卡与普通显卡的差异

服务器显卡与消费级显卡看似相似,但设计目标截然不同:

- 硬件架构优化

- 并行计算能力:服务器显卡(如NVIDIA A100、AMD Instinct)专为多线程任务设计,支持数千个计算核心,可同时处理海量数据。

- 显存容量与带宽:配备24GB至80GB的HBM显存,带宽达1.5TB/s以上,远超普通显卡(通常为8-24GB GDDR6)。

- 稳定性与可靠性

- 支持ECC(纠错码)显存,避免数据错误;

- 7×24小时全负载运行设计,平均无故障时间(MTBF)超10万小时。

- 软件生态支持

针对企业级应用优化驱动(如NVIDIA CUDA、ROCm),兼容TensorFlow、PyTorch等主流框架。

服务器显卡的核心应用场景

- 人工智能与深度学习

- 训练模型:单台搭载4块A100显卡的服务器,可替代数百台CPU服务器的算力;

- 推理加速:实时处理图像识别、自然语言处理任务,延迟降低60%以上。

- 高性能计算(HPC)

气象预测、基因测序等科学计算场景,GPU加速使计算周期从数周缩短至小时级。

- 虚拟化与云服务

通过vGPU技术(如NVIDIA vComputeServer),单卡可分割为多个虚拟GPU,供多用户共享。

- 图形渲染与实时仿真

影视渲染农场、工业设计仿真(如汽车碰撞测试)依赖多GPU并行计算提升效率。

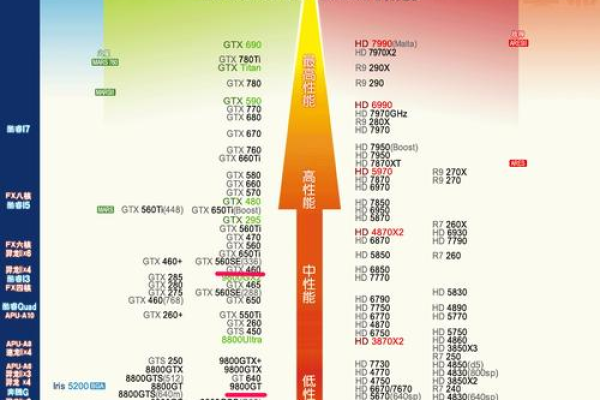

如何选择适合的服务器显卡?

- 明确需求优先级

- 算力密集型任务(如AI训练):选择FP32/FP64性能高的型号(如NVIDIA H100);

- 显存敏感型任务(如大数据分析):优先大容量显存(如AMD MI250X 128GB)。

- 兼容性与扩展性

- 确认服务器主板支持PCIe 4.0/5.0接口及GPU功耗(通常300W-700W);

- 多卡场景需考虑NVLink/Switch技术提升互联带宽。

- 总拥有成本(TCO)

根据业务规模选择整机(如NVIDIA DGX系统)或自建集群,平衡初期投入与长期运维成本。

服务器显卡的维护与优化建议

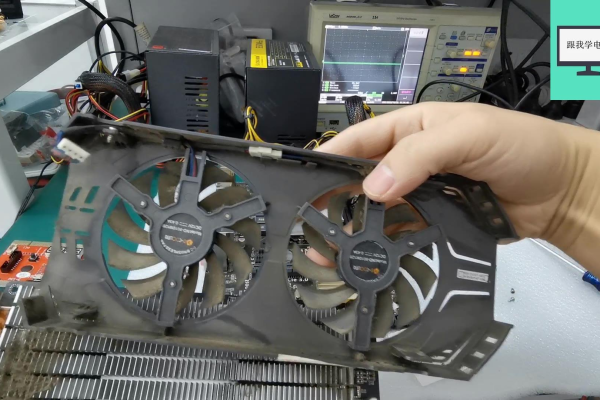

- 散热管理

- 强制风冷需保持机房温度18-27℃,液冷方案可降低30%能耗;

- 定期清理风扇灰尘,避免因过热导致降频。

- 驱动与固件更新

- 每月检查厂商更新,修复安全破绽并提升性能(如NVIDIA季度企业级驱动);

- 使用DCGM、AMD ROCm等工具监控GPU状态。

- 负载均衡策略

- 通过Kubernetes或Slurm调度系统,避免单卡过载;

- 启用MIG(多实例GPU)技术,将单卡划分为7个独立实例,提升资源利用率。

未来趋势:GPU技术的革新方向

- 异构计算架构

CPU+GPU+DPU协同设计(如NVIDIA Grace Hopper),突破内存带宽瓶颈;

- 绿色算力

采用5nm制程与chiplet封装,性能功耗比提升3倍(参考AMD CDNA 3架构);

- 云原生GPU

公有云厂商(如AWS、阿里云)推出分时租赁GPU实例,降低中小企业使用门槛。

引用说明

本文数据及技术参数参考自:

- NVIDIA官方白皮书《Accelerated Computing for Enterprise》

- AMD Instinct MI系列产品手册

- IDC报告《Global GPU Market Forecast 2024-2027》

- 中国科学院《高性能计算中的GPU加速技术研究》