服务器操作系统 多用户访问

- 行业动态

- 2025-04-11

- 2

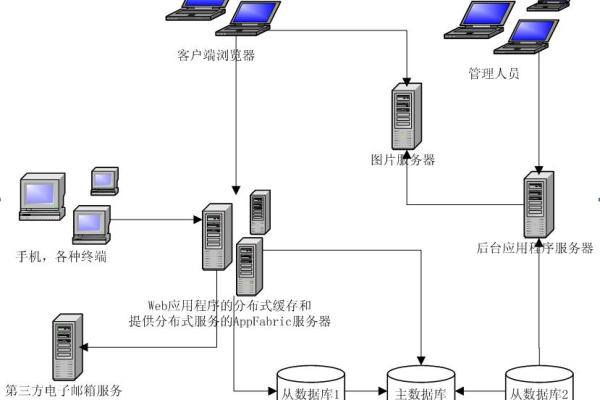

服务器操作系统支持多用户同时访问,通过权限管理、资源分配与进程隔离保障各用户独立操作,其核心机制包括身份验证、多任务调度及数据隔离,确保安全性、稳定性和高效性,适用于企业、云计算等需共享资源的场景。

在数字化时代,服务器操作系统作为支撑企业级应用的核心平台,其多用户访问能力直接影响着业务效率和数据安全,本文将深入解析多用户访问的实现原理、技术优势及实践要点,为读者提供可操作的技术指南。

什么是服务器操作系统的多用户访问?

多用户访问指同一台服务器支持多个用户同时登录并执行任务,各用户的操作环境、数据存储和权限彼此独立。

- 远程团队协作:开发人员通过SSH连接服务器并行编写代码;

- 云计算服务:数百家企业共享同一物理服务器的虚拟化资源;

- 金融机构:不同部门员工通过权限隔离访问核心数据库。

这种能力依赖操作系统的内核级架构设计,包括用户身份认证、资源分配算法和进程隔离机制。

实现多用户访问的5大核心技术

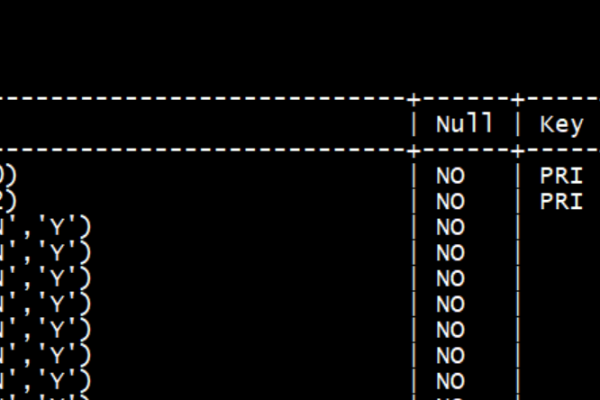

用户身份管理

- 基于RBAC(基于角色的访问控制)模型划分权限层级

- 使用LDAP/Active Directory集中管理账户(如Windows Server的域控)

- 密钥对认证替代密码(如Linux的SSH密钥登录)

资源隔离技术

# Linux cgroups实现CPU/内存隔离示例 cgcreate -g cpu,memory:/developers cgset -r cpu.shares=512 developers cgset -r memory.limit_in_bytes=4G developers

- 容器化技术(Docker/Kubernetes)构建沙箱环境

- 虚拟化层(VMware/KVM)分配独立虚拟硬件资源

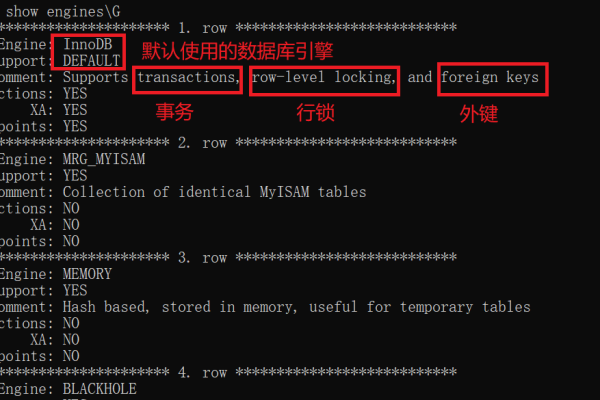

并发控制机制

- 文件锁(fcntl/flock)避免数据竞争

- 数据库事务的ACID特性保障操作原子性

- 实时优先级调度算法(如Linux的CFS)

审计与日志系统

- 记录用户登录时间、操作命令(通过auditd/syslog)

- 行为分析检测异常访问(如多次失败登录告警)

网络通信优化

- TCP/IP协议栈的并发连接管理(如调整somaxconn参数)

- 负载均衡器分配用户请求到不同工作节点

典型场景下的最佳实践

案例1:电商大促期间的突发流量应对

技术方案:

- 自动扩展组(Auto Scaling Group)动态增加云服务器实例

- 使用Redis集群实现会话状态共享

- Nginx限流模块控制每秒请求数(QPS)

效果:

- 支撑10万级并发用户下单

- 响应延迟稳定在200ms以内

案例2:医疗机构数据安全合规

- 实施要点:

- HIPAA合规的加密传输(TLS 1.3+)

- 基于属性的访问控制(ABAC)动态授权

- 数据库字段级脱敏(如患者姓名哈希存储)

性能调优关键指标监测

| 指标 | 监控工具 | 健康阈值 | 优化措施 |

|---|---|---|---|

| CPU负载 | top/htop | < 70%核心数 | 调整进程优先级 |

| 内存使用率 | free/vmstat | < 80% | 增加swap或优化缓存策略 |

| 磁盘IOPS | iostat | < 85%带宽 | 升级SSD或启用RAID |

| 网络吞吐量 | iftop/nload | < 90%链路容量 | 启用流量整形或增加网卡 |

| 并发连接数 | netstat/ss | < 文件描述符上限 | 调整ulimit或内核参数 |

安全防护的3层防御体系

边界防护

- 防火墙白名单(iptables/nftables)

- 载入检测系统(Snort/Suricata)

访问控制

- 双因素认证(Google Authenticator)

- 最小权限原则(POLP)授权

数据保护

- LUKS磁盘加密

- 定期备份验证(rsync+BorgBackup)

引用说明

本文技术观点参考:

- Red Hat Enterprise Linux系统管理手册(第8版)

- Microsoft Windows Server 2022安全白皮书

- 《UNIX环境高级编程》(W. Richard Stevens著)

- NIST SP 800-53 Rev.5信息安全控制标准

通过持续的系统优化与安全加固,企业可构建高可靠的多用户服务体系,建议每季度进行压力测试和渗透测试,确保架构始终满足业务发展需求。