如何高效地将从各种来源接收到的数据迁移至数据库?

- 行业动态

- 2024-12-10

- 2090

接收数据后,将其解析并存储到数据库中,确保数据的完整性和一致性。

在当今数据驱动的时代,高效地将接收到的数据转移到数据库中是一项至关重要的任务,这不仅涉及到数据的完整性和准确性,还关系到后续数据分析和处理的效率,本文将详细探讨如何从接收数据并将其移动到数据库的全过程,包括准备工作、数据验证、数据转换、数据加载以及后续的维护和优化。

一、准备工作

1. 确定数据源

需要明确数据的来源,这可能包括各种形式,如API接口、文件(CSV、JSON等)、数据库同步等,了解数据源的类型有助于选择最合适的接收方式。

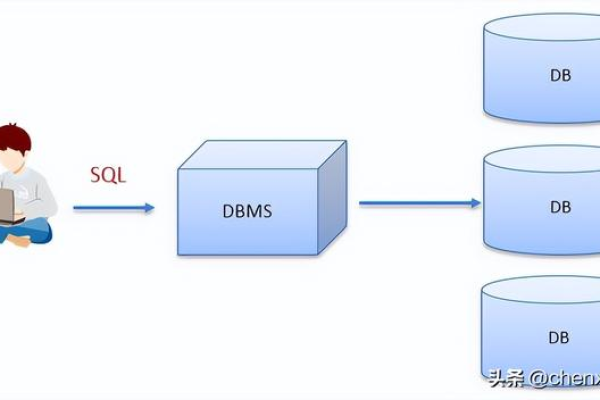

2. 选择目标数据库

根据业务需求和技术栈选择合适的数据库系统,如MySQL、PostgreSQL、MongoDB等,不同的数据库在性能、扩展性和特性支持上有所不同,因此选择时需综合考虑。

3. 设计数据库架构

基于业务需求设计合理的数据库表结构,确保能够高效存储和检索数据,这包括确定表的主键、索引、外键关系以及字段类型等。

二、数据验证

1. 格式检查

在数据进入数据库之前,必须对其进行格式验证,确保数据符合预期的结构和类型,检查日期格式是否正确,数字是否在合理范围内等。

2. 完整性校验

验证数据的完整性,确保没有缺失或重复的数据,这可以通过设置唯一约束或者使用特定的算法来实现。

3. 业务规则验证

根据业务逻辑对数据进行进一步的校验,比如年龄字段不能为负数,电子邮件地址必须符合特定的格式等。

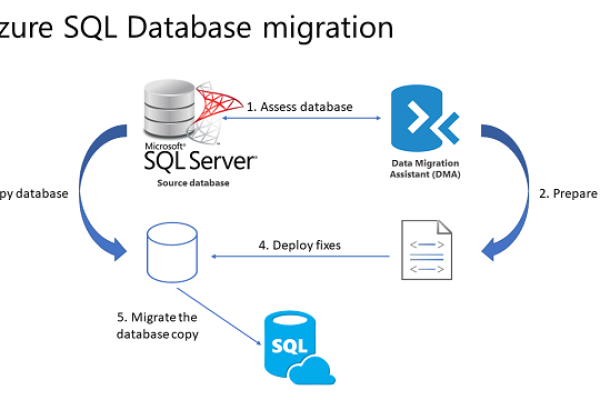

三、数据转换

1. 数据清洗

对原始数据进行清洗,去除无关信息,填补缺失值,纠正错误等,这一步骤对于提高数据质量至关重要。

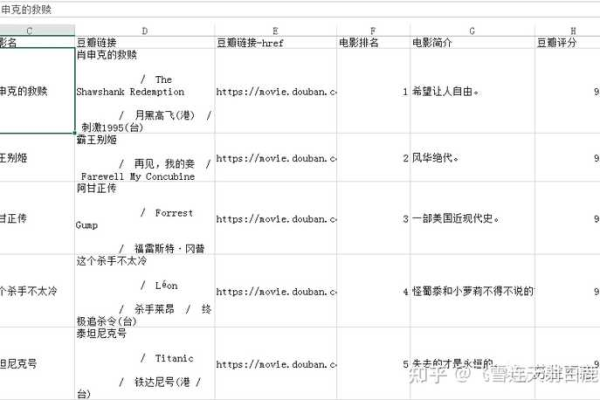

2. 数据映射

将清洗后的数据映射到目标数据库的表中,这可能涉及到字段名的更改、数据类型的转换等。

3. 数据聚合

如果需要,可以对数据进行聚合操作,比如计算总和、平均值、最大值等,以便于后续的分析和应用。

四、数据加载

1. 批量插入

为了提高效率,通常采用批量插入的方式将数据加载到数据库中,这种方法可以减少网络传输次数和数据库的写入操作。

2. 事务管理

使用事务来保证数据的一致性和完整性,如果数据加载过程中出现错误,可以回滚到初始状态,避免部分数据更新导致的数据不一致问题。

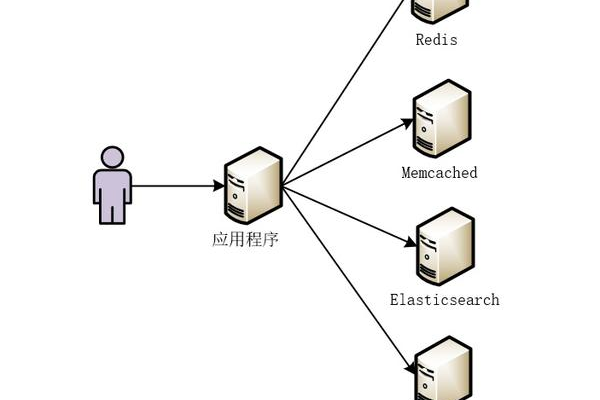

3. 异步处理

对于大规模数据迁移,可以考虑使用异步处理机制,比如消息队列,以提高系统的响应速度和稳定性。

五、维护与优化

1. 索引优化

根据查询需求创建合适的索引,以提高数据检索的速度,定期评估索引的效果,删除不再使用的索引以节省空间。

2. 性能监控

持续监控数据库的性能指标,如响应时间、吞吐量等,及时发现并解决性能瓶颈。

3. 备份与恢复

定期备份数据库,以防数据丢失或损坏,制定详细的灾难恢复计划,确保在紧急情况下能够快速恢复服务。

六、FAQs

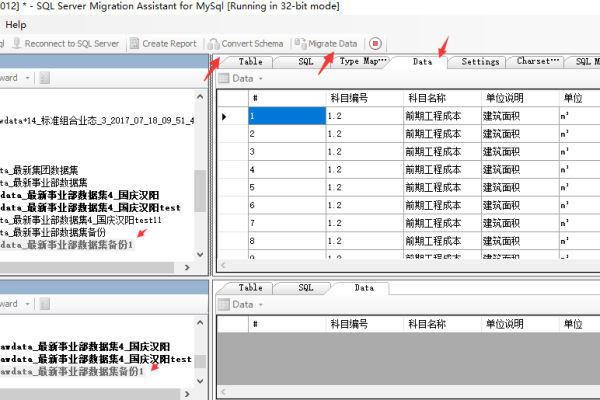

Q1: 如何处理大量数据的迁移?

A1: 处理大量数据迁移时,可以采用分批处理的方式,每次只迁移一部分数据,还可以利用数据库的并行加载功能,或者通过增加硬件资源来提高处理速度。

Q2: 如何确保数据迁移过程中的安全性?

A2: 确保数据迁移过程的安全性可以从以下几个方面入手:使用加密连接传输数据;对敏感数据进行脱敏处理;实施严格的访问控制策略;以及在迁移前后进行数据完整性校验。

小编有话说

数据迁移是一个复杂且关键的过程,它不仅涉及到技术层面的挑战,还需要考虑业务连续性和数据安全性,希望本文能为你提供一个清晰的指导思路,帮助你顺利完成数据迁移任务,如果你有任何疑问或需要进一步的帮助,欢迎随时联系我们!

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/367078.html