CDN联盟是如何改变互联网速度与可靠性的?

- 行业动态

- 2024-10-09

- 2

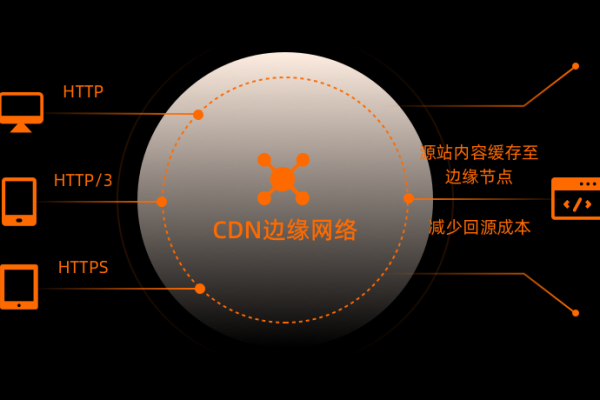

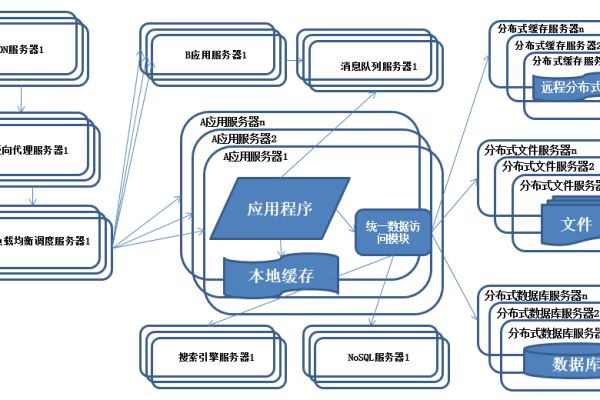

CDN联盟是一个专注于推动内容分发网络(CDN)技术发展和市场普及的民间社团组织,旨在提升互联网流量加速和高防CDN的使用率。

CDN联盟通过举办各类活动和技术交流,促进了CDN产业的深度融合和创新发展,以下是对CDN联盟的详细介绍:

1、成立背景与目的

成立背景:随着互联网的快速发展,特别是高清视频、OTT应用等数据密集型内容的流行,对网络带宽和数据传输速度的要求越来越高,传统的网络架构难以满足这些需求。

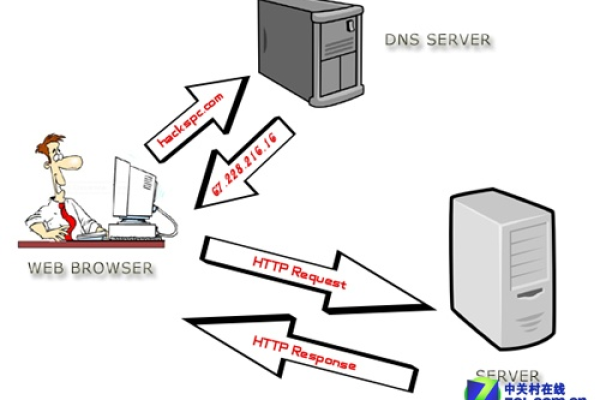

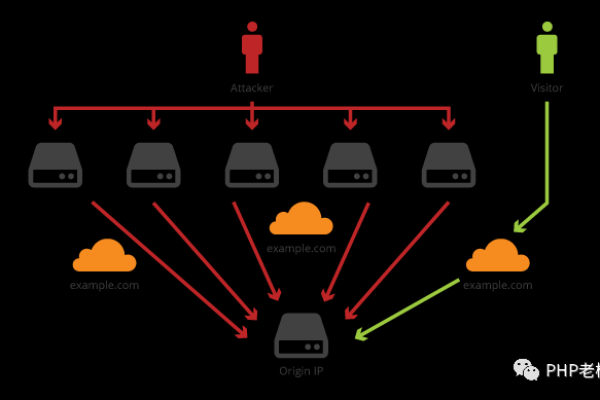

成立目的:为了解决这些问题,CDN联盟应运而生,目的是通过提供CDN服务,降低带宽成本,提高用户体验,并解决小运营商流量劫持等问题。

2、主要成员与活动

主要成员:CDN联盟由网宿科技、阿里云、腾讯云、华为云等代表性企业发起,联合众多行业参与者共同构建内容分发网络生态体系。

主要活动:联盟定期举办亚太内容分发大会暨CDN峰会,这是一个全球内容流量技术和运维领域最重要、规模最大的活动之一,旨在推动CDN节点部署、技术创新和流量成本降低。

3、发展历程与成就

发展历程:从2017年亚太CDN产业联盟的成立到2023年的持续活动,联盟已经成为推动CDN产业发展的重要力量。

成就:在过去几年中,联盟成功举办了多届内容分发大会,促成了千余项内容分发网络项目,推动了CDN技术的普及和应用。

4、未来展望与挑战

未来展望:随着5G时代的到来,CDN联盟将继续推动CDN与RTC互动直播、PCDN边缘计算、内容出海等领域的融合与创新,为CDN产业赋予全新价值。

挑战:面对全球数字化浪潮和企业出海浪潮,CDN联盟需要不断创新,解决新的技术挑战和市场需求,特别是在一带一路战略的背景下,帮助中国互联网企业更好地开拓国际市场。

CDN联盟在推动CDN技术的发展和应用方面发挥了重要作用,通过不断的技术创新和市场推广,联盟不仅提升了用户体验,还为企业提供了高效的流量管理和安全保障解决方案。

| CDN联盟名称 | 成立时间 | 主营业务 | 服务区域 | 合作伙伴 | 核心优势 |

| 中国电信CDN | 2008年 | 内容分发、应用加速、安全防护 | 全国 | 众多企业及个人用户 | 技术实力强、覆盖面广、服务质量高 |

| 阿里云CDN | 2010年 | 内容分发、应用加速、安全防护 | 全国 | 众多企业及个人用户 | 丰富的产品线、强大的计算能力、高效的运维团队 |

| 腾讯云CDN | 2013年 | 内容分发、应用加速、安全防护 | 全国 | 众多企业及个人用户 | 稳定可靠、覆盖全面、价格实惠 |

| 网宿CDN | 2000年 | 内容分发、应用加速、安全防护 | 全国 | 众多企业及个人用户 | 先进的技术、丰富的行业经验、优质的客户服务 |

| UCloud CDN | 2012年 | 内容分发、应用加速、安全防护 | 全国 | 众多企业及个人用户 | 灵活的计费模式、强大的自定义功能、快速响应的客服 |

| 世纪互联CDN | 2006年 | 内容分发、应用加速、安全防护 | 全国 | 众多企业及个人用户 | 专业团队、成熟技术、高效服务 |

| 华为云CDN | 2017年 | 内容分发、应用加速、安全防护 | 全国 | 众多企业及个人用户 | 强大的网络资源、丰富的产品线、优秀的客户体验 |