如何在织梦CMS中一次性添加防采集混淆字符串以增强安全性?

- 行业动态

- 2024-08-31

- 3

rand()函数生成随机数作为混淆字符串。,,“

php,{dede:field.content function='html2text(@me)'/} {php echo rand();},“

在织梦CMS系统中,防止内容被轻易采集是网站管理员常见的需求,为了实现这一目标,可以通过添加混淆字符串的方式来增加采集难度,本文将介绍如何在织梦CMS中只添加一次防采集混淆字符串的方法。

准备工作

在开始之前,需要确保你已经拥有对织梦CMS后台的管理权限,你需要准备一些混淆字符串,这些字符串可以是无意义的字符组合,也可以是特殊符号与文字的混合。

进入后台管理

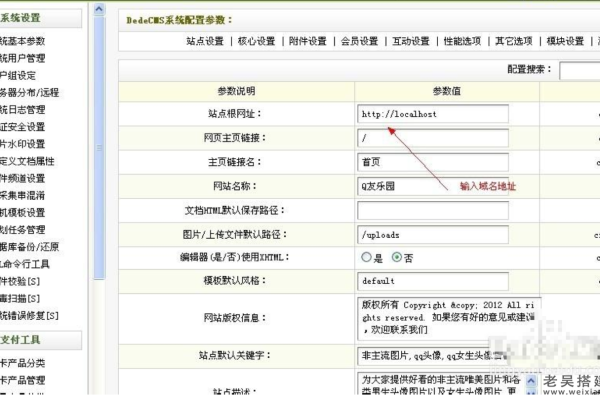

1、登录你的织梦CMS后台管理系统。

2、在后台管理界面中找到“系统”菜单,点击进入。

3、在系统菜单下找到“系统设置”,点击进入系统设置界面。

修改配置文件

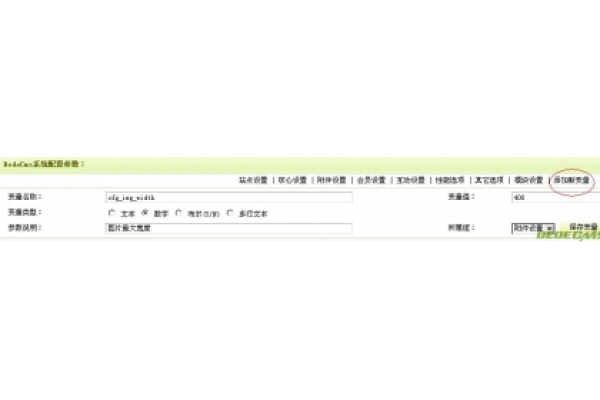

1、在系统设置界面中,找到“核心设置”选项,点击进入。

2、在核心设置中找到“性能选项”,这里包含了多个配置项,包括是否开启页面Gzip压缩、是否生成静态等。

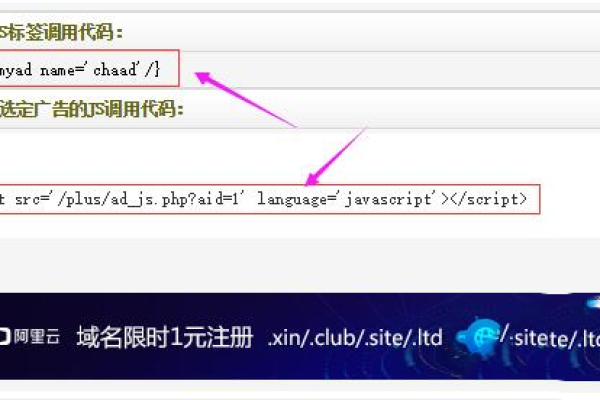

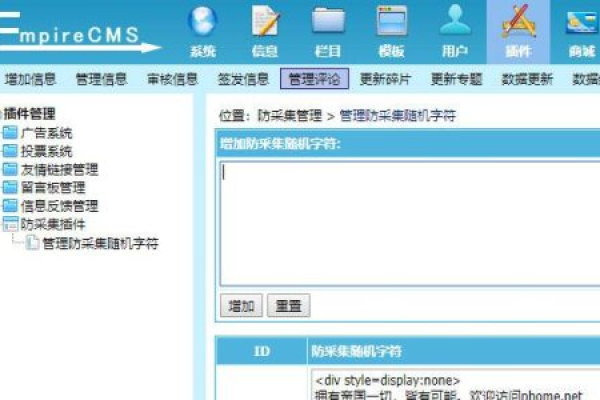

3、找到“防采集混淆字符串”设置项,这个设置项允许你添加一个混淆字符串到每个页面的HTML中,从而干扰采集器的正常工作。

4、输入你准备好的混淆字符串,确认无误后保存设置。

更新缓存

1、保存设置后,通常需要更新系统缓存以使设置生效。

2、返回到系统设置的主界面,找到并点击“更新系统缓存”按钮。

3、等待缓存更新完成,这个过程可能需要几秒钟时间。

验证效果

1、缓存更新完成后,访问你的网站前端页面。

2、查看页面源代码,你应该能在HTML代码中找到你设置的混淆字符串。

3、可以使用采集工具尝试采集页面内容,观察混淆字符串是否起到了预期的防采集效果。

注意事项

1、混淆字符串不宜过长,以免影响页面加载速度和用户体验。

2、定期更换混淆字符串,以避免被采集器适应并绕过防护。

3、除了添加混淆字符串,还可以结合其他防采集措施,如限制IP访问频率、使用验证码等,以增强防护效果。

相关问答FAQs

Q1: 添加混淆字符串后,会影响SEO吗?

A1: 合理使用混淆字符串,不会对SEO造成负面影响,但要注意不要使用过于复杂或长度过长的字符串,因为这可能会影响搜索引擎对页面内容的理解和抓取。

Q2: 如果采集器适应了混淆字符串怎么办?

A2: 如果发现采集器适应了混淆字符串,应该及时更换新的混淆字符串,可以考虑结合其他防采集策略,如限制访问频率、使用验证码等,来提高采集难度。

通过以上步骤,你可以在织梦CMS中有效地添加防采集混淆字符串,从而保护你的网站内容不被轻易采集,需要注意的是,没有一种方法能够完全防止采集,因此建议采取多种措施综合防护。