如何实现MySQL数据库与Hive数据库之间的导入导出?

- 行业动态

- 2024-11-19

- 3

MySQL数据库的导入导出操作是数据管理中的关键步骤,尤其在需要将数据迁移至Hive或从Hive导出到MySQL时,本文将详细介绍如何进行这些操作,并附上常见问题解答。

一、MySQL数据库导入导出

使用命令行工具进行数据导入导出

1.1 使用mysqldump导出数据

mysqldump是一个用于生成数据库备份的实用程序,可以将数据库或表的数据导出为SQL脚本文件。

导出整个数据库:

mysqldump -u root -p example_db > example_db.sql

导出特定表:

mysqldump -u root -p example_db users > users.sql

导出数据和结构:

默认情况下,mysqldump会导出表结构和数据,可以使用--no-data选项仅导出结构,或使用--no-create-info选项仅导出数据:

# 仅导出表结构 mysqldump -u root -p --no-data example_db > example_db_structure.sql # 仅导出数据 mysqldump -u root -p --no-create-info example_db > example_db_data.sql

1.2 使用mysql命令导入数据

导入数据时,可以使用mysql命令读取SQL脚本文件,并将其应用到数据库中。

导入整个数据库:

mysql -u root -p example_db < example_db.sql

导入特定表:

mysql -u root -p example_db < users.sql

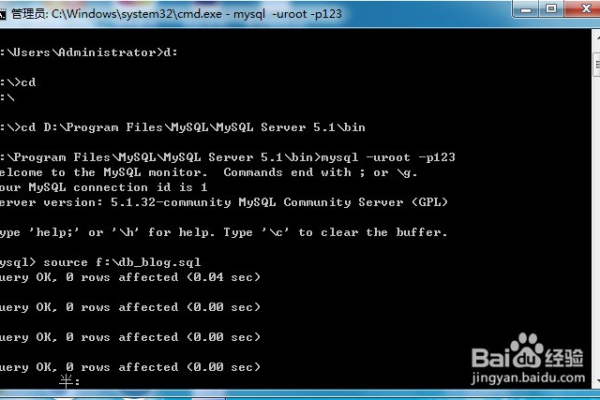

使用source命令导入数据:

在MySQL命令行客户端中,可以使用source命令导入SQL脚本文件:

mysql> source /path/to/example_db.sql;

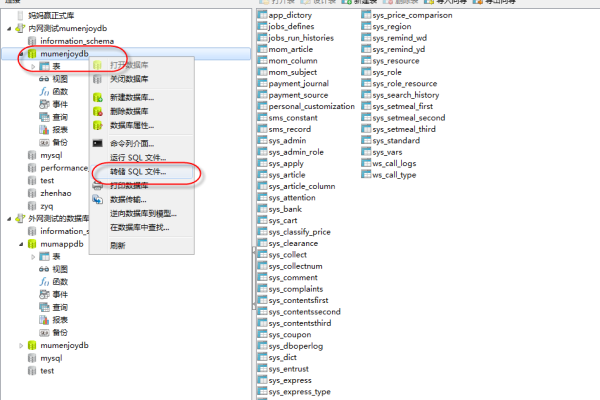

使用图形化工具进行数据导入导出

2.1 使用MySQL Workbench导入导出数据

MySQL Workbench是一个官方的MySQL图形化管理工具,提供了导入导出的方便操作。

导出数据:

1. 打开MySQL Workbench,连接到数据库服务器。

2. 在导航面板中选择要导出的数据库。

3. 右键点击数据库名称,选择Data Export。

4. 在Data Export窗口中,选择要导出的表和导出选项。

5. 点击Start Export按钮,开始导出数据。

导入数据:

1. 打开MySQL Workbench,连接到数据库服务器。

2. 在导航面板中选择要导入数据的数据库。

3. 右键点击数据库名称,选择Data Import/Restore。

4. 在Data Import/Restore窗口中,选择导入文件和导入选项。

5. 点击Start Import按钮,开始导入数据。

2.2 使用phpMyAdmin导入导出数据

phpMyAdmin是一个基于Web的MySQL管理工具,常用于Web服务器环境下的数据库管理。

导出数据:

1. 登录phpMyAdmin,选择要导出的数据库。

2. 点击Export选项卡。

3. 选择导出方法(Quick或Custom)和格式(通常选择SQL)。

4. 点击Go按钮,下载导出的文件。

导入数据:

1. 登录phpMyAdmin,选择要导入数据的数据库。

2. 点击Import选项卡。

3. 选择要导入的文件和格式(通常选择SQL)。

4. 点击Go按钮,开始导入数据。

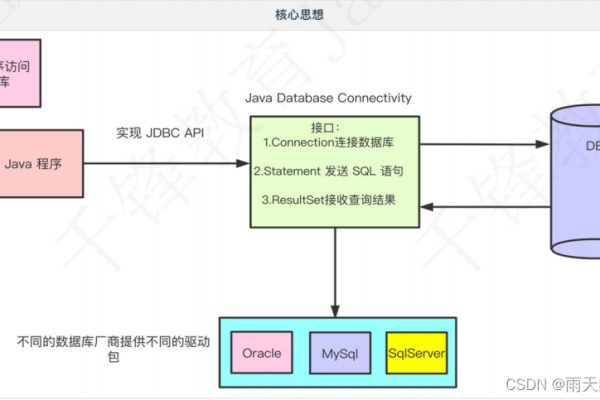

使用编程接口进行数据导入导出

除了手动操作,程序员还可以通过编程接口实现数据的自动化导入导出操作,常用的编程语言包括Python和Java。

3.1 使用Python进行数据导入导出

Python拥有丰富的数据库操作库,如mysql-connector-python和pymysql。

导出数据:

import mysql.connector

# 连接到数据库

conn = mysql.connector.connect(

host='localhost',

user='root',

password='password',

database='example_db'

)

cursor = conn.cursor()

# 执行查询

cursor.execute("SELECT * FROM users")

# 获取结果并写入文件

with open('users_export.csv', 'w') as f:

for row in cursor:

f.write(','.join(map(str, row)) + '

')

cursor.close()

conn.close()

导入数据:

import mysql.connector

# 连接到数据库

conn = mysql.connector.connect(

host='localhost',

user='root',

password='password',

database='example_db'

)

cursor = conn.cursor()

# 读取CSV文件并插入数据

with open('users_import.csv', 'r') as f:

next(f) # skip header

for line in f:

data = line.strip().split(',')

cursor.execute("INSERT INTO users (id, name, branch_name) VALUES (%s, %s, %s)", data)

conn.commit()

cursor.close()

conn.close()

二、MySQL数据导入Hive数据库

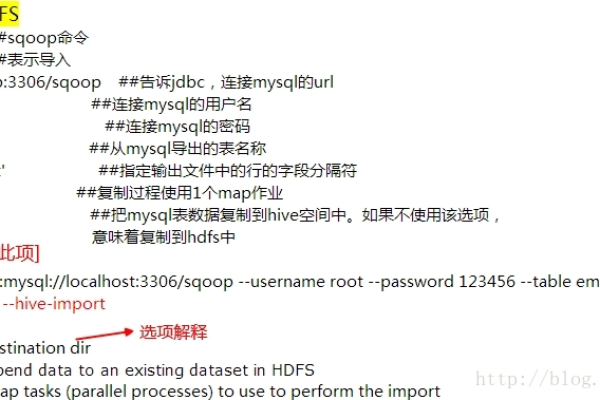

Sqoop简介与安装配置

Apache Sqoop是一个用来将Hadoop和关系型数据库中的数据相互转移的工具,可以将一个关系型数据库(MySQL、Oracle、Postgres等)中的数据导进到Hadoop的HDFS中,也可以将HDFS的数据导进到关系型数据库中,Sqoop专为大数据批量传输设计,能够分割数据集并创建Hadoop任务来处理每个区块。

2. Sqoop将MySQL数据导入Hive的步骤

假设我们已经在Hive中创建了相应的表,并且表结构与MySQL中的表结构一致,以下是具体的导入步骤:

2.1 Sqoop导入数据到HDFS

使用Sqoop将MySQL数据导入到HDFS中,假设我们要将MySQL中的people_access_log表导入到HDFS中,并保存为一个文本文件。

sqoop import --connect jdbc:mysql://master1.hadoop:3306/test --username root --password password --table people_access_log --target-dir /user/hive/warehouse/web/people_access_log --fields-terminated-by 't' --num-mappers 1 --delete-target-dir --compression-codec org.apache.hadoop.io.compress.SnappyCodec

上述命令解释如下:

--connect:指定MySQL连接信息。

--username和--password:MySQL用户名和密码。

--table:要导入的MySQL表名。

--target-dir:HDFS目标目录。

--fields-terminated-by:字段分隔符,这里使用制表符(t)。

--num-mappers:并行导入启用的map任务数量。

--delete-target-dir:如果目标目录存在,则删除,相当于overwrite。

--compression-codec:压缩编解码器,这里使用Snappy编解码器。

2.2 Hive加载数据

将HDFS中的数据加载到Hive表中,假设我们在Hive中已经创建了一个名为web.people_access_log的表,并且表结构与MySQL中的表结构一致,我们可以使用load data命令将数据加载到Hive表中。

LOAD DATA INPATH '/user/hive/warehouse/web/people_access_log' [OVERWRITE] INTO TABLE web.people_access_log;

上述命令解释如下:

LOAD DATA INPATH:指定HDFS中的数据文件路径。

[OVERWRITE]:可选参数,表示覆盖表中已有的数据,如果不加此参数,则会追加数据到表中。

INTO TABLE:指定目标Hive表名。

Hive数据导入MySQL数据库

Sqoop同样支持将Hive表中的数据导入到MySQL数据库中,假设我们要将Hive中的people_access_log表导出到MySQL中的people_access_log_out表中,以下是具体的导出步骤:

3.1 确保MySQL表存在且结构一致

在MySQL中创建一个与Hive表结构相同的表。

CREATE TABLE people_access_log_out LIKE people_access_log;

3.2 Sqoop导出数据到MySQL

使用Sqoop将Hive表中的数据导出到MySQL中,假设我们要将Hive中的people_access_log表导出到MySQL中的people_access_log_out表中,可以使用以下命令:

sqoop export --connect jdbc:mysql://master1.hadoop:3306/test --username root --password password --table people_access_log_out --export-dir /user/hive/warehouse/web/people_access_log --input-fields-terminated-by 't' --num-mappers 1 --update-key column_name --update-mode allowinsert --staging-table test.people_access_log_tmp --merge-key column_name --input-null-string '\N' --input-null-non-string '\N' --compress --compression-codec org.apache.hadoop.io.compress.SnappyCodec --direct --driver sqoop.management.SqlManager --split-by column_name --verbose --fields-terminated-by 't' --lines-terminated-by ' ' --input-lines-terminated-by ' ' --batch --hive-table web.people_access_log --hive-overwrite --hive-execution-engine mr --hive-drop-import-delims --create-hive-table --hive-database default --hive-table default.people_access_log --hive-partition-key column_name --hive-partition-value partition_value --hive-partitions partitions_number --hive-execution-engine mr --hive-drop-import-delims --create-hive-table --hive-database default --hive-table default.people_access_log --hive-partition-key column_name --hive-partition-value partition_value --hive-partitions partitions_number --hive-execution-engine mr --hive-drop-import-delims --create-hive-table --hive-database default --hive-table default.people_access_log --hive-partition-key column_name --hive-partition-value partition_value --hive-partitions partitions_number --hive-execution-engine mr --hive-drop-import-delims --create-hive-table --hive-database default --hive-table default.people_access_log --hive-partition-key column_name --hive-partition-value partition_value --hive-partitions partitions_number --hive-execution-engine mr --hive-drop-import-delims --create-hive-table --hive-database default --hive-table default.people_access_log --hive-partition-key column_name --hive-partition-value partition_value --hive-partitions partitions_number --hive-execution-engine mr --hive-drop-import-delims --create-hive-table --hive-database default --hive-table default.people_access_log --hive-partition-key column_name --hive-partition-value partition_value --hive-partitions partitions_number --hive-execution-engine mr --hive-drop-import-delims --create-hive-table --hive-database default --hive-table default.people_access_log --hive-partition-key column_name --hive-partition-value partition_value --hive-partitions partitions_number --hive-execution-engine mr --hive-drop-import-delims --create-hive-table --hive-database default --hive-table default.people_access_log --hive-partition-key column_name --hive-partition-value partition_value --hive-partitions partitions_number --hive-execution-engine mr --hive-drop-import-delims --create-hive-table --hive-database default --hive-table default.people_access_log --hive-partition-key column_name --hive-partition-value partition_value --hive-partitions partitions_number --hive-execution-engine mr --hive-drop-import-delims --create-hive-table --hive-database default --hive-table default.people_access_log --hive-partition-key column_name --hive-partition-value partition_value --hive-partitions partitions_number --hive-execution-engine mr --hive-drop-import-delims --create-hive-table --hive-database default --hive-table default.people_access_log --hive-partition-key column_name --hive-partition-value partition_value --hive-partitions partitions_number --hive-execution-engine mr --hive-drop-import-delims --create-hive-table --hive-database default --hive-table default.people_access_log --hive-partition-key column_name --hive-partition-value partition_value --hive-partitions partitions_number og```

以上内容就是解答有关“mysql数据库导入导出_导入导出Hive数据库”的详细内容了,我相信这篇文章可以为您解决一些疑惑,有任何问题欢迎留言反馈,谢谢阅读。