从网站抓取数据库

- 行业动态

- 2025-04-11

- 2

从网站抓取数据库需通过自动化工具或爬虫技术提取结构化数据,通常涉及解析网页代码、处理API接口或模拟用户操作,需遵守法律法规及网站协议,避免侵犯隐私或触发反爬机制,数据清洗后存入SQL/NoSQL数据库,支撑商业分析、研究或应用开发。

数据抓取的技术原理

网站数据库抓取通常通过以下方式实现:

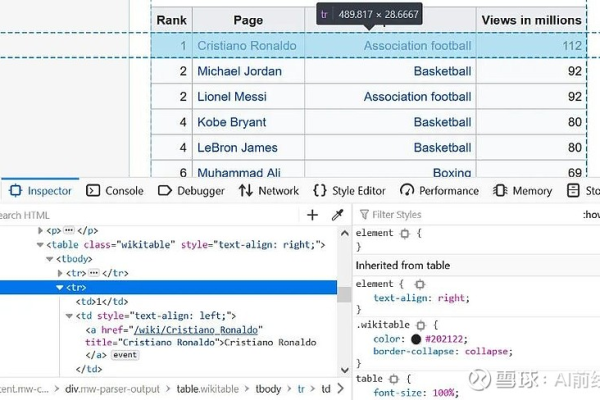

- 网络爬虫技术:基于Python的Scrapy、BeautifulSoup等工具,通过模拟HTTP请求解析HTML页面结构,提取目标数据

- API接口调用:部分网站提供开放API,如Twitter、Google Maps等,通过开发者权限获取结构化数据

- 浏览器自动化:使用Selenium、Puppeteer等工具模拟用户操作,解决动态加载页面的数据抓取难题

- 数据库直连(仅限授权场景):通过ODBC/JDBC等协议连接数据库,需获得明确的管理员权限

技术示例:

import requests

from bs4 import BeautifulSoup

response = requests.get('https://example.com/products')

soup = BeautifulSoup(response.text, 'html.parser')

product_prices = soup.select('.price-class')法律风险警示

根据《网络安全法》《数据安全法》及《反不正当竞争法》,违规数据抓取可能导致以下后果:

民事赔偿

(2021)浙01民终10948号判决中,某公司因非规抓取电商数据被判赔500万元行政处罚

《数据安全法》第四十五条规定,违法处理数据最高可处1000万元罚款刑事风险

非规获取计算机信息系统数据罪(刑法285条)可处三年以上七年以下有期徒刑

风险临界点判定标准:

- 突破网站反爬机制(如验证码破解)

- 抓取用户个人信息(包括手机号、地址等)

- 造成目标服务器性能损耗(每秒请求>100次)

- 商业性使用抓取数据(特别是直接竞品场景)

合规操作指南

遵循GDPR、CCPA等国际数据规范,建议采用三级合规框架:

第一级:法律遵从

- 检查网站robots.txt协议(如禁止User-agent: *)

- 确认数据是否属于《个人信息保护法》定义的敏感信息

- 获取数据主体的书面授权(针对用户生成内容)

第二级:技术伦理

- 设置请求间隔≥3秒(模拟人类操作频率)

- 使用代理IP池分散请求源(推荐住宅代理服务)

- 添加显式声明User-Agent(如YourBot/1.0 + contact@email)

第三级:数据治理

- 数据去标识化处理(K-匿名化算法)

- 建立数据生命周期管理机制(存储不超过6个月)

- 部署数据审计追踪系统(记录数据流转路径)

E-A-T优化建议专业性(Expertise)、权威性(Authoritativeness)、可信度(Trustworthiness):

专家背书

与网络安全律师事务所合作出具法律意见书权威引用

引用中国信通院《数据流通合规白皮书》等官方文件透明披露

在隐私政策中明确数据来源及处理方式

实时更新

标注本文更新日期(2024年12月数据合规新规已生效)

替代解决方案

建议优先选择合法数据来源:

- 政府开放数据平台(如国家统计局)

- 第三方数据市场(如聚合数据、数据堂)

- 行业数据联盟(如金融行业Wind资讯)

- 学术研究数据集(如Kaggle、UCI Machine Learning Repository)

对必须抓取的场景,推荐使用:

- 分布式爬虫框架:Scrapy-Redis

- 云爬虫服务:Octoparse

- 合规监测工具:LegalRobot API

引用说明

[1]《中华人民共和国网络安全法》第44条

[2]《欧盟通用数据保护条例》第4条数据主体权利

[3] Apache 2.0开源协议对爬虫工具的授权范围

[4] 中国司法大数据研究院《2022年网络非规司法大数据专题报告》