bp神经网络流程

- 行业动态

- 2025-04-11

- 3

BP神经网络(Back Propagation Neural Network)是深度学习领域最基础且广泛应用的模型之一,其核心思想通过“反向传播误差”调整网络参数,实现输入数据到输出结果的精准映射,以下从流程拆解、算法原理到实际应用,完整解析其工作机制。

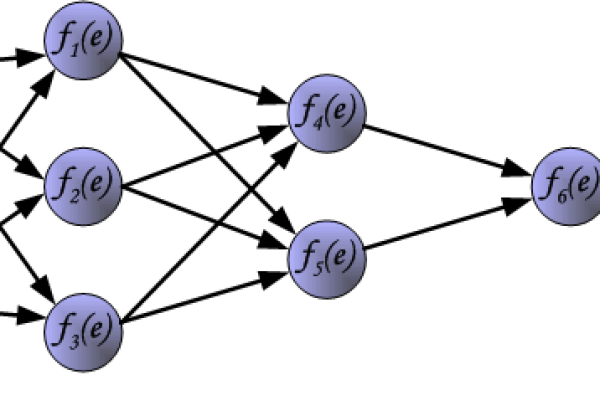

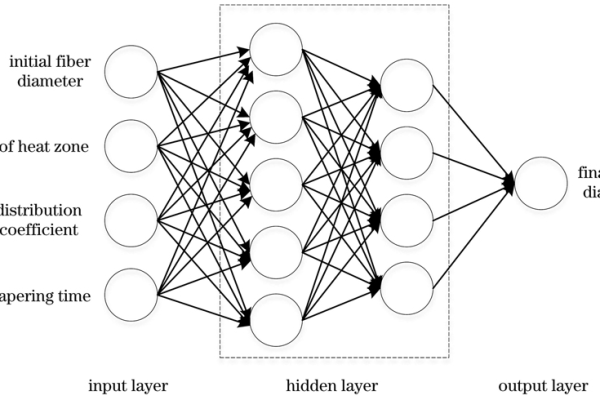

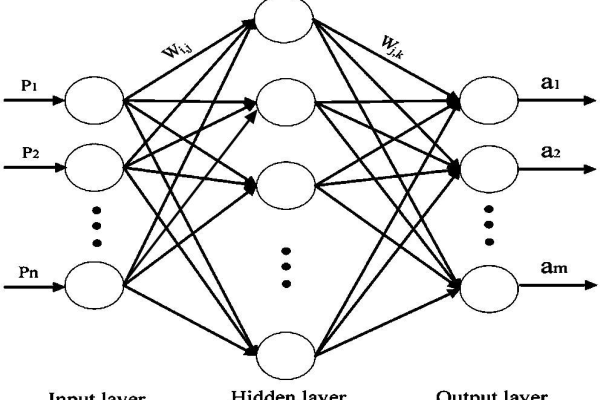

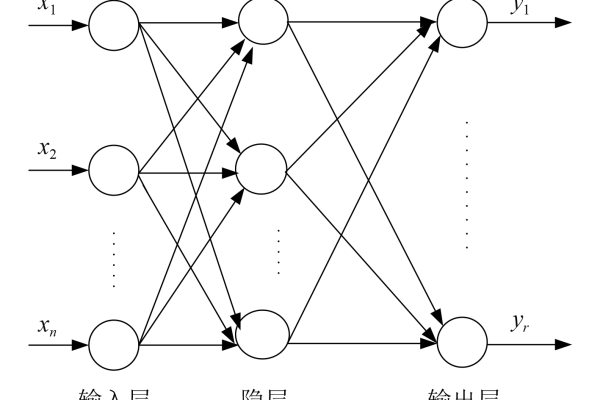

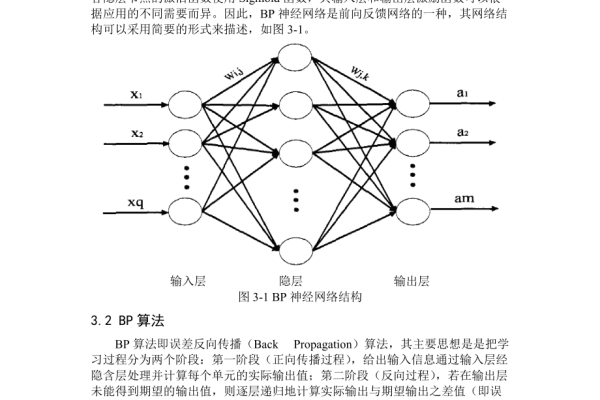

BP神经网络的核心组成

BP神经网络包含三层结构:输入层、隐含层、输出层,每层由多个神经元(节点)构成,神经元之间通过权重连接,信号传递过程如下:

- 输入层:接收原始数据(如图像像素、文本特征)。

- 隐含层:对输入数据进行非线性变换,提取高阶特征(通常需多层隐含层提升模型复杂度)。

- 输出层:生成最终预测结果(如分类标签、回归值)。

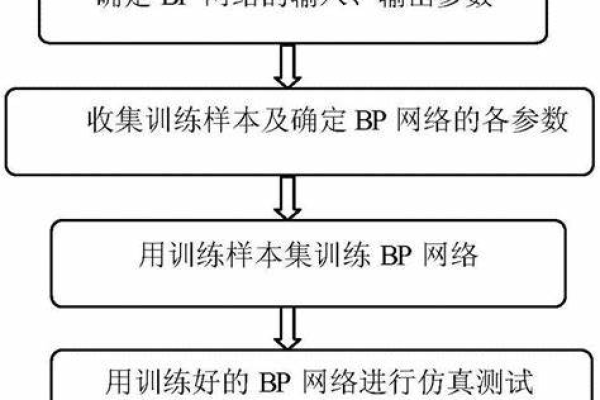

BP神经网络的完整流程

步骤1:前向传播(Forward Propagation)

输入数据从输入层逐层传递至输出层,每个神经元执行以下计算:

[

text{输出值} = fleft( sum_{i=1}^{n} (w_i cdot x_i) + b right)

]

- (w_i):权重参数

- (x_i):输入信号

- (b):偏置项

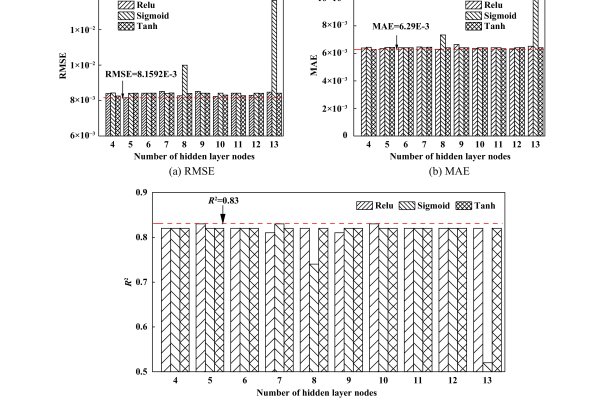

- (f):激活函数(如Sigmoid、ReLU),引入非线性表达能力。

示例:输入图像像素值,经隐含层计算后,输出层给出“猫/狗”的概率预测。

步骤2:计算损失值(Loss Calculation)

通过损失函数(Loss Function)衡量预测结果与真实值的差距,常用函数包括:

- 均方误差(MSE):适用于回归问题

- 交叉熵损失(Cross-Entropy):适用于分类问题

损失值越小,模型精度越高,分类任务中若真实标签为“猫”,而模型预测“猫”的概率为0.2,则交叉熵损失会显著增大。

步骤3:反向传播(Backward Propagation)——误差反馈的核心

通过链式法则逐层计算损失对每个权重参数的梯度,明确参数调整方向:

- 输出层梯度:计算损失对输出层权重的偏导数。

- 隐含层梯度:将输出层误差反向传递至隐含层,计算隐含层权重的偏导数。

数学原理:

[

frac{partial L}{partial w_i} = frac{partial L}{partial y} cdot frac{partial y}{partial z} cdot frac{partial z}{partial w_i}

]

- (L):损失函数

- (y):输出层结果

- (z):神经元的加权输入

步骤4:参数更新(Weights Update)

使用梯度下降法(Gradient Descent)调整权重与偏置,逐步降低损失值:

[

w{text{new}} = w{text{old}} – eta cdot frac{partial L}{partial w}

]

- (eta):学习率(控制参数更新步长)

- (frac{partial L}{partial w}):梯度方向

优化策略:

- 动态学习率(如Adam优化器)

- 批量训练(Mini-Batch)加速收敛

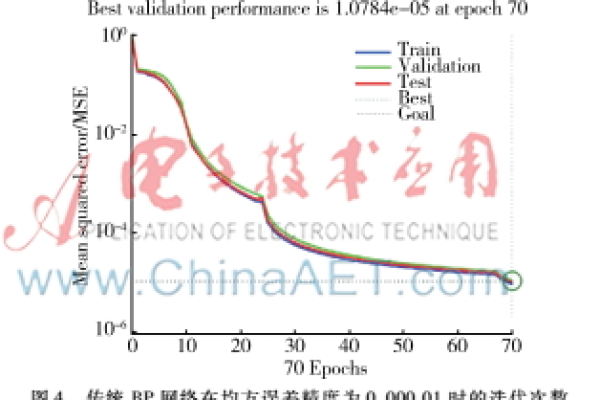

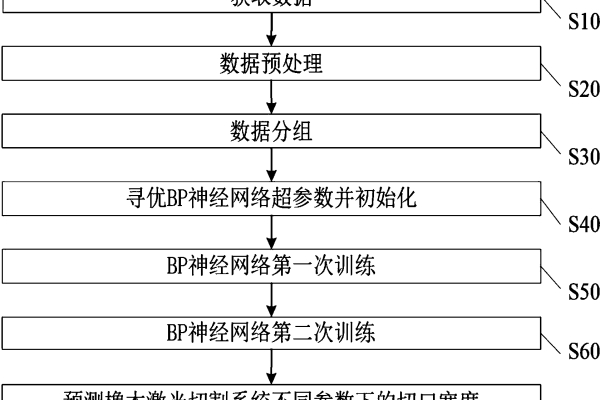

步骤5:迭代训练与验证

- 训练阶段:重复前向传播→计算损失→反向传播→参数更新,直至模型收敛(损失值稳定)。

- 验证阶段:使用验证集评估模型泛化能力,防止过拟合(如准确率、F1值)。

BP神经网络的关键问题与解决方案

| 问题类型 | 表现 | 解决方案 |

|---|---|---|

| 梯度消失 | 深层网络梯度接近0,参数无法更新 | 使用ReLU激活函数、残差连接 |

| 过拟合 | 训练集精度高,测试集精度低 | 引入Dropout、L2正则化 |

| 局部最优 | 损失函数陷入局部最小值 | 增加动量项(Momentum)、随机初始化参数 |

BP神经网络的实际应用场景

- 图像识别:手写数字分类(MNIST数据集)。

- 自然语言处理:文本情感分析、机器翻译。

- 金融预测:股票价格趋势预测、风险评估。

BP神经网络通过“前向传播预测结果、反向传播调整参数”的闭环机制,模拟人脑学习过程,其核心优势在于强大的非线性拟合能力,但需结合正则化、优化算法解决训练中的梯度问题,随着深度学习发展,BP思想被广泛应用于CNN、RNN等复杂模型中,成为现代人工智能的基石。

引用说明

- Rumelhart, D. E., Hinton, G. E., & Williams, R. J. (1986). 《Learning representations by back-propagating errors》. Nature.

- Goodfellow, I., Bengio, Y., & Courville, A. (2016). 《Deep Learning》. MIT Press.