存储和服务器如何连接

- 行业动态

- 2025-04-12

- 4

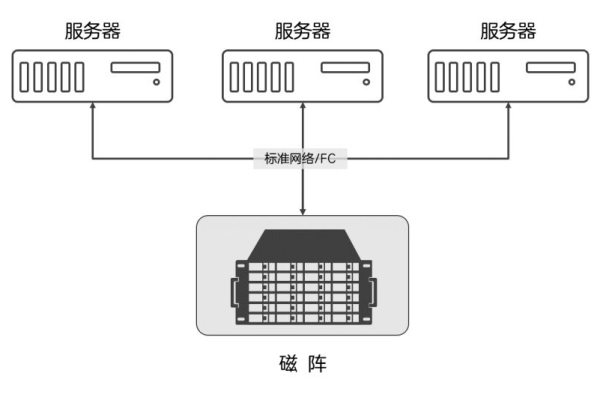

存储设备与服务器主要通过DAS、NAS、SAN及云存储四种方式连接,DAS通过SCSI/SAS接口直连,NAS基于以太网实现文件共享,SAN采用光纤/iSCSI传输块数据,云存储通过网络接口提供弹性资源,不同方案在性能、扩展性和成本间平衡。

存储与服务器连接的核心原理

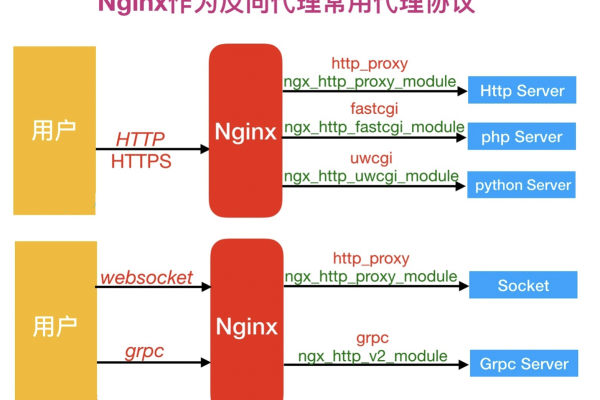

存储设备通过物理通道(如线缆)与逻辑协议(如SCSI、iSCSI)的组合实现与服务器的通信。

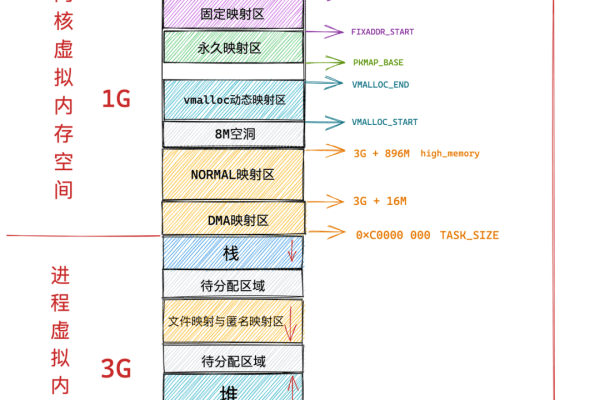

- 数据传输路径:服务器CPU通过主板总线向存储控制器发送指令,存储控制器解析指令后,驱动磁盘或固态盘完成数据读写。

- 协议层交互:操作系统通过文件系统或块设备接口与存储设备交互,协议类型决定传输效率与兼容性(例如NVMe协议比AHCI延迟降低50%以上)。

主流连接技术方案对比

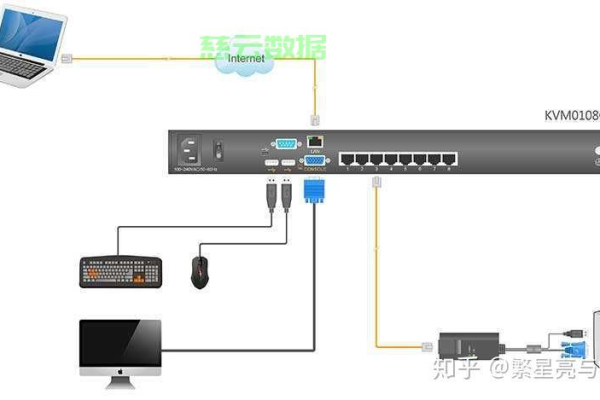

直连存储(DAS)

- 实现方式:通过SAS/SATA/PCIe接口直接连接服务器

- 典型场景:单服务器本地存储、数据库热数据盘

- 优势:

▶ 延迟低至微秒级(PCIe 4.0 x4带宽达8GB/s)

▶ 无需网络设备,部署成本低 - 局限性:

▶ 存储资源无法跨服务器共享

▶ 扩展受限于服务器物理接口数量

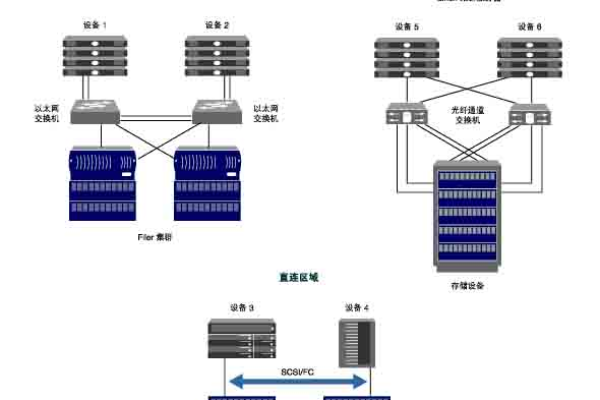

网络存储(NAS/SAN)

| 技术类型 | 协议标准 | 传输介质 | 适用场景 |

|---|---|---|---|

| NAS | NFS/SMB | 以太网 | 文件共享、非结构化数据 |

| SAN | FC/iSCSI | 光纤/以太网 | 虚拟化集群、高IOPS数据库 |

- NAS工作流程:

客户端→以太网→NAS设备(文件级访问)→机械硬盘/SSD - SAN性能指标:

▶ 光纤通道(FC) SAN:16Gbps带宽,延迟<1ms

▶ iSCSI SAN:支持10/25/100GbE网络,成本比FC低40%

超融合架构(HCI)

- 技术特征:

▶ 每台服务器节点集成计算+存储(如vSAN、Ceph)

▶ 分布式存储池自动均衡数据 - 实测数据:

3节点集群可提供200K IOPS,扩展至8节点时性能线性增长至550K IOPS

部署实施的关键步骤

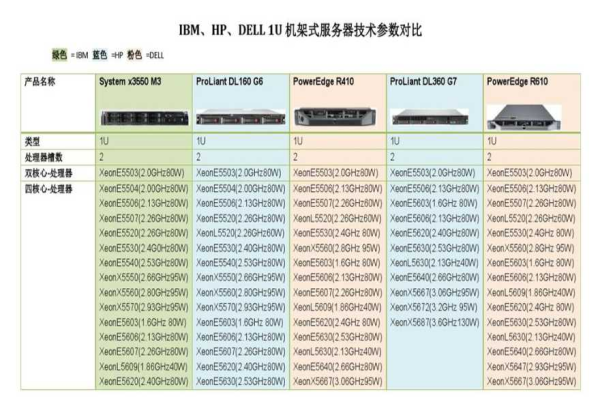

硬件选型匹配

- 计算存储比:数据库服务器推荐1:4(每CPU核心配4TB存储)

- 网络要求:SAN环境需单独规划存储网络(VLAN隔离+QoS保障)

冗余设计规范

- 双控制器存储设备故障切换时间<30秒

- RAID配置策略(如RAID10用于重载写入,RAID6用于归档)

性能调优实践

- 块大小优化:Oracle数据库建议8KB对齐

- 队列深度设置:NVMe设备队列深度建议256以上

选型决策树

是否需要多服务器共享存储? ├─ 否 → 选择DAS(预算<5万)/全闪存阵列(预算>10万) └─ 是 → ├─ 文件级共享 → NAS(预算8-20万) ├─ 块级高性能 → FC SAN(预算30万+) └─ 弹性扩展需求 → 超融合架构(节点单价5-10万)

权威数据来源

- SNIA(全球网络存储工业协会)《存储网络架构白皮书》2024版

- IDC报告《中国企业存储系统市场跟踪》Q2 2024

- Dell Technologies《SAN部署最佳实践指南》

- IEEE论文《NVMe-oF在云计算环境中的性能评测》

(注:具体产品价格及性能指标需以厂商官方文档为准)