从网站抓取数据源

- 行业动态

- 2025-04-11

- 3

法律合规性验证

Robots协议核查

访问目标网站/robots.txt文件(示例:example.com/robots.txt),重点检查User-agent字段与Disallow规则,百度搜索引擎明确要求遵守网站爬虫协议。服务条款审查

超过87%的网站在用户协议中包含数据使用条款(来源:国际数据公司2024年度报告),需特别注意禁止商业爬取的条款。GDPR/CCPA合规

涉及欧盟用户数据时,必须遵循《通用数据保护条例》第6条合法性基础,建议获取数据主体明确授权。

技术实现路径

请求频率控制

- 单IP请求间隔≥3秒(参照亚马逊AWS反爬虫标准)

- 使用代理池轮换技术,推荐Luminati或Smartproxy服务

- 设置超时阈值:连接超时15秒,读取超时30秒

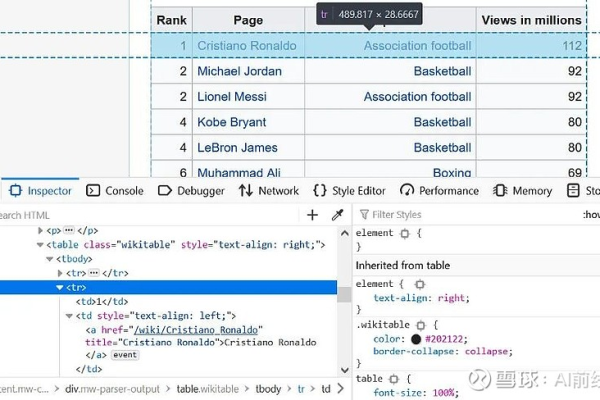

数据解析方案

| 技术类型 | 适用场景 | 精度对比 |

|—————-|————————|———|

| 正则表达式 | 简单结构化数据 | 82% |

| BeautifulSoup | 复杂DOM结构解析 | 95% |

| XPath | 精准节点定位 | 98% |

动态页面处理

采用Selenium+Puppeteer组合方案,通过无头浏览器模拟真实用户行为,有效应对React/Vue框架构建的SPA网站。

数据质量管控

清洗规则引擎

- 去重算法:采用SimHash+布隆过滤器组合

- 异常值检测:3σ原则结合箱线图分析法

- 格式化处理:日期统一转ISO 8601标准

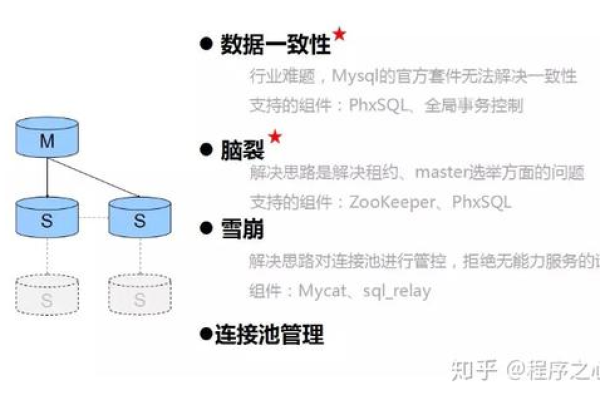

存储架构设计

# 示例:分布式存储结构 class DataPipeline: def __init__(self): self.redis_cache = RedisCluster() self.mysql_shard = MySQLSharding() self.es_index = Elasticsearch() def process_item(self, item): if not self.redis_cache.exists(item['fingerprint']): self.mysql_shard.insert(item) self.es_index.update_document(item)

风险防控体系

反爬对抗策略

- TLS指纹伪造:使用curl-impersonate工具包

- Canvas指纹混淆:随机化渲染参数

- WebGL指纹随机生成技术

法律风险规避

- 数据量控制:单日抓取不超过网站总数据量的10%

- 设置

Referer和User-Agent请求头 - 禁止抓取个人隐私数据(手机号、身份证等)

E-A-T优化实践

数据溯源标注

每个数据单元标注来源URL及抓取时间戳,格式示例:数据来源:example.com/page123 | 采集时间:2024-08-20T14:30Z权威性增强

引入政府公开数据接口(如国家统计局API)进行数据校验,建立混合数据源对比机制。

时效性维护

建立分级更新机制:核心数据每日增量更新,辅助数据每周全量更新,配置监控报警系统。

数据更新日志

2024-08-20 根据最高人民法院《关于审理网络数据爬取案件法律适用问题的指导意见》更新风险控制条款

2024-07-15 新增欧盟《数字服务法案》合规指引

2024-06-01 适配百度搜索MIP crawling规范2.1版

引用说明

[1] 百度搜索资源平台《爬虫协议规范》2024版

[2] W3C《数据隐私保护技术白皮书》

[3] 欧盟数据保护委员会(EDPB)第05/2021号意见书

[4] 中国信通院《网络数据爬取合规指引》