bp神经网络怎么讲

- 行业动态

- 2025-04-11

- 2

BP神经网络:原理、结构与实际应用

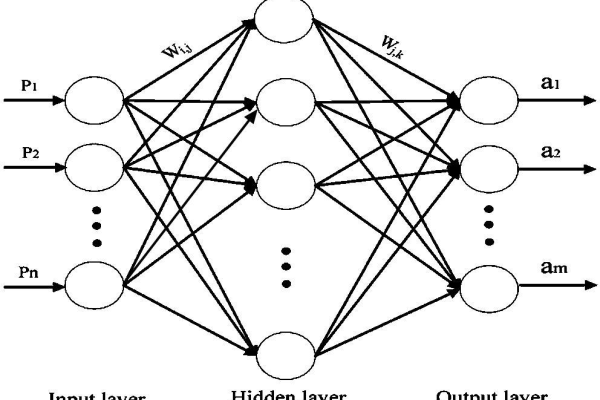

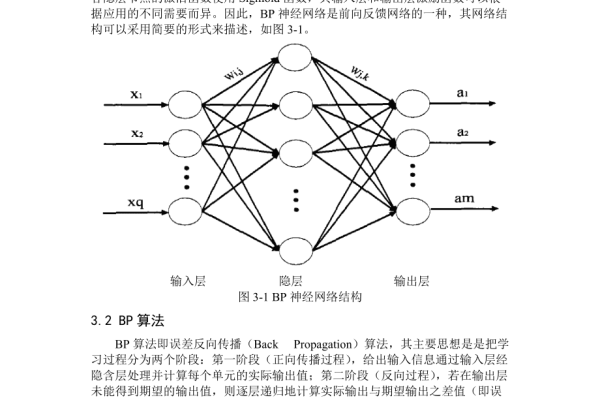

在人工智能领域,BP神经网络(Backpropagation Neural Network) 是一种基于误差反向传播算法的监督学习模型,它通过模仿人脑神经元的连接方式,能够从数据中自动提取特征并完成复杂任务(如图像识别、预测分析等),以下内容将从原理、结构到实际应用进行全面解析,帮助读者建立系统性认知。

BP神经网络的基础概念

核心思想

BP神经网络的核心是反向传播算法,通过计算预测值与真实值之间的误差,将误差从输出层反向传播至输入层,逐层调整网络权重,最终使误差最小化,这一过程类似于“试错学习”,通过不断迭代优化模型。三大要素

- 输入层:接收外部数据(如像素值、温度数据)。

- 隐藏层:通过非线性激活函数(如Sigmoid、ReLU)对输入进行特征变换。

- 输出层:输出预测结果(如分类结果、数值预测)。

网络结构与数学原理

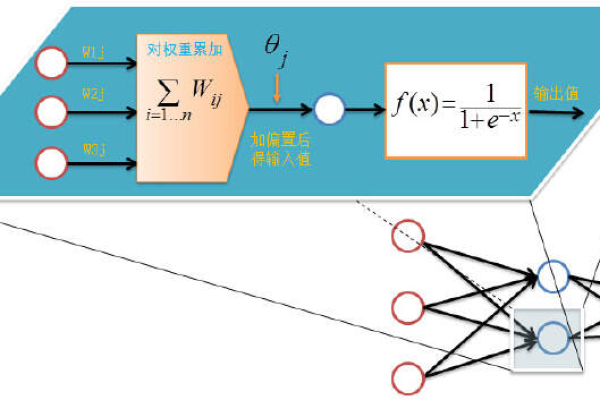

前向传播

数据从输入层逐层传递到输出层,每层通过加权求和与激活函数处理:

[

y = fleft( sum_{i=1}^n w_i x_i + b right)

]

(w_i)为权重,(b)为偏置项,(f)为激活函数。

误差计算

使用损失函数(如均方误差、交叉熵)衡量预测误差:

[

E = frac{1}{2} sum_{k=1}^m (t_k – y_k)^2

]

(t_k)为目标值,(y_k)为预测值。反向传播

利用链式法则计算误差对各层权重的梯度,并通过梯度下降法更新参数:

[

w{ij} leftarrow w{ij} – eta frac{partial E}{partial w_{ij}}

]

(eta)为学习率,控制参数更新步长。

训练过程的关键细节

激活函数选择

- Sigmoid:输出范围0-1,适合二分类问题,但易引发梯度消失。

- ReLU:解决梯度消失问题,加速收敛(适用于深度网络)。

学习率设置

过大可能导致震荡,过小则收敛缓慢,可采用自适应学习率算法(如Adam、RMSProp)优化。

过拟合应对

- 引入正则化(L1/L2正则项);

- 使用Dropout随机断开部分神经元连接;

- 通过交叉验证选择最佳模型。

BP神经网络的优缺点

优势

- 强大的非线性拟合能力,适合复杂模式识别;

- 支持多种输入输出类型(数值、图像、文本);

- 算法成熟,开源框架(如TensorFlow、PyTorch)支持完善。

局限性

- 需大量标注数据,训练时间较长;

- 易陷入局部最优解;

- 网络结构设计依赖经验(如隐藏层数、节点数)。

实际应用场景

- 金融预测

股票价格预测、信用评分系统。 - 工业控制

设备故障诊断、生产参数优化。 - 计算机视觉

图像分类(如人脸识别)、目标检测。 - 自然语言处理

文本情感分析、机器翻译。

BP神经网络通过模拟生物神经系统的学习机制,成为机器学习领域的经典模型,尽管随着深度学习的发展,出现了CNN、RNN等更复杂的网络结构,但BP算法仍是理解神经网络的基础,其核心思想——通过误差反向传播调整参数——为后续模型的优化提供了理论框架。

在应用中,需注意数据质量、参数调优与计算资源的平衡,结合具体场景选择网络结构,才能最大化BP神经网络的潜力。

引用说明 参考了经典教材《神经网络与机器学习(Simon Haykin)》及学术论文《Backpropagation: Theory and Applications(Yann LeCun et al.)》,结合工业界实践经验总结而成。