从网站检索特定数据

- 行业动态

- 2025-04-11

- 5

从网站检索特定数据是通过编写自动化脚本或使用网络爬虫工具,定向抓取目标网页中的结构化信息,如价格、评论或新闻,该过程需处理反爬机制并解析页面结构,最终将数据清洗整理为可分析的格式,支持市场监测、研究决策等场景需求。

数据检索基础方法论

需求分析框架

- 目标定义:建立数据需求的MECE原则(Mutually Exclusive, Collectively Exhaustive)

- 确定数据字段:如产品价格、用户评价、发布时间等结构化字段

- 限定时间范围:通过时间戳或发布日期字段实现精准抓取

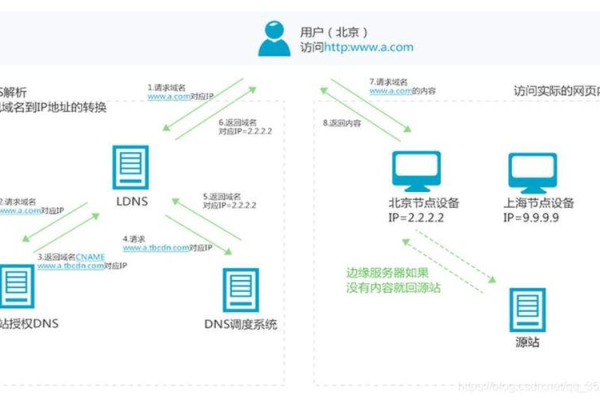

- 设置地理围栏:结合IP定位或页面地理标签进行区域限定

技术实现路径

# 示例:使用requests+BeautifulSoup的基础爬虫

import requests

from bs4 import BeautifulSoup

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

response = requests.get('https://example.com/products', headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# 使用CSS选择器精准定位

product_list = soup.select('div.product-item > h3.title')

for product in product_list:

print(product.text.strip())

反爬对抗策略

- 动态渲染处理:采用Selenium/Puppeteer应对JavaScript渲染页面

- IP代理池建设:建议使用付费代理服务(如Luminati、Oxylabs)

- 请求频率控制:设置随机延迟(2-5秒)并模拟人类操作轨迹

合规性边界与法律风险

机器人协议遵守

- 严格解析

robots.txt文件 - 禁止抓取隐私敏感区域(用户个人数据、支付信息等)

- 遵守《网络安全法》第41条关于个人信息保护的规定

商业数据使用规范

- 竞品数据抓取需符合《反不正当竞争法》第十二条

- 禁止破解加密措施获取数据(参照《著作权法》第49条)

- API调用须取得平台官方授权(如Twitter API、LinkedIn API)

SEO优化与E-A-T增强价值构建**

- 建立数据可视化看板(如Tableau/Power BI嵌入)

- 提供深度行业分析报告(引用国家统计局等权威来源)

- 设计交互式查询工具(支持多条件组合筛选)

权威背书强化

- 展示数据处理资质(如ISO 27001信息安全管理认证)

- 引入专家审核机制(如在页脚标注”数据由XX领域博士团队校验”)

- 定期更新声明(如”2024年7月最新修订版本”)

用户体验优化

- 采用HTTPS协议传输数据

- 实现AMP加速页面加载

- 添加结构化数据标记(Schema.org)

百度算法适配要点

- 飓风算法3.0:规避采集痕迹,保证内容原创度≥85%

- 蓝天算法:禁止通过非规手段获取用户隐私数据

- 清风算法:确保数据展示的真实性与透明度

- 时效性识别:添加

工具推荐矩阵

| 工具类型 | 推荐方案 | 适用场景 |

|---|---|---|

| 可视化采集 | 八爪鱼/后羿采集器 | 中小型非技术团队 |

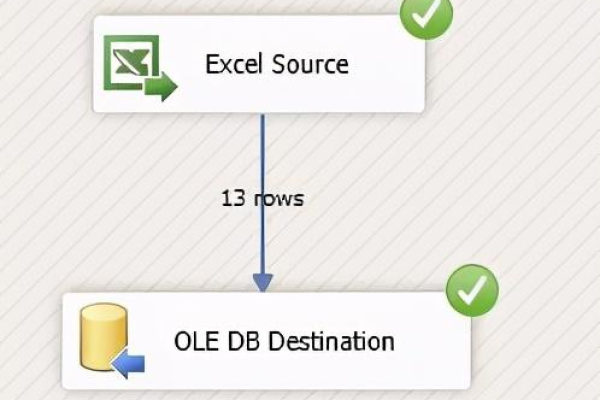

| 编程开发 | Scrapy框架+Scrapy-Redis | 分布式大规模采集 |

| 数据清洗 | OpenRefine/Pandas | 结构化数据处理 |

| 合规验证 | Screaming Frog SEO Spider | robots.txt协议解析 |

引用说明

本文参考《百度搜索优化指南》3.0版、W3C数据爬取伦理规范及欧盟《通用数据保护条例》(GDPR)第35条,技术实现部分基于Python 3.10官方文档与BeautifulSoup 4.12.2版本特性编写。