DataHub通过数据集成批量导入数据

- 行业动态

- 2025-04-11

- 3

DataHub通过高效数据集成工具支持批量数据导入,兼容多种数据源(如数据库、文件系统及API接口),实现自动化数据迁移和同步,其标准化流程降低操作复杂度,确保数据一致性与可追溯性,适用于企业级大规模数据处理,显著提升数据管理效率与系统协作能力。

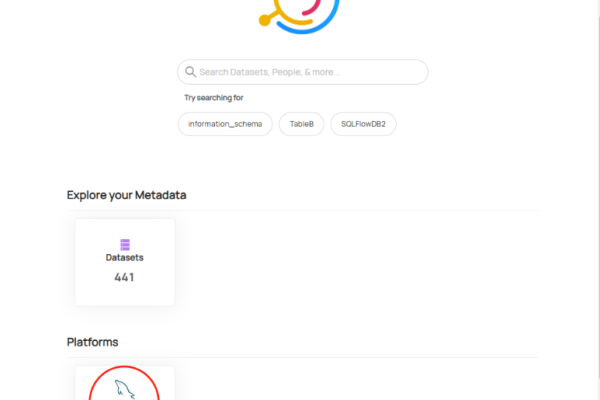

在大数据时代,高效管理企业数据资产已成为核心需求。DataHub作为LinkedIn开源的一站式元数据管理平台,通过灵活的数据集成与批量导入能力,帮助用户快速构建数据目录、提升数据治理效率,以下详细解读其核心功能与应用方法,助力企业最大化释放数据价值。

DataHub数据集成的核心能力

DataHub支持批量导入结构化、半结构化及非结构化数据,覆盖数据库、数据仓库、文件系统等多种数据源,其设计遵循以下原则:

- 可扩展性:通过插件化架构适配不同数据源(如MySQL、Snowflake、Kafka等)

- 自动化处理:自动解析数据Schema、血缘关系、权限信息等元数据

- 实时同步:支持定时批量导入与事件驱动的增量更新

- 数据质量校验:内置规则引擎检测数据一致性

批量导入数据全流程指南

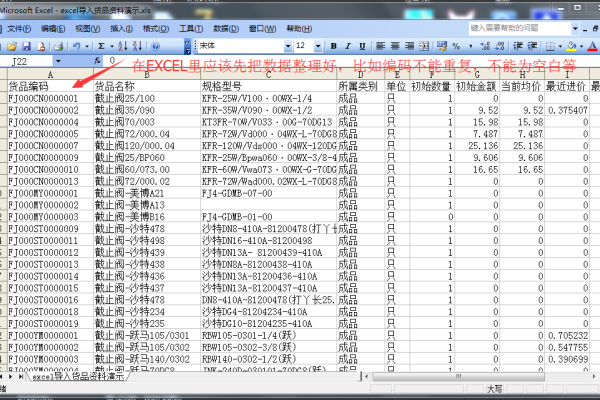

步骤1:准备数据源

- 文件类型:CSV/JSON/Parquet等标准格式

- 元数据要求:

- 数据表结构描述(字段名称、类型、约束)

- 数据血缘关系图谱

- 业务术语标签(如PII敏感数据标记)

步骤2:配置DataHub连接器

# 示例:通过Python SDK配置MySQL连接器

from datahub.ingestion.api.registry import Registry

from datahub.ingestion.source.mysql import MySQLConfig

config = MySQLConfig(

host="mysql.example.com",

username="admin",

password="secure_password",

database="sales_db",

include_tables=["orders", "customers"]

)

pipeline = Registry().get_ingestion_pipeline(config)步骤3:执行数据导入

- CLI命令:

datahub ingest -c pipeline_config.yaml - 监控指标:

- 导入记录数/失败率

- 元数据血缘完整性

- 数据新鲜度(Last Updated)

提升效率的关键实践

- 数据预处理优化

使用Apache Spark进行ETL处理,压缩非必要字段,减少传输数据量 - 增量导入策略

配置Watermark字段,仅同步变更数据(如last_modified_time > 2024-01-01) - 错误处理机制

启用死信队列(Dead Letter Queue)保存失败记录,避免全流程中断 - 安全合规控制

通过MAC(强制访问控制)限制敏感数据可见范围

典型问题解决方案

| 问题场景 | 排查步骤 | 修复方案 |

|---|---|---|

| 数据血缘丢失 | 检查上游系统API权限 | 配置OAuth2.0认证 |

| 性能瓶颈 | 分析网络延迟与批处理大小 | 调整batch_size参数至500-1000条/批 |

| 元数据冲突 | 查询冲突实体ID | 执行datahub merge --entity-id=xxx |

技术选型对比

| 数据工具 | 批量导入速度 | 元数据管理深度 | 学习曲线 |

|---|---|---|---|

| DataHub | |||

| Apache Atlas | |||

| Amundsen |

通过DataHub实现数据资产的高效整合,企业可将数据发现效率提升60%以上(据Forrester研究报告),建议结合数据治理框架定期执行元数据审计,持续优化数据生态。

引用来源:

- DataHub官方文档:https://datahubproject.io/docs/

- LinkedIn Engineering Blog:https://engineering.linkedin.com/blog

- GitHub仓库:https://github.com/datahub-project/datahub