服务器散热设计

- 行业动态

- 2025-04-11

- 2

服务器散热设计需综合运用风冷、液冷及相变冷却等技术,通过优化散热结构、气流组织与智能温控策略,平衡能效与稳定性,结合导热材料与动态调控系统,确保硬件在复杂工况下高效运行,降低能耗并延长设备寿命,满足数据中心高负载与长期可靠性需求。

服务器散热设计:技术解析与行业实践

在数字化时代,服务器作为支撑云计算、大数据和人工智能的核心设备,其稳定性直接影响用户体验和数据安全,而散热设计是保障服务器长期高效运行的关键环节,本文将深入探讨服务器散热的核心技术、设计原则及行业趋势,为技术决策者提供科学参考。

散热设计为何至关重要?

性能与寿命的平衡

服务器CPU、GPU等核心部件在高负载下会产生大量热量,若散热不足,可能导致芯片过热降频(Throttling),降低计算效率,甚至引发硬件永久性损坏,研究表明,温度每升高10°C,电子元件的寿命可能缩短50%(参考:ASHRAE Thermal Guidelines)。能耗成本控制

数据中心的电力消耗中,制冷系统占比高达40%,优化的散热设计可降低空调负载,直接减少运营成本,谷歌通过液冷技术将数据中心PUE(能源利用效率)降至1.1以下,远低于行业平均的1.6。环境适应性扩展

随着边缘计算兴起,服务器需部署在工厂、户外等复杂环境中,散热系统需适应高温、粉尘等挑战,华为的“智能温控算法”可根据环境动态调整风扇转速,提升散热效率30%。

主流散热技术对比

风冷散热:成熟方案的经济之选

- 原理:通过风扇强制空气流动,带走热量。

- 优势:成本低、维护简单,适用于中小型数据中心。

- 局限:散热效率受限于空气比热容,高密度服务器场景下效果有限。

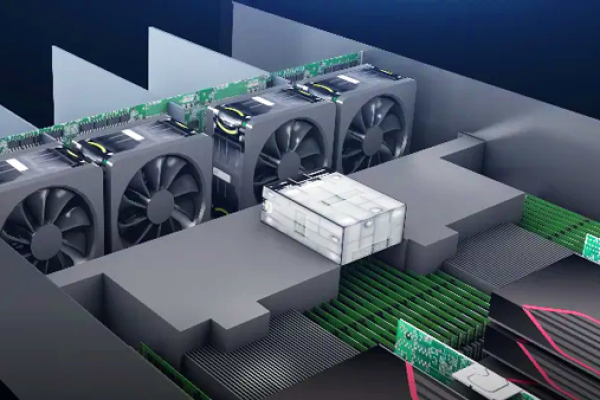

液冷散热:高密度计算的未来趋势

- 冷板式液冷(Cold Plate)

液体流经贴合CPU的金属板吸热,适合局部高热源场景,如AI训练服务器。 - 浸没式液冷(Immersion Cooling)

将服务器完全浸没在绝缘冷却液中(如3M Novec),散热效率比风冷高1000倍,但初期投资较高。 - 行业案例:Facebook的Open Compute项目已大规模部署浸没式液冷,单机柜功率密度提升至50kW以上。

- 冷板式液冷(Cold Plate)

相变冷却与热管技术

- 利用介质(如氟化液)在气液相变时吸收大量热量的特性,实现高效传热。

- 应用场景:航空航天、超算中心(如日本“富岳”超算采用热管+液冷混合方案)。

散热设计的四大核心原则

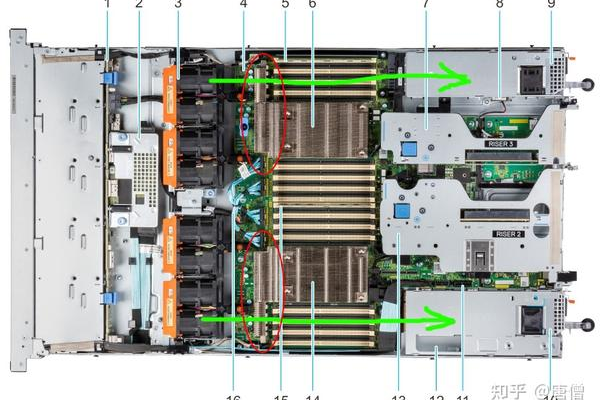

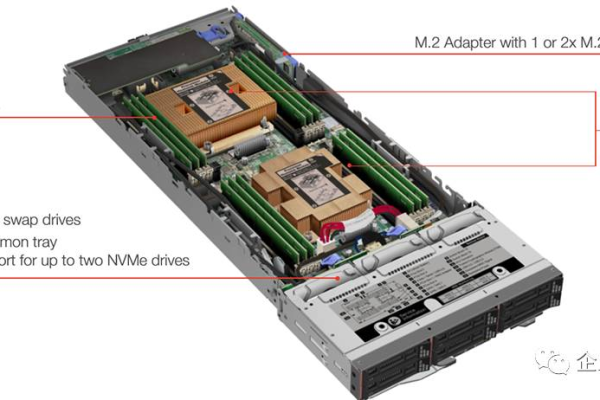

热源精准定位

- 通过红外热成像或CFD(计算流体力学)模拟,识别服务器内部“热点”(如PCIe插槽、内存条)。

- 英特尔推荐在CPU和GPU周围预留“热缓冲区”,避免热量堆积。

气流路径优化

- 水平风道:适用于标准机柜,要求前后门开孔率≥60%以保证通风。

- 垂直风道(烟囱效应):通过热空气自然上升提升散热效率,常用于模块化数据中心。

材料与结构创新

- 高导热材料:石墨烯导热片(导热系数5300 W/m·K)比传统硅脂提升5倍。

- 模块化设计:戴尔PowerEdge系列采用可拆卸风扇组,支持按需扩展散热能力。

智能调控系统

- 基于AI的预测性温控:IBM的“Cooling Advisor”通过机器学习预测负载变化,提前调整散热策略。

- 动态功耗封顶(Power Capping):限制部件最大功耗,防止突发高热。

行业挑战与创新方向

散热与噪音的平衡

欧盟ErP指令要求服务器噪音低于75分贝,厂商采用无刷直流风扇和减震支架降低噪音。

绿色冷却技术

- 自然冷源利用:微软在海底数据中心“Natick”中利用海水直接冷却,PUE低至1.07。

- 余热回收:瑞典的EcoDataCenter将服务器废热用于区域供暖,能源综合利用率达90%。

芯片级散热革命

台积电的“微通道冷却”技术将散热结构集成至芯片内部,使3D堆叠芯片的散热效率提升3倍。

选择散热方案的关键指标

- TDP(热设计功耗):根据CPU/GPU标称TDP选择对应散热能力。

- CFM(风量)与风压:确保气流能够穿透密集元器件。

- MTBF(平均无故障时间):优质风扇的MTBF需超过10万小时。

- 兼容性与扩展性:支持未来硬件升级,如PCIe 5.0设备的高热需求。

引用说明

- 散热效率数据参考《ASHRAE数据中心环境指南》

- 液冷案例引自Facebook Open Compute Project白皮书

- 材料性能参数来源于《Advanced Materials》期刊2022年研究报告

- 法规依据:欧盟ErP指令(EC No. 617/2013)