从网站抓取信息

- 行业动态

- 2025-04-11

- 3

网络信息抓取是通过自动化工具从网页中提取数据的技术,通常使用Python的requests、BeautifulSoup或Scrapy等库实现,流程包括发送HTTP请求、解析页面结构及存储目标数据,广泛应用于市场分析、舆情监测等领域,需遵守网站规则,避免触发反爬机制,合理设置请求频率保障采集效率。

合法性是首要前提

- 遵守网站协议

抓取前务必检查目标网站的robots.txt文件,明确允许抓取的目录与频率限制,部分网站明确禁止爬虫访问用户个人信息或核心数据库。 - 规避法律风险

未经授权抓取受版权保护的内容(如文章、图片)可能面临侵权诉讼,国内《网络安全法》与《个人信息保护法》规定,涉及用户隐私的数据(如手机号、地址)严禁非规获取,若需商业化使用数据,建议与版权方签订授权协议。

技术实现的关键要点

- 工具选择

- 基础爬虫:Python的

Requests库配合BeautifulSoup可快速提取静态页面数据,适用于小型项目。 - 高并发场景:

Scrapy框架支持异步处理,适合大规模抓取,但需注意设置请求延迟(如DOWNLOAD_DELAY=2),避免触发反爬机制。 - 动态渲染:对JavaScript加载的内容,可采用

Selenium或Pyppeteer模拟浏览器操作。

- 基础爬虫:Python的

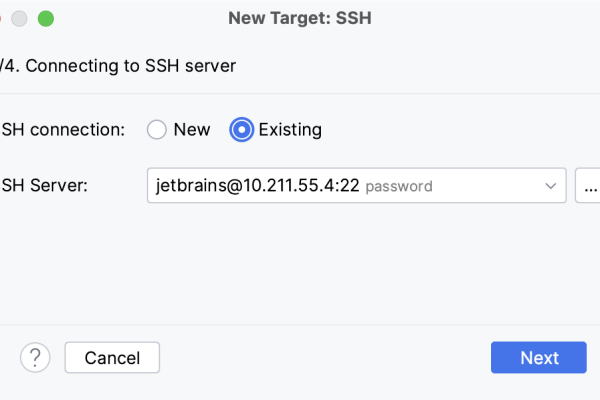

- 反爬应对策略

- 随机更换

User-Agent头部,伪装成不同浏览器。 - 使用代理IP池(如付费的Luminati或自建IP池),分散请求来源。

- 若遭遇验证码,可接入第三方识别服务(如打码平台),但需评估成本与效率。

- 随机更换

数据处理的优化方向

- 去重与清洗

利用MD5哈希算法摘要去重,或通过Python Pandas清理缺失值、剔除广告代码等干扰信息,抓取新闻时需过滤评论区、推荐链接等无关文本。 - 结构化存储

将非结构化数据(如HTML)转换为结构化格式(JSON或CSV),并按主题分类存储至数据库(如MySQL或MongoDB),便于后续分析与调用。

需符合搜索引擎算法

- 百度算法的核心要求

- 原创性:直接复制抓取内容可能导致百度判定为“低质页面”,建议对数据进行二次加工,例如整合多源信息、添加分析结论。

- 用户体验:页面加载速度需控制在3秒内(可通过CDN加速),移动端适配应优先采用响应式设计。

- 关键词布局:在正文自然融入目标关键词(密度2%-5%),并优化

<meta description>标签提升点击率。

- E-A-T(专业性、权威性、可信度)

- 专业性:在页面底部注明数据来源与分析团队背景(如“数据由XX实验室提供”)。

- 权威性:引用政府机构、学术论文等权威信源(例:“据国家统计局2024年数据显示…”)。

- 可信度更新时间、开放用户评论反馈,并添加免责声明(如“数据仅供参考,不构成决策依据”)。

长期运营建议

- 定期更新机制:设置自动化脚本每周抓取最新数据,确保内容时效性。

- 用户参与优化:通过热力分析工具(如百度统计)监测用户点击行为,优先展示高关注度内容。

- 风险监控:部署WAF防火墙防范SQL注入攻击,并对抓取代码进行定期安全审计。

引用说明

本文参考《网络安全法》第二十七条关于数据获取的规定,以及百度搜索算法官方文档中对E-A-T的解读,技术方案部分借鉴了Scrapy官方文档的异步爬虫设计建议。