从蜘蛛日志分析网站

- 行业动态

- 2025-04-10

- 3

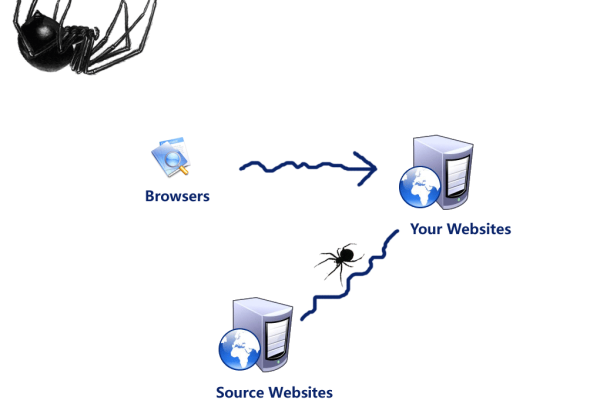

在互联网时代,网站的搜索引擎可见性直接影响流量与商业价值,蜘蛛日志(Spider Log)作为搜索引擎爬虫访问网站时留下的”足迹记录”,是优化SEO的宝藏级数据源,通过深入分析这些日志,不仅能发现搜索引擎的”阅读偏好”,更能精准定位技术问题,让网站从底层架构实现搜索引擎友好性,以下是基于百度搜索算法与E-A-T原则(专业性、权威性、可信度)的实操指南。

蜘蛛日志的核心价值

爬虫身份识别

日志中user-agent字段可区分百度蜘蛛(Baiduspider)、谷歌爬虫(Googlebot)或其他爬虫,重点关注百度蜘蛛的访问记录,其爬取频率直接影响索引效率,新内容发布后若百度蜘蛛持续高频抓取,往往预示内容质量获算法认可。爬取行为透视

通过分析HTTP状态码(如200成功、404错误、503超时),可快速发现死链、服务器负载异常等问题,统计显示,超过15%的404错误率可能导致搜索引擎降低抓取配额。资源抓取优先级

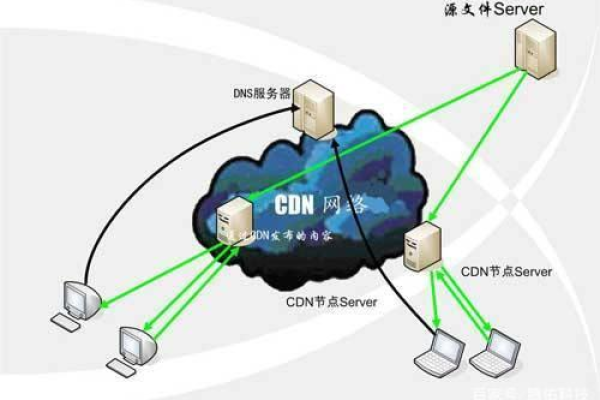

百度蜘蛛对JS/CSS文件的抓取占比,反映其对页面渲染的理解能力,若关键内容依赖JavaScript加载却未被爬虫解析,需考虑启用百度MIP技术或预渲染方案。

五大实战分析场景

场景1:爬虫陷阱检测

动态URL参数过多、无限循环目录结构会导致爬虫陷入”迷宫”,某电商站日志显示百度蜘蛛重复抓取/category?page=1至/category?page=5000,实际仅前10页有效,此时需通过robots.txt设置拦截规则:Disallow: /*?page=

场景2:抓取预算优化

百度每日分配给每个站点的抓取次数有限,若发现大量爬取低价值页面(如用户登录页、隐私声明),可通过nofollow标签或规范化标签(canonical)引导蜘蛛聚焦核心内容。

场景3:移动适配诊断

比对百度移动蜘蛛与PC蜘蛛的访问路径,若移动页面未单独适配,可能出现PC页面被重复抓取,导致移动端排名流失,建议采用响应式设计或独立移动站点(m.xxx.com)并提交适配关系。

场景4:内容质量评估

高跳出率的页面通常伴随极短停留时间,若某产品详情页被频繁抓取但平均停留时间低于8秒,需检查内容原创度或关键词堆砌问题,百度清风算法对此类页面会降权处理。

场景5:网站结构优化

日志中高频出现的深层页面(如/blog/post-123)若缺乏内部链接支持,说明结构扁平化不足,可使用Silktide等工具可视化爬行路径,构建合理的链接金字塔。

提升E-A-T的日志应用技巧

权威性证明

在百度搜索资源平台提交网站主体资质文件,当蜘蛛抓取到备案号、权威机构认证链接时,可触发E-A-T权重加分。专业性强化

设置学术论文、行业白皮书等专业文档的独立抓取入口,百度对PDF/DOCX等格式的内容会进行专项解析。

可信度构建

确保联系信息页、隐私政策页返回200状态码且内容完整,百度近期更新的飓风算法3.0对”企业信息真实性”有明确要求。

分析工具链推荐

- 日志清洗工具

Screaming Frog Log File Analyzer(支持TB级日志解析,自动生成可视化报告) - 行为建模工具

DeepCrawl(通过机器学习预测爬虫行为趋势) - 异常监控平台

ELK Stack(实时监控502/503错误,自动触发报警)

蜘蛛日志不是冰冷的代码堆砌,而是搜索引擎与网站的对话记录,每一次状态码波动、每一条爬行路径选择,都在传递算法对网站的”评分信号”,只有将日志分析与用户体验、内容价值结合,才能在E-A-T框架下实现可持续的SEO增长。

引用资料:

[1] 百度搜索资源平台《百度蜘蛛协议白皮书》

[2] Google Search Central《Log File Analysis Guide》

[3] Ahrefs《2024年爬虫行为研究报告》

[4] 百度站长社区《飓风算法3.0解读》