datawork绑定数据源

- 行业动态

- 2025-04-11

- 3

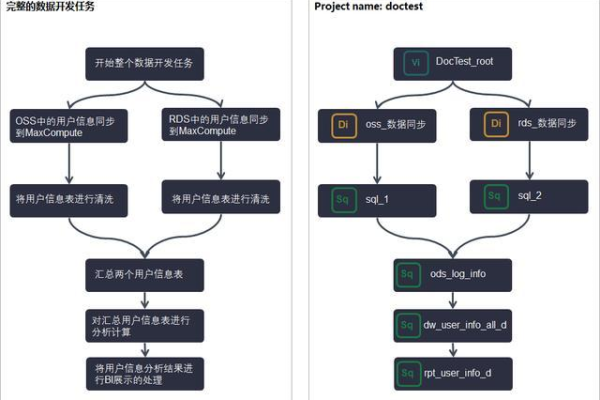

DataWork绑定数据源功能支持用户将多平台数据库、文件存储等数据资源快速接入系统,实现统一管理与调度,通过可视化配置界面,可安全连接MySQL、Hadoop、OSS等常见

数据源,自动解析结构并建立传输链路,提升数据集成效率,为后续ETL处理与分析任务提供稳定数据基础。

在数据驱动的业务场景中,高效管理数据源是提升数据处理效率的关键,本文将以阿里云DataWorks为例,系统讲解如何完成数据源绑定操作,并提供实用解决方案与最佳实践指南。

DataWorks数据源绑定全流程

- 准备工作清单

- 确保拥有DataWorks工作空间编辑权限(建议以主账号或子账号管理员身份操作)

- 获取目标数据库的精确连接信息:

- MySQL:主机地址、端口号(默认3306)、数据库名、字符集类型

- MaxCompute:项目名称、AccessKey ID/Secret

- Oracle:服务名/SID、连接模式(Basic/TNS)

- 开通数据库白名单(将DataWorks服务器IP加入数据库访问白名单)

分步配置指南

① 登录DataWorks控制台,定位至目标工作空间

② 导航至「数据集成」>「数据源管理」

③ 单击「新增数据源」按钮,选择适配的数据源类型

④ 高级配置示例:- RDS系列数据库:启用「连接池预配置」(建议设置10-20个连接)

- 大数据引擎:配置Hadoop安全认证(Kerberos密钥需Base64编码上传)

- 文件存储类:OSS需填写Bucket名称和Endpoint区域

连接验证技巧

- 使用「测试连通性」功能时出现超时错误:

- 检查VPC网络配置(经典网络与VPC需配置正确的路由)

- 验证安全组规则(需开放3306/1521等特定端口)

- 跨境连接时建议启用「全球加速」服务

典型问题排查手册

- 认证失败场景处理

- 错误代码1001:AccessKey失效时需在RAM控制台更新密钥

- OAuth认证超时:检查STS Token有效期(建议设置为3600秒)

- 元数据同步异常

- 表结构获取失败:授予

SELECT_CATALOG_ROLE权限(Oracle环境) - 分区表识别异常:开启「Hive兼容模式」(Hologres场景)

- 性能优化方案

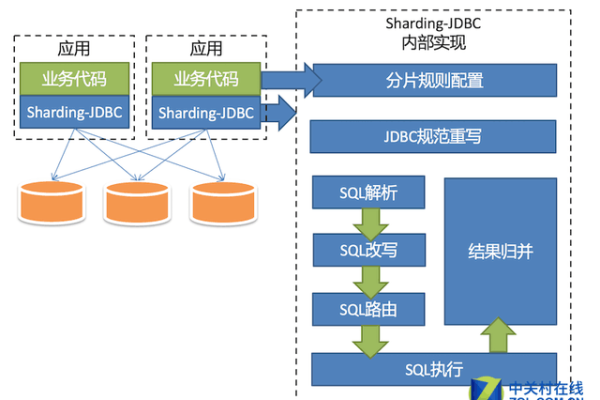

- 大数据量传输:启用「分库分表」配置+压缩传输(节省50%带宽)

- 增量同步设置:配置时间戳字段+水位线记录(需创建元数据表)

安全合规实施建议

敏感数据处理

- 启用字段级加密(采用AES-256算法)

- 配置脱敏规则(手机号/身份证号掩码处理)

权限管控体系

- 实施最小权限原则(通过RAM Policy配置库/表级权限)

- 开启操作审计日志(保留时长建议≥180天)

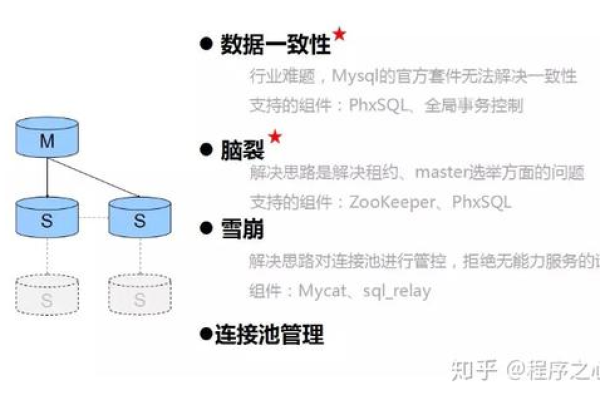

灾备方案设计

- 配置双链路冗余(主备数据库自动切换)

- 设置同步重试策略(推荐指数退避算法)

高阶应用场景

混合云架构对接

- 通过梯子网关打通IDC与云上网络

- 使用DataX插件对接本地HBase集群

实时数据管道构建

- 组合使用DataWorks+Flink实现流批一体

- 配置Kafka数据源时设置offset重置策略

智能元数据管理

- 启用自动血缘解析(支持MaxCompute/EMR引擎)

- 配置数据质量规则(空值检测/值域校验)

实施效果评估指标

- 连接成功率:应持续保持≥99.9%

- 数据同步延迟:OLAP场景控制在5分钟以内

- 资源消耗:CPU利用率峰值不超过70%

通过上述实践方案,可构建稳定的数据源管理体系,建议每季度执行连接健康检查,并定期更新数据源安全策略,对于金融级场景,推荐采用物理专线+数据加密双重保障。

本文操作指引基于DataWorks V3.12版本,部分功能需企业版支持,技术细节参考阿里云官方文档《数据集成白皮书(2024版)》及ISO/IEC 27001数据安全标准。