backprops深度学习

- 行业动态

- 2025-04-11

- 4

反向传播算法(Backpropagation) 是深度学习模型训练的核心技术之一,它的本质是通过计算损失函数(Loss Function)的梯度,逐层调整神经网络中的权重参数,从而最小化预测误差,这一过程类似于“从错误中学习”,是模型能够不断优化的关键。

反向传播如何工作?

前向传播(Forward Pass)

输入数据通过神经网络各层逐层传递,最终得到预测结果,一张猫的图片经过卷积层、激活函数、池化层处理后,输出“猫”的概率为0.8,“狗”为0.2。计算损失(Loss Calculation)

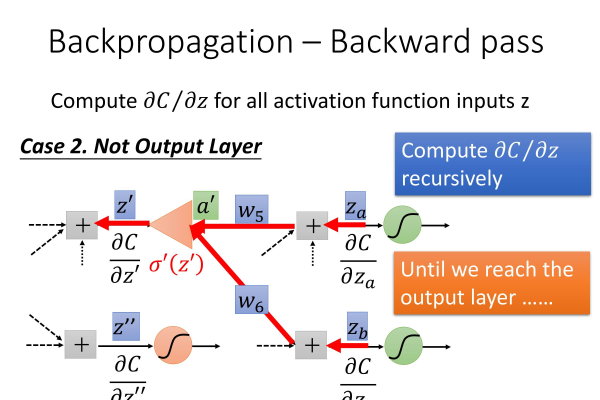

比较预测结果与真实标签的差异,假设真实标签是“猫”,则损失函数(如交叉熵)会计算出当前预测的误差值。反向传播梯度(Backward Pass)

从输出层开始,反向逐层计算每个参数对损失的贡献(梯度),利用链式法则(Chain Rule)将误差梯度分摊到每一层,最后一层的权重梯度较大,说明它对错误的影响更直接。参数更新(Update Parameters)

使用优化器(如SGD、Adam)根据梯度调整权重,若某个权重导致损失增加,优化器会减少它的数值。

为什么反向传播如此重要?

高效性

反向传播通过链式法则高效计算梯度,避免了重复计算,传统方法计算每个参数的梯度需要独立遍历所有路径,时间复杂度为O(N²),而反向传播仅需O(N)。适用于复杂网络

现代深度学习模型可能包含数百万参数(如ResNet、Transformer),反向传播使大规模参数优化成为可能。泛化能力

梯度信息帮助模型区分“重要特征”与“噪声”,在图像识别中,反向传播会强化边缘检测器的权重,弱化无关纹理的影响。

反向传播的挑战与解决方案

梯度消失/爆炸

- 问题:深层网络中,梯度经过多层传递后可能趋近于零(消失)或无限大(爆炸),导致训练停滞或数值不稳定。

- 解决:使用ReLU激活函数、批量归一化(BatchNorm)、残差连接(ResNet)或梯度裁剪(Gradient Clipping)。

局部最优与鞍点

- 问题:高维参数空间中,模型可能陷入局部最优或鞍点,无法找到全局最优解。

- 解决:动量优化(Momentum)、自适应学习率(Adam)或引入随机性(如Dropout)。

计算资源限制

- 问题:反向传播需要存储中间计算结果(计算图),显存占用随网络深度增加。

- 解决:使用检查点技术(Checkpointing)或分布式训练。

实际应用场景

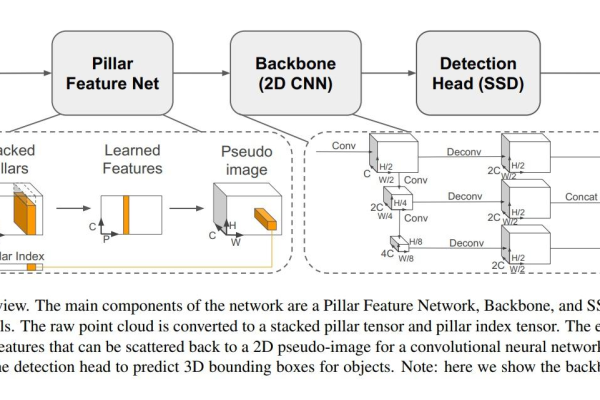

图像识别

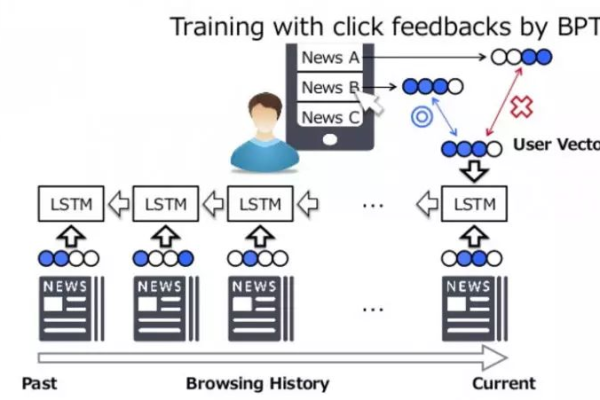

在卷积神经网络(CNN)中,反向传播优化滤波器权重,使模型学会提取边缘、纹理等特征,医学影像分析中,模型通过反向传播调整参数,准确区分肿瘤与正常组织。自然语言处理(NLP)

循环神经网络(RNN)和Transformer依赖反向传播学习词向量与注意力权重,机器翻译模型通过反向传播调整参数,使“猫”在英文和法文中的嵌入向量对齐。强化学习

策略梯度方法(如PPO)利用反向传播更新智能体的决策策略,AlphaGo通过反向传播优化落子概率,提升胜率。

代码示例

import torch

# 定义简单网络

model = torch.nn.Sequential(

torch.nn.Linear(784, 128),

torch.nn.ReLU(),

torch.nn.Linear(128, 10)

)

# 前向传播

inputs = torch.randn(32, 784) # 输入32张图像

outputs = model(inputs)

labels = torch.randint(0, 10, (32,)) # 生成随机标签

# 计算损失

loss_fn = torch.nn.CrossEntropyLoss()

loss = loss_fn(outputs, labels)

# 反向传播

loss.backward() # 自动计算梯度

# 更新参数

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

optimizer.step()

权威引用

- 反向传播的数学推导最早由Rumelhart等人于1986年提出(论文链接)。

- 深度学习经典教材《Deep Learning》(Ian Goodfellow等)第6章详细解释了反向传播与计算图。

- PyTorch官方文档提供了反向传播的实现教程(链接)。