如何实现从PolarDB MySQL到Datahub的数据同步?

- 行业动态

- 2024-12-05

- 2551

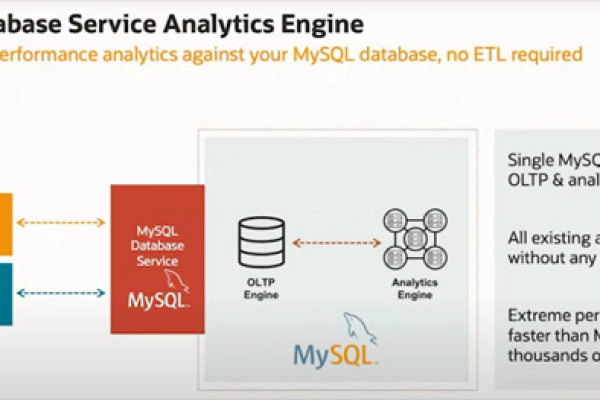

PolarDB MySQL数据同步至Datahub,可通过配置Flink CDC连接器实现。确保 PolarDB MySQL已开启Binlog,然后在Flink作业中设置CDC Source连接PolarDB,并指定目标 Datahub的Sink,实现实时 数据同步。

从PolarDB MySQL同步至DataHub是一个复杂但有序的过程,旨在实现数据的实时同步和分析,以下是对这一过程的详细解析:

一、前提条件

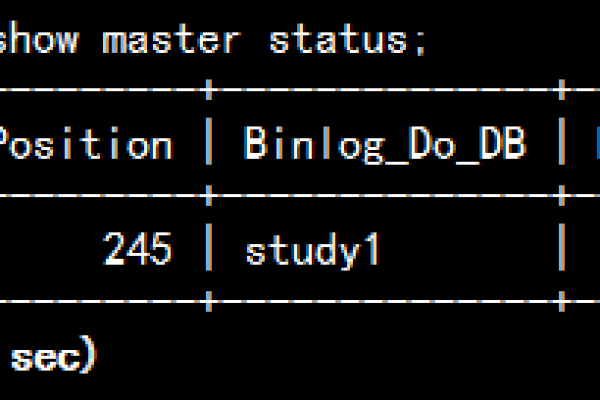

1、创建源存储空间:需要创建一个PolarDB MySQL版的集群,并确保该集群已经开启Binlog,Binlog是记录数据库所有变更的日志,对于数据同步至关重要。

2、目标存储空间配置:在DataHub中创建一个项目(Project),该项目将用作接收同步数据的目的地。

3、网络与安全组配置:确保PolarDB MySQL集群和DataHub实例之间的网络连通性,并可能需要在安全组中开放相应的端口。

二、数据同步策略

1、全量同步:初次同步时,DTS会将源存储空间的全量数据同步到不同区域的目标存储空间。

2、增量同步:在全量同步的基础上,DTS会继续将源存储空间的增量更新数据同步到目标库中,这要求源数据库的本地Binlog日志保存一定时间(如24小时以上),以确保DTS能够获取到足够的变更信息。

三、操作步骤

1、购买数据同步作业:登录阿里云控制台,选择数据传输服务DTS,并购买一个数据同步作业。

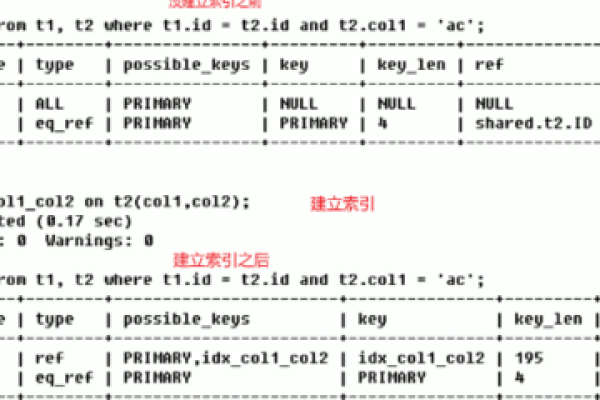

2、配置同步链路:在DTS控制台中,配置数据同步的源实例(PolarDB MySQL)和目标实例(DataHub),并设置同步拓扑为单向同步。

3、选择同步对象:在源库对象框中选择待同步的对象(如表),并将其移动到已选择对象框中,注意,DTS支持表级别的数据同步,但不支持库级别的数据同步。

4、启动同步任务:完成配置后,启动数据同步任务,DTS会在预检查通过后开始执行同步作业。

四、注意事项

1、数据一致性:在数据同步过程中,应避免对源库进行结构变更或大规模的数据操作,以免影响数据一致性。

2、性能考虑:数据同步可能会占用一定的系统资源,建议在业务低峰期进行同步操作。

3、费用问题:DTS的数据同步服务可能涉及链路配置费用和公网流量费用,具体费用请参考阿里云的计费。

五、常见问题

Q1: PolarDB MySQL同步至DataHub是否支持全量数据初始化?

A1: 不支持,DTS不会将源PolarDB集群中同步对象的存量数据同步至目标DataHub实例。

Q2: 数据同步过程中能否对源库进行DDL变更?

A2: 不建议,在数据同步过程中,请勿对源库中待同步的表执行DDL变更,否则会导致同步失败,如果必须进行DDL变更,请先暂停同步任务,并在变更完成后恢复。

六、小编有话说

从PolarDB MySQL同步至DataHub是一个涉及多个步骤和配置的过程,需要仔细规划和执行,在实际操作中,建议根据具体的业务需求和数据量来选择合适的同步策略,并在同步前进行充分的测试,以确保数据的准确性和一致性,也要注意监控同步过程中的性能指标,及时调整配置以优化同步效率。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/361686.html