bp神经网络拟合的不好

- 行业动态

- 2025-04-11

- 3

BP神经网络拟合效果不佳通常源于网络结构设计不合理、学习率设置不当或训练数据不足,可能表现为欠拟合或过拟合,需调整隐藏层节点数、激活函数,优化初始化参数,并增加正则化处理,改进数据质量、动态调整学习率及采用交叉验证可提升模型泛化能力。

在应用BP神经网络时,若模型拟合效果不佳,可能是由多种因素导致的结果,本文将从数据质量、模型结构、训练策略以及优化技术四个关键维度展开分析,并提供针对性的解决方案,帮助用户快速定位问题并优化模型。

数据质量:模型训练的根基

数据量不足或分布不均

BP神经网络需要足够的数据量学习特征规律,若样本过少(尤其是复杂任务),模型容易陷入“死记硬背”而无法泛化。- 解决方案:增加数据量,或通过数据增强(如旋转、裁剪、添加噪声)扩充样本;对于类别不均衡问题,可采用重采样(如SMOTE算法)或调整损失函数权重。

噪声干扰严重或特征冗余

数据中的异常值或无关特征会干扰模型学习方向。- 解决方案:使用数据清洗(如Z-score标准化检测离群值)结合特征选择(如PCA降维、互信息法筛选关键特征)优化输入。

未进行归一化/标准化

输入数据量纲差异过大会导致梯度更新不稳定,影响收敛速度。

- 解决方案:对输入数据统一进行Min-Max归一化或Z-score标准化,确保各维度数值范围一致。

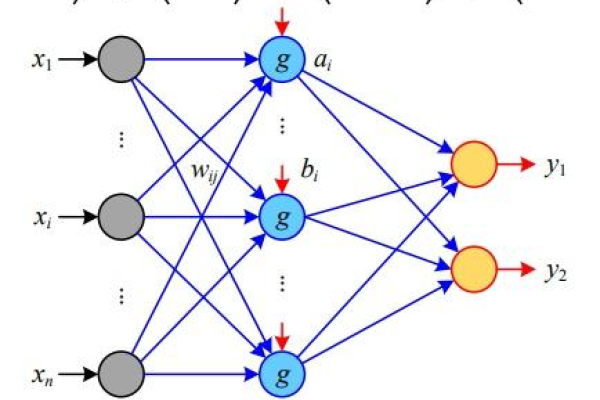

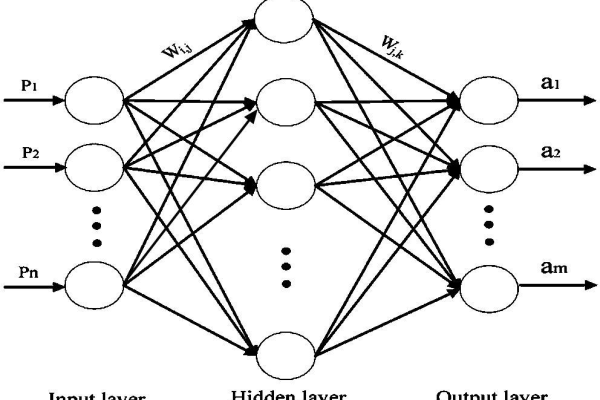

模型结构:平衡复杂性与效率

隐藏层设计不合理

层数过多可能导致过拟合,层数过少则无法捕捉复杂模式。- 解决方案:通过网格搜索或贝叶斯优化调整隐藏层数和神经元数量;优先尝试“由简到繁”的构建策略,逐步增加复杂度。

激活函数选择不当

使用Sigmoid等饱和函数易引发梯度消失问题。- 解决方案:隐藏层推荐使用ReLU、Leaky ReLU等非饱和激活函数;输出层根据任务类型选择(如分类用Softmax,回归用Linear)。

训练策略:优化学习过程

学习率设置不合理

过高的学习率会导致震荡不收敛,过低则训练缓慢。

- 解决方案:采用自适应学习率算法(如Adam、RMSProp),或配合学习率衰减策略(如指数衰减、余弦退火)。

迭代次数不足或过早停止

训练轮次(Epoch)过少时模型未充分学习,过多则可能过拟合。- 解决方案:监控验证集损失曲线,使用早停法(Early Stopping)在损失稳定时终止训练。

未正确划分数据集

若训练集与测试集分布不一致,评估结果将失真。- 解决方案:严格按比例划分训练集、验证集和测试集(如6:2:2),避免数据泄露。

优化技术:提升泛化能力

过拟合问题

模型在训练集表现好但测试集差,通常由参数过多或噪声干扰导致。- 解决方案:

- 引入L1/L2正则化约束权重;

- 使用Dropout随机屏蔽部分神经元;

- 采用数据增强增加多样性。

- 解决方案:

欠拟合问题

模型无法捕捉数据基本规律,表现为训练集和测试集效果均差。

- 解决方案:

- 增加网络深度或神经元数量;

- 改进特征工程(如构造交叉特征);

- 减少正则化强度。

- 解决方案:

梯度消失/爆炸

深层网络中梯度传递异常,导致参数无法有效更新。- 解决方案:

- 使用Batch Normalization规范化层输出;

- 采用残差连接(ResNet结构)优化梯度流动;

- 初始化权重时选择Xavier或He方法。

- 解决方案:

实用调试步骤

- 基线测试:先用简单模型(如线性回归)验证数据是否可学习。

- 可视化分析:绘制损失曲线、混淆矩阵、特征重要性图。

- 消融实验:逐步调整超参数(如学习率、批大小),观察效果变化。

引用说明

- 周志华. 《机器学习》. 清华大学出版社, 2016.

- Ian Goodfellow等. 《深度学习》. 人民邮电出版社, 2017.

- Keras官方文档: https://keras.io/

通过系统性排查与优化,BP神经网络的拟合能力可显著提升,建议优先从数据质量入手,逐步调整模型结构与训练策略,最终结合高级优化技术实现理想的预测效果。