django生成数据库

- 行业动态

- 2025-02-07

- 11

models.Model,添加字段并指定数据类型和约束。然后运行

python manage.py makemigrations创建迁移文件,再执行

python manage.py migrate应用迁移来生成数据库表。

在Django中生成数据库是一个涉及多个步骤的过程,旨在通过配置和模型定义来创建和管理数据库结构,以下是详细步骤:

1、项目初始化与应用创建

首先需要创建一个新的Django项目和应用,使用命令django-admin startproject myproject创建项目,然后进入项目目录,使用python manage.py startapp myapp创建应用。

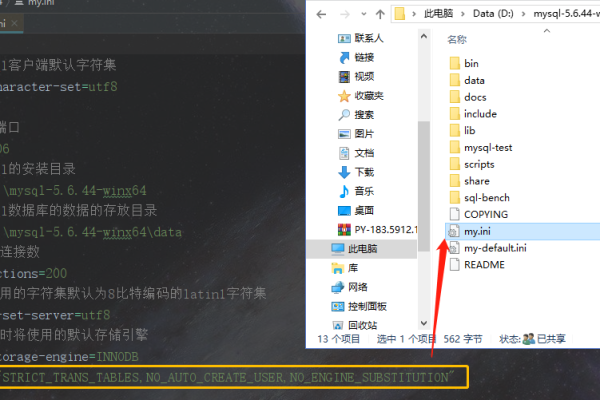

2、配置数据库连接

打开项目的settings.py文件,配置数据库连接参数,默认情况下,Django使用SQLite数据库,但可以根据需要配置其他数据库,如MySQL、PostgreSQL等。

配置MySQL数据库时,需要安装mysqlclient包,然后在settings.py中进行如下配置:

DATABASES = {

'default': {

'ENGINE': 'django.db.backends.mysql',

'NAME': 'mydatabase',

'USER': 'mydatabaseuser',

'PASSWORD': 'mypassword',

'HOST': 'localhost',

'PORT': '3306',

}

}

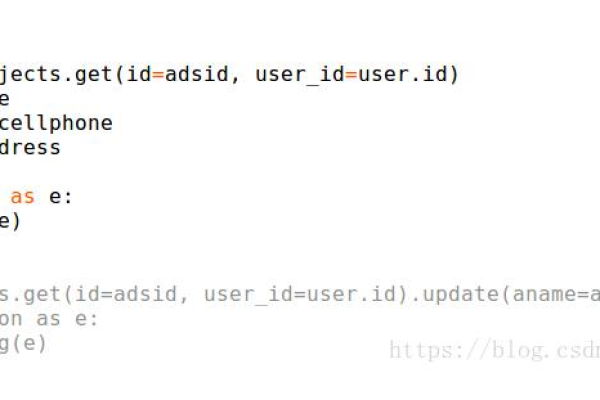

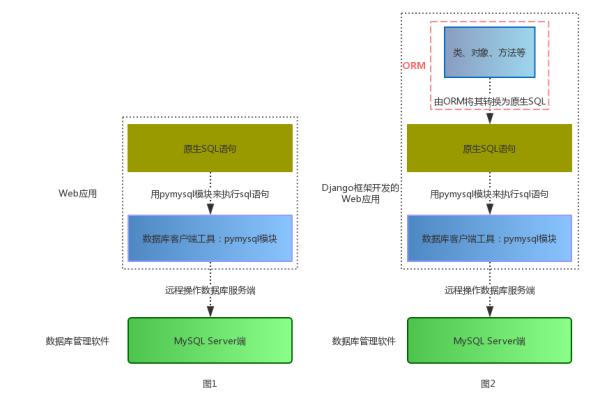

3、定义数据模型

在应用的models.py文件中定义数据模型,模型类是Django的ORM(对象关系映射)系统的核心,通过它可以用Python类的方式定义数据库表,而不需要直接编写SQL语句。

定义一个简单的博客文章模型:

from django.db import models

class BlogPost(models.Model):

title = models.CharField(max_length=100)

content = models.TextField()

created_at = models.DateTimeField(auto_now_add=True)

updated_at = models.DateTimeField(auto_now=True)

def __str__(self):

return self.title

4、生成迁移文件

定义好模型类后,需要生成迁移文件,迁移文件是Django用来记录数据库表结构变化的文件。

运行以下命令生成迁移文件:

python manage.py makemigrations

这个命令会在应用的migrations目录下生成一个新的迁移文件,该文件包含了创建表的SQL语句。

5、应用迁移文件

生成迁移文件后,需要运行迁移命令,将迁移文件中的操作应用到数据库。

运行以下命令:

python manage.py migrate

这个命令会创建BlogPost表以及其他必要的表(如Django的内置用户表等)。

6、验证数据库表是否创建成功

可以通过Django的管理后台或Django Shell来验证表是否成功创建。

启动Django Shell:

python manage.py shell

在shell中可以尝试创建和查询BlogPost对象:

from myapp.models import BlogPost

# 创建一个新的博客文章

post = BlogPost.objects.create(title="My First Blog Post", content="This is the content of my first blog post.")

# 查询所有博客文章

posts = BlogPost.objects.all()

print(posts)

如果上述代码执行没有报错,说明BlogPost表已经成功创建,并且可以正常进行CRUD(创建、读取、更新、删除)操作。

7、管理数据库

Django提供了多种工具和命令来管理数据库和数据模型。

Django Admin:Django自带一个强大的管理后台,可以通过以下命令创建超级用户,并登录管理后台进行数据库管理:

python manage.py createsuperuser

然后在浏览器中访问http://localhost:8000/admin/,使用超级用户账号登录。

Django Shell:Django提供了一个交互式的shell,你可以通过它直接操作数据库:

python manage.py shell

在shell中你可以进行数据库查询、数据插入等操作。

Django生成数据库的过程包括项目初始化、配置数据库连接、定义数据模型、生成迁移文件、应用迁移文件以及验证和管理数据库等多个步骤,这些步骤相对简单,但每一步都至关重要,正确的数据库配置和数据模型设计是项目成功的基础。