如何进行有效的负载均衡配置测试?

- 行业动态

- 2024-12-03

- 3497

负载均衡配置测试

背景介绍

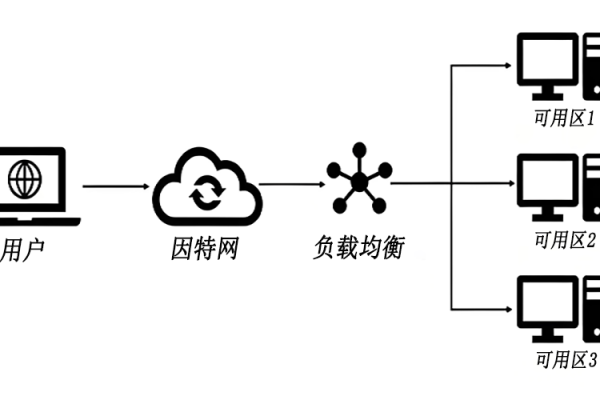

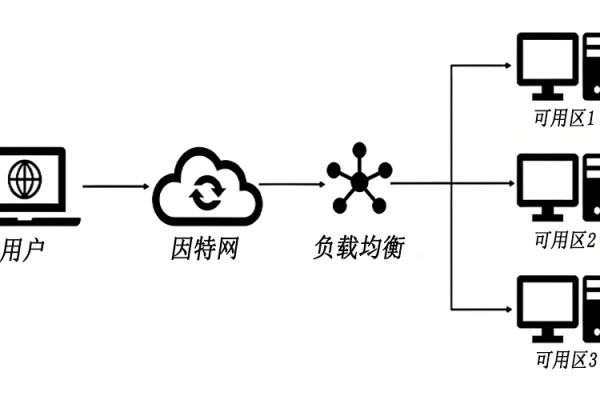

在现代分布式系统中,负载均衡是确保高可用性、扩展性和性能优化的关键技术,负载均衡通过将传入的请求分配到多台服务器上,防止单个服务器过载,从而提升整体系统的响应速度和可靠性,本文将详细探讨负载均衡的配置与测试,重点分析其核心概念、常见算法、高可用策略及实际测试方法。

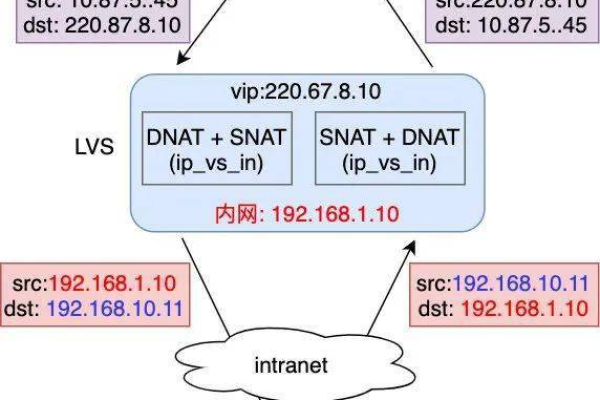

负载均衡的核心概念

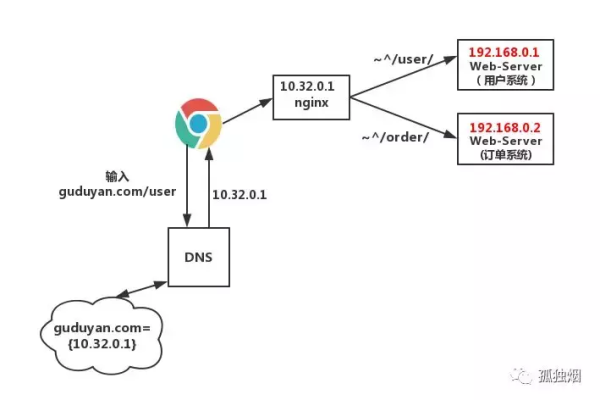

负载均衡是一种将工作负载(例如网络流量、数据请求、计算任务等)分配到多个计算资源上的技术,目的是优化性能、提高可靠性和增加可扩展性,负载均衡器通常位于应用程序前端,接受并分配传入的请求,通过使用算法来确定分配请求的最佳方式,负载均衡器可以防止任何一个资源过载或失效而导致应用程序的性能下降或停止响应。

负载均衡算法

轮询:每个请求按时间顺序逐一分配到不同的后端服务,适用于后端服务器性能一致的场景。

权重轮询:根据后端服务器的性能或负载情况,为每台服务器分配不同的权重,权重越高的服务器接收到的请求越多,适用于后端服务器性能差异较大的场景。

最少连接:将请求分配给当前连接数最少的服务器,以平衡服务器的负载,适用于长连接应用场景。

IP散列:根据请求的IP地址进行哈希运算,将相同的IP地址的请求分配到同一台服务器,以解决动态网页的session共享问题,适用于需要会话保持的场景。

高可用策略

为了实现高可用配置,负载均衡技术通常与其他高可用策略相结合,以下是一些实现高可用配置的关键步骤和策略:

冗余部署:将系统的关键组件部署在多台服务器上,通过搭建主备或集群架构来实现冗余,当主服务器出现故障时,备用服务器能够自动接管,保证系统的可用性。

故障转移与恢复:通过监测系统的健康状况,当检测到故障时,自动进行故障转移和恢复,常见的故障转移和恢复方式包括自动切换、自动恢复、自动重启等。

数据备份与恢复:定期对关键数据进行备份,并确保备份数据的可用性,当出现数据损坏或丢失时,可以通过备份数据进行快速恢复。

监控与告警:建立全面的监控系统,实时监测系统的性能指标、健康状态和异常情况,通过设置合理的告警规则,在系统出现故障或异常时及时通知运维人员,以便快速响应并采取措施修复。

网络冗余:设置多个网络入口和出口,通过网络冗余确保网络的可用性和稳定性,这有助于在单个网络节点出现故障时,其他节点能够继续提供服务。

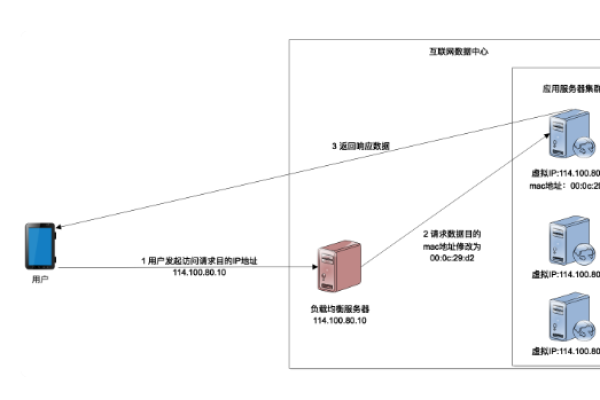

负载均衡器的健康检查

负载均衡器应定期检查后端服务器的健康状态,自动隔离异常状态的服务器,从而确保只有健康的服务器才能接收请求,这有助于防止单点故障,提高系统的整体可用性。

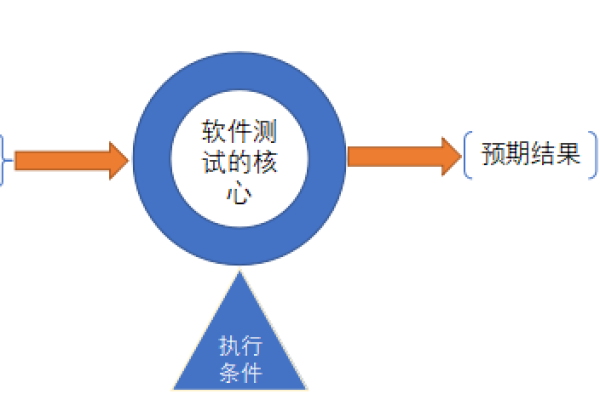

负载均衡配置测试

环境准备

准备两台主机并且都装有Nginx和Apache或者Tomcat,假设第一个主机A的ip为192.168.0.38,第二个主机B的ip为192.168.0.39,在主机A和主机B的apache访问目录(默认是/var/www/html)下放测试代码index.html,内容分别为【I am 192.168.0.38 server】和【I am 192.168.0.39 server】。

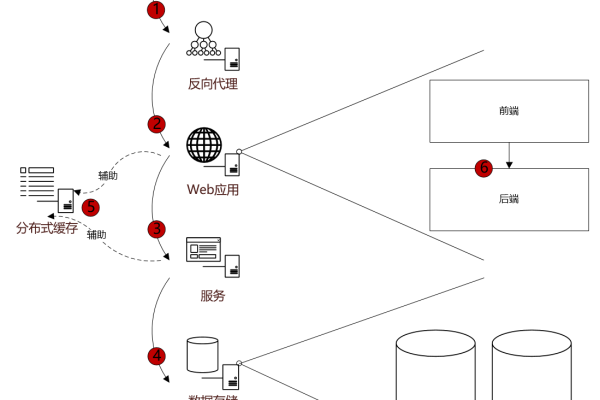

配置反向服务代理器

打开A主机的Nginx配置文件,在http模块内server模块外添加以下代码:

upstream load_balance {

server 192.168.0.39;

server 192.168.0.38;

}

server {

listen 80;

server_name localhost;

location / {

proxy_pass http://load_balance;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}重启A主机的Nginx服务:systemctl reload nginx,访问A主机的loadBalanceTest.html页面,实际上会访问B主机上的loadBalanceTest.html页面。

配置负载均衡例1

在A和B两台主机上做相同的如下配置:

upstream load_balance {

server 192.168.0.39;

server 192.168.0.38;

}

server {

listen 80;

server_name localhost;

location / {

proxy_pass http://load_balance;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}现在分别访问三次A主机和B主机都会出现的情况是:I am 192.168.0.38 server连续出现两次,第三次是I am 192.168.0.39 server,此后的刷新都是按照该规律。

配置负载均衡例2

也可以通过不同的端口做负载均衡配置:

//server.conf

server {

listen 8081;

root /soft/code1;

index index.html;

}

server {

listen 8082;

root /soft/code2;

index index.html;

}

server {

listen 8083;

root /soft/code3;

index index.html;

}

//proxy.conf

upstream node {

server 你的IP:8081;

server 你的IP:8082;

server 你的IP:8083;

}

server {

server_name localhost;

listen 80;

location / {

proxy_pass http://node;

proxy_set_header Host $http_host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}现在通过浏览器访问http://IP:80,则会轮流得到code1 code2 code3下面的index.html页面。

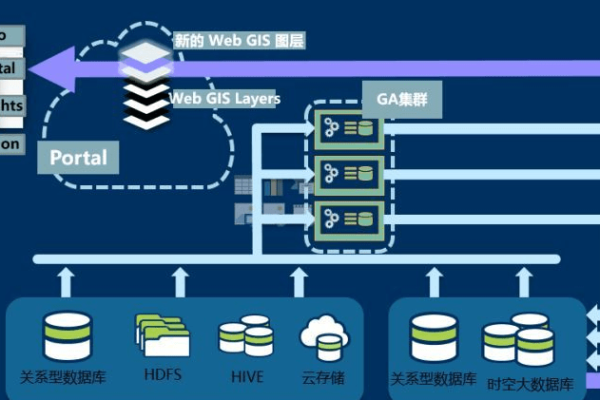

Nginx负载均衡调度策略

| 状态 | |

| down | 当前的server暂不参与负载均衡 |

| backup | 预留的备份服务器,当其他服务器都挂掉的时候,启用 |

| max_fails | 允许请求失败的次数 ,如果请求失败次数超过限制,则进过fail_timeout 时间后从虚拟服务池中kill掉该服务器 |

| fail_timeout | 经过max_fails失败后,服务暂停时间,max_fails设置后,必须设置fail_timeout值 |

| max_conns | 限制最大的连接数,用于服务器硬件配置不同的情况下 |

负载均衡通过多种算法和高可用策略,实现了系统的高可用性、高性能和可扩展性,在实际部署中,需要根据具体业务需求选择合适的负载均衡算法和策略,并进行充分的测试和监控,以确保系统的稳定性和可靠性,通过本文的介绍,希望读者对负载均衡的配置和测试有了更深入的了解。

小伙伴们,上文介绍了“负载均衡配置测试”的内容,你了解清楚吗?希望对你有所帮助,任何问题可以给我留言,让我们下期再见吧。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/360077.html