负载均衡长链接如何优化与管理?

- 行业动态

- 2024-11-30

- 2169

负载均衡长链接

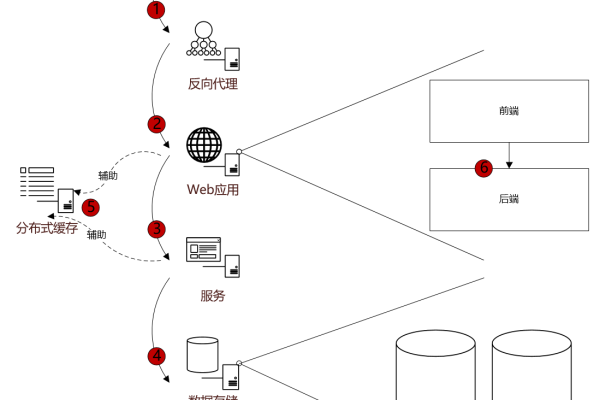

在现代的分布式系统中,负载均衡是确保系统高可用性和高性能的关键技术之一,长连接(也称为持久连接)是指客户端和服务器之间建立一次连接后,可以多次复用该连接进行数据传输,而不是每次传输数据都重新建立连接,这种方式可以减少连接建立和释放的开销,提高系统的吞吐量和效率,本文将探讨负载均衡与长连接的结合使用,分析其优势、实现方式以及可能面临的挑战。

负载均衡与长连接的优势

1、减少延迟:由于长连接避免了频繁的连接建立和断开过程,因此可以显著减少网络通信的延迟。

2、提高吞吐量:长连接允许多个请求复用同一个连接,减少了连接管理带来的开销,从而提高了系统的吞吐量。

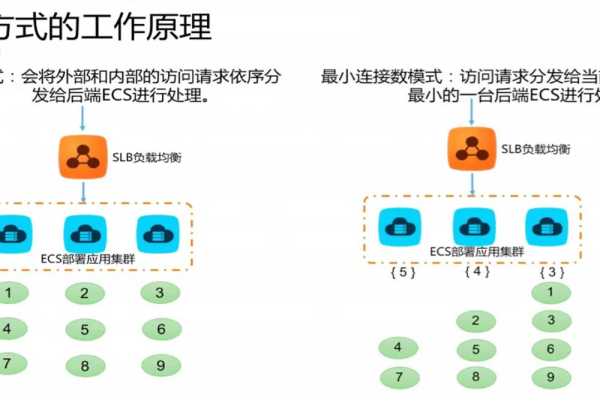

3、资源利用优化:通过负载均衡器合理分配长连接,可以避免单个服务器过载,实现资源的最优利用。

4、增强可靠性:负载均衡器可以在后端服务器出现故障时,将流量自动切换到其他健康的服务器上,保证服务的连续性。

实现方式

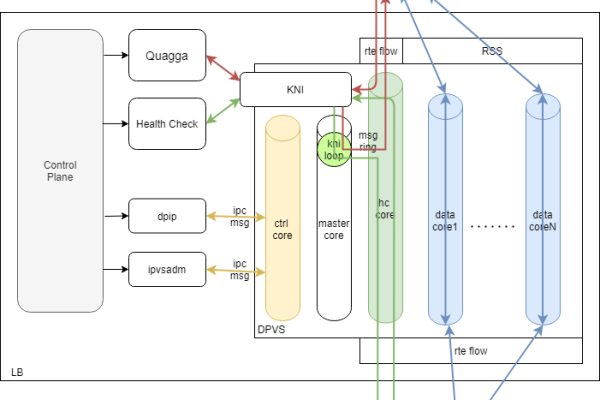

硬件负载均衡器

硬件负载均衡器通常部署在数据中心的网络边界,负责处理进出数据中心的流量,它们支持多种协议,包括HTTP、HTTPS、TCP等,并且能够处理大量的并发连接,硬件负载均衡器通常具备以下功能:

会话保持:确保来自同一客户端的请求被路由到同一台服务器。

健康检查:定期检查后端服务器的健康状态,自动剔除故障节点。

SSL卸载:在硬件层面处理SSL加密和解密,减轻后端服务器的负担。

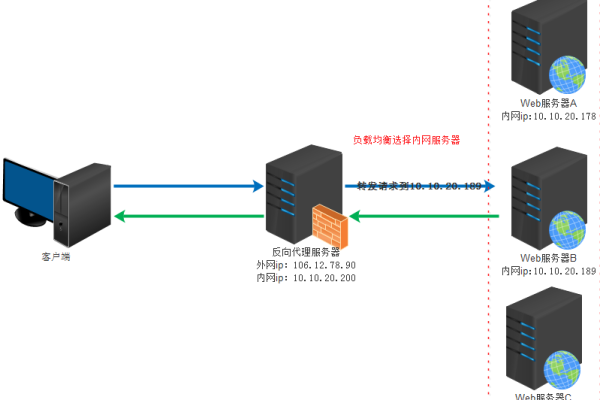

软件负载均衡器

软件负载均衡器运行在标准的服务器硬件上,常见的有Nginx、HAProxy、Traefik等,它们同样支持会话保持、健康检查等功能,并且可以通过配置文件灵活调整负载均衡策略,软件负载均衡器的优势在于成本较低,易于扩展和维护。

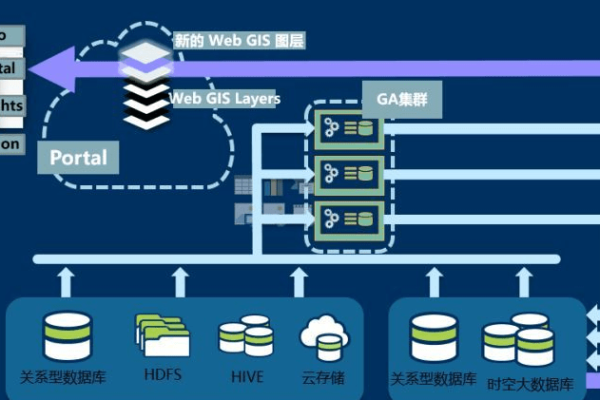

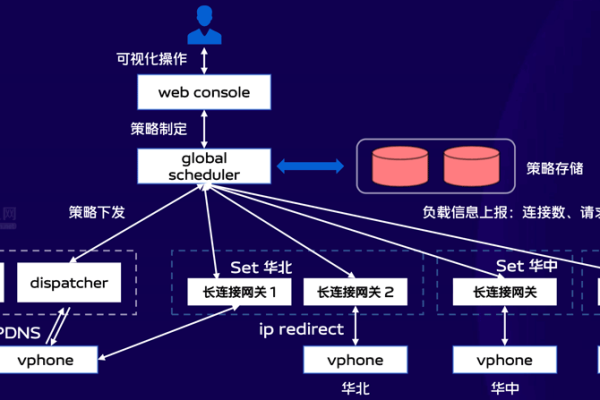

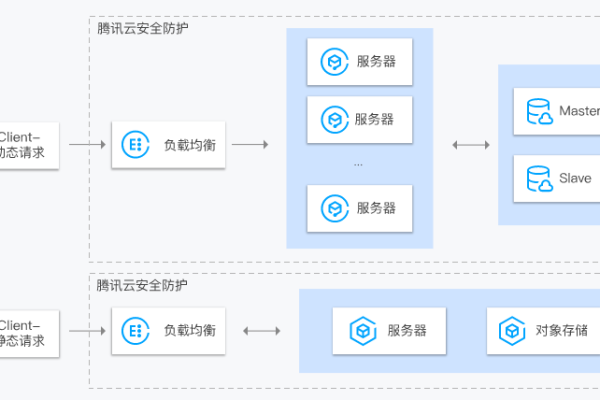

云服务负载均衡

云服务提供商如AWS、Azure和Google Cloud提供了内置的负载均衡服务,这些服务通常集成了自动扩展、弹性IP、安全组等功能,方便用户快速部署和管理负载均衡,云服务的负载均衡器还支持跨区域、跨云的负载分配,适合构建大规模的分布式系统。

挑战与解决方案

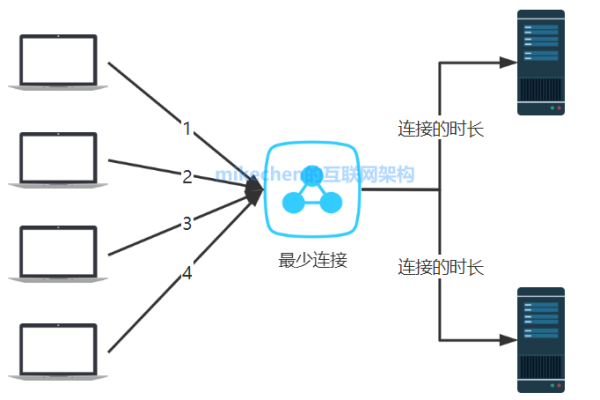

会话粘性问题

会话粘性是指在负载均衡过程中,需要确保来自同一用户的请求被路由到同一台服务器上,以保持会话状态的一致性,解决会话粘性问题的方法包括:

Cookie插入:负载均衡器在响应中插入一个特定的Cookie,后续请求携带该Cookie时,会被路由到同一个服务器。

IP哈希:根据客户端的IP地址计算哈希值,将请求路由到对应的服务器。

长连接的资源占用

长连接虽然减少了连接建立的开销,但长时间占用连接资源可能导致服务器资源紧张,解决这一问题的策略包括:

超时设置:为长连接设置合理的超时时间,超过时间未活动的连接将被关闭。

连接池:使用连接池技术,复用空闲的连接,减少新连接的创建。

安全性考虑

长连接可能会增加DDoS攻击的风险,因为攻击者可以利用长连接持续占用资源,为了提高安全性,可以采取以下措施:

限流:对每个IP地址的连接数进行限制,防止单个IP发起过多连接。

防火墙规则:配置防火墙规则,限制非规访问和异常流量。

负载均衡与长连接的结合使用,可以显著提升系统的性能和可靠性,通过合理的设计和配置,可以充分发挥两者的优势,同时应对可能出现的挑战,在选择负载均衡方案时,需要根据具体的业务需求和技术环境,综合考虑成本、性能、可扩展性等因素,做出合适的选择。

FAQs

Q1: 如何选择合适的负载均衡器?

A1: 选择合适的负载均衡器需要考虑以下几个因素:评估你的业务需求,包括预期的流量规模、峰值负载、以及对延迟和吞吐量的要求;考虑预算和成本效益,比较不同负载均衡器的性价比;考虑易用性和可维护性,选择操作简单、社区支持良好的产品;考虑扩展性和灵活性,选择能够随着业务增长而轻松扩展的解决方案。

Q2: 长连接在什么情况下不适合使用?

A2: 长连接虽然有很多优点,但在某些情况下可能不适合使用,当应用层协议不支持长连接时,或者当网络环境不稳定导致长连接容易中断时,短连接可能是更好的选择,如果应用对实时性要求极高,无法容忍任何延迟,那么长连接的建立和维持时间可能会成为瓶颈,在这些情况下,需要根据具体情况权衡利弊,决定是否使用长连接。

小伙伴们,上文介绍了“负载均衡长链接”的内容,你了解清楚吗?希望对你有所帮助,任何问题可以给我留言,让我们下期再见吧。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/358680.html