BP神经网络死机原因和应对方法

- 行业动态

- 2025-04-10

- 3

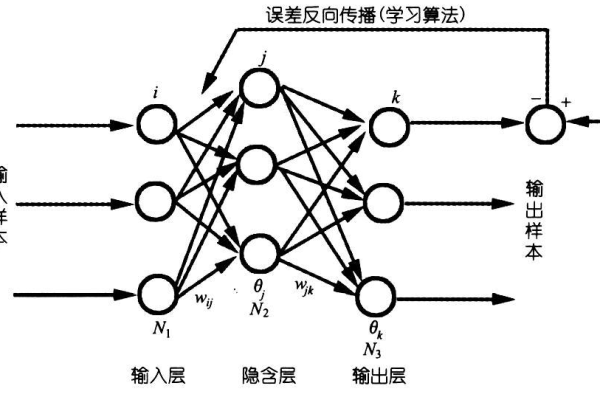

BP神经网络训练“死机”原因及应对方法

在运用BP神经网络进行模型训练时,常会遇到程序卡顿、长时间无响应或直接崩溃的现象(俗称“死机”),这种现象不仅影响研发效率,还可能对硬件设备造成损耗,以下是导致该问题的常见原因及科学解决方案,帮助开发者高效排查问题并优化模型性能。

死机常见原因分析

数据规模与质量问题

- 内存溢出(OOM):输入数据量过大(如高分辨率图像或长序列数据)超出CPU/GPU内存容量。

- 数据异常值:未处理的离群值导致梯度爆炸,反向传播时权重剧烈波动。

- 类别不平衡:极端不平衡样本使模型陷入局部最优,训练停滞。

硬件资源瓶颈

- 显存不足:GPU显存被占用导致多任务训练时资源分配冲突。

- CPU/GPU负载过高:未合理设置批量大小(Batch Size)或并行线程数,硬件过热触发保护机制。

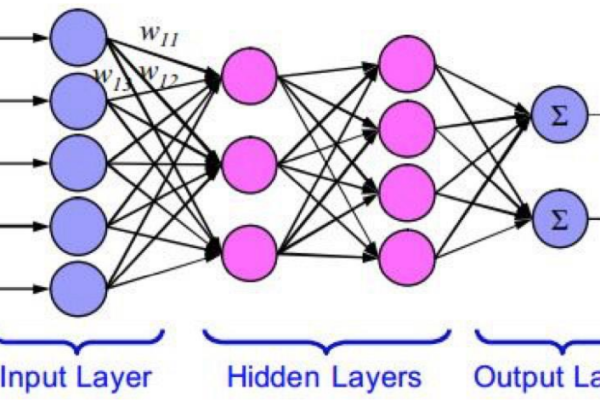

模型结构与参数设置

- 层数过深:隐层层数过多或神经元数量过大,计算复杂度呈指数级增长。

- 激活函数选择不当:如Sigmoid函数在深层网络中易引发梯度消失(Gradient Vanishing)。

- 学习率过高/过低:学习率设置不合理导致权重更新震荡或收敛停滞。

代码与框架问题

- 内存泄漏:循环中未释放中间变量,内存持续占用直至崩溃。

- 版本兼容性:深度学习框架(如TensorFlow、PyTorch)与驱动或CUDA版本不匹配。

针对性解决方案

阶段1:数据预处理优化

内存管理

采用分批次加载(Batch Loading)或数据流(Data Streaming)技术,避免一次性加载全部数据。

示例:使用tf.data.Dataset或torch.utils.data.DataLoader动态读取数据。异常值处理

通过Z-Score标准化、Winsorize缩尾或四分位法(IQR)过滤异常数据。数据增强与平衡

对少数类样本进行过采样(如SMOTE算法),或引入焦点损失函数(Focal Loss)缓解类别不平衡影响。

阶段2:硬件资源调配

显存监控

使用nvidia-smi或GPUtil库实时监测显存占用,限制单任务显存使用率(如设置tf.config.set_soft_device_placement(True))。

分布式训练

采用数据并行(Data Parallelism)或模型并行(Model Parallelism)技术拆分计算负载,PyTorch的DistributedDataParallel模块。混合精度训练

启用FP16半精度计算(支持NVIDIA Tensor Core的GPU),显存占用减少50%,训练速度提升1.5-3倍。

阶段3:模型结构与超参数调优

网络轻量化

使用残差连接(ResNet)、通道剪枝(Channel Pruning)或知识蒸馏(Knowledge Distillation)降低参数量。梯度裁剪与归一化

在反向传播时添加梯度裁剪(Gradient Clipping),限制梯度范围(如torch.nn.utils.clip_grad_norm_)。

自适应学习率策略

采用Adam、RMSProp等优化器替代传统SGD,或使用余弦退火(Cosine Annealing)动态调整学习率。

阶段4:代码级排查与调试

性能分析工具

利用Profiler工具(如TensorBoard、PyTorch Profiler)定位计算瓶颈,优化高耗时代码段。框架版本适配

严格匹配CUDA、cuDNN与深度学习框架版本,参考官方文档测试兼容性。

实战案例:快速诊断流程

- 日志与报错分析

检查终端输出的错误类型(如CUDA out of memory、NaN loss),优先解决显存不足或数值不稳定问题。 - 简化复现路径

逐步缩小输入数据规模或减少网络层数,验证问题是否由特定模块引发。 - 单元测试验证

对数据预处理、前向传播、损失函数等模块单独测试,排除代码逻辑错误。

引用说明

- Lecun, Y., Bottou, L., Bengio, Y., & Haffner, P. (1998). Gradient-based learning applied to document recognition. Proceedings of the IEEE.

- Krizhevsky, A., Sutskever, I., & Hinton, G. E. (2012). ImageNet classification with deep convolutional neural networks. NeurIPS.

- TensorFlow官方文档:内存优化指南(https://www.tensorflow.org/guide/gpu)

- PyTorch分布式训练教程(https://pytorch.org/tutorials/intermediate/ddp_tutorial.html)