如何在WordPress中轻松嵌入压缩文档?

- 行业动态

- 2024-10-04

- 3

在WordPress网站中添加压缩文档,无论是为了提高页面加载速度,还是为了方便用户下载,都是一个重要的功能,以下将详细介绍如何在WordPress文章或页面中添加压缩文档:

方法一:使用插件上传ZIP文件

1、安装并激活插件:您需要安装并激活一个支持文件上传的插件,如“WPBeginner’s Compact Archives”,这个插件不仅允许您创建紧凑的存档,还能让您轻松地在WordPress文章中添加各种类型的文件,包括ZIP文件。

2、上传ZIP文件:登录到您的WordPress后台,打开一篇文章或页面,点击左上角的“+”按钮以打开区块菜单,找到并添加“Compact Archives”区块,在这个区块中,您可以选择上传ZIP文件,上传后,文件将自动显示为一个可下载的链接。

3、配置显示设置:在“Compact Archives”区块的设置面板中,您可以选择不同的样式来展示您的ZIP文件,您可以选择显示为列表、下拉菜单或数字块等。

4、发布或更新:完成设置后,点击“发布”或“更新”按钮,您的ZIP文件就会在WordPress文章或页面中显示出来,用户可以点击链接进行下载。

方法二:手动上传ZIP文件

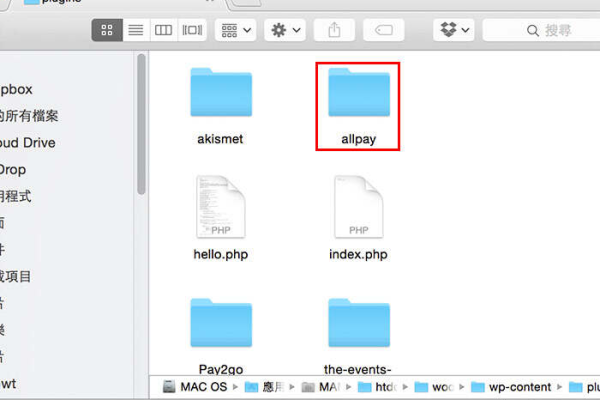

1、使用媒体库上传:如果您不想使用插件,也可以直接通过WordPress的媒体库来上传ZIP文件,登录到WordPress后台,打开一篇文章或页面,点击“添加媒体”按钮,在弹出的媒体库窗口中,点击“上传文件”,然后选择您的ZIP文件进行上传。

2、插入到文章或页面:上传完成后,您可以在媒体库中找到刚刚上传的ZIP文件,点击该文件下方的“插入至文章”按钮,文件就会以链接的形式插入到您的文章或页面中。

3、配置链接文本:如果需要,您还可以编辑链接文本,使其更具描述性,您可以将其更改为“点击此处下载压缩文档”。

4、发布或更新:同样,点击“发布”或“更新”按钮,您的ZIP文件就会在WordPress文章或页面中显示出来,用户可以点击链接进行下载。

相关问题与解答

1、如何确保用户能够顺利下载ZIP文件?

确保您的服务器配置正确,允许用户下载ZIP文件,还要检查文件是否已正确上传到服务器,并且链接地址是否正确,建议在文件下载前进行干扰扫描,确保文件安全无虞。

2、如何限制用户只能下载特定类型的文件?

如果您希望限制用户只能下载特定类型的文件(如PDF、DOC等),可以使用文件上传插件来实现,这些插件通常允许您设置允许上传的文件类型和大小等限制条件。

通过以上两种方法,您可以轻松地在WordPress文章或页面中添加压缩文档,无论您选择哪种方法,都要确保遵循最佳实践和安全准则,以确保您的网站既易于使用又安全可靠。

小伙伴们,上文介绍了“如何在WordPress文章或页面中添加压缩文档?”的内容,你了解清楚吗?希望对你有所帮助,任何问题可以给我留言,让我们下期再见吧。