从数据获取到深度学习

- 行业动态

- 2025-04-07

- 2

从数据获取到深度学习是一个复杂且多阶段的过程,涉及数据的收集、预处理、特征工程、模型选择与训练,以及最终的评估与部署,以下是这一过程的详细步骤:

数据获取

确定需求:首先明确需要解决的问题或目标,这将指导后续的数据收集工作。

数据源识别:根据需求确定数据来源,可以是公开数据集、内部数据库、网络爬虫、传感器收集等。

数据采集:使用合适的工具和技术从选定的数据源中提取数据,API调用、数据库查询、文件下载等。

数据存储:将采集到的数据安全地存储在适当的介质上,如硬盘、云存储服务等。

数据预处理

清洗:去除重复、错误或不完整的数据记录。

归一化/标准化:调整数据尺度,使不同特征具有相似的范围,便于模型处理。

缺失值处理:填充或删除含有缺失值的记录。

异常值检测与处理:识别并处理数据中的异常值,以避免对模型训练造成负面影响。

数据转换:根据需要对数据进行编码、分词、独热编码等转换操作。

特征工程

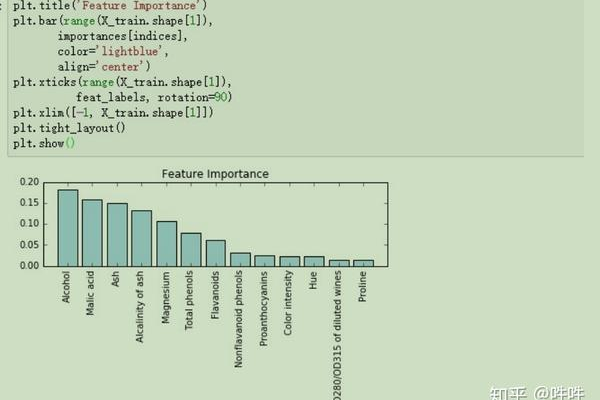

特征选择:从原始数据中挑选出最有助于预测或分类的特征。

特征提取:通过数学变换或统计方法从原始特征中创造出新的特征。

特征构建:结合领域知识,创造全新的特征以提升模型性能。

模型选择与训练

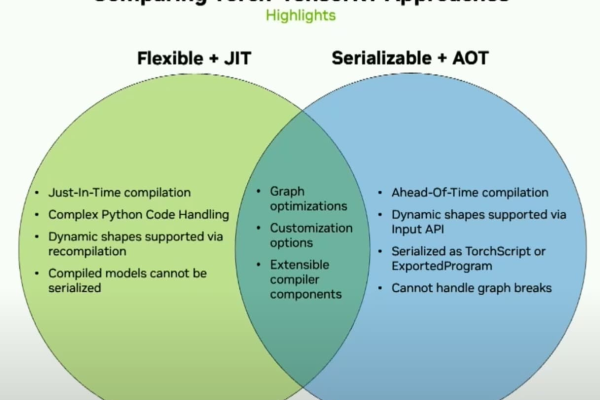

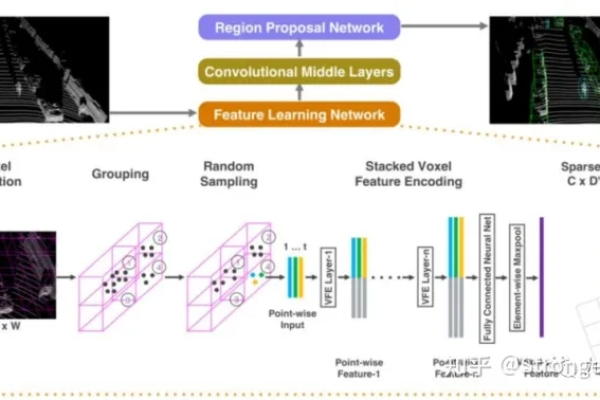

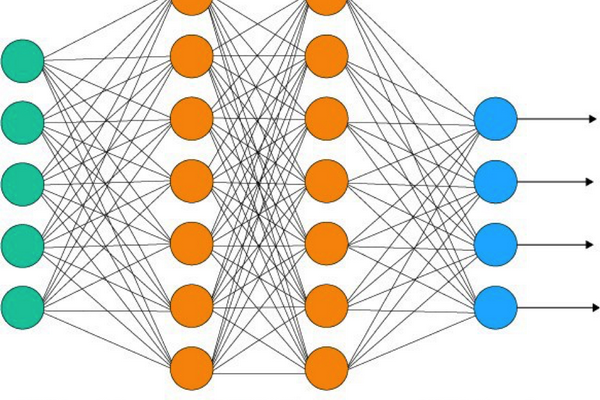

选择算法:根据问题类型(回归、分类、聚类等)和数据特性选择合适的深度学习模型,如神经网络、卷积神经网络(CNN)、循环神经网络(RNN)等。

划分数据集:将数据集分为训练集、验证集和测试集。

训练模型:使用训练集对选定的模型进行训练,通过优化算法最小化损失函数。

超参数调优:调整学习率、批次大小、迭代次数等超参数以提高模型性能。

验证与调整:利用验证集评估模型表现,必要时进行调整和重新训练。

评估与部署

模型评估:在测试集上评估模型的泛化能力,使用准确率、精确率、召回率、F1分数等指标。

模型解释性:对于某些应用场景,可能需要解释模型决策过程,提高透明度和可信度。

部署:将训练好的模型集成到实际应用中,可能是Web服务、移动应用或其他系统。

监控与维护:持续监控模型性能,根据反馈和新数据进行迭代更新。

FAQs

Q1: 深度学习模型总是需要大量的数据吗?

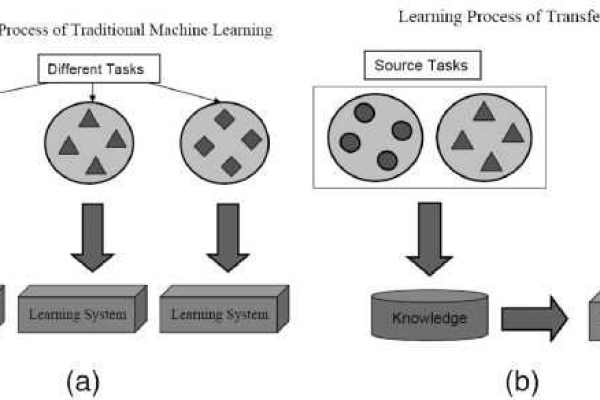

A1: 虽然深度学习模型通常需要大量数据来充分训练,但“大量”是相对的,取决于任务的复杂度和模型的容量,有些任务可能只需要几千条样本就能达到较好的性能,而有些则可能需要数百万甚至更多,数据的质量远比单纯的数量重要,高质量的数据可以更有效地训练模型。

Q2: 如何处理深度学习中的过拟合问题?

A2: 过拟合是指模型在训练数据上表现良好,但在未见过的测试数据上表现不佳的现象,解决方法包括:

正则化:如L1/L2正则化、Dropout等技术,限制模型复杂度。

增加数据量:通过数据增强、合成新数据等方式增加训练样本多样性。

早停法:在验证集上监控模型性能,当性能不再提升时停止训练。

简化模型:减少模型层数、神经元数量或使用更简单的模型结构。