从数据获取到可视化

- 行业动态

- 2025-04-07

- 2

全流程解析与实践指南

在当今数字化时代,数据已成为驱动决策、洞察趋势和创造价值的核心资产,从海量数据中提取有价值信息,并以直观易懂的可视化形式呈现,是各领域专业人士必备的技能,这一过程涵盖数据获取、清洗、分析与可视化多个关键环节,以下将对其进行详细阐述。

一、数据获取

数据获取是从各种数据源收集原始数据的过程,这些数据源丰富多样,常见的包括:

1、数据库:关系型数据库(如 MySQL、Oracle)和非关系型数据库(如 MongoDB、Redis)存储着结构化的数据,通过编写 SQL 查询语句或使用特定数据库客户端工具,能精准提取所需数据,企业的销售管理系统数据库,可获取产品销售记录、客户信息等。

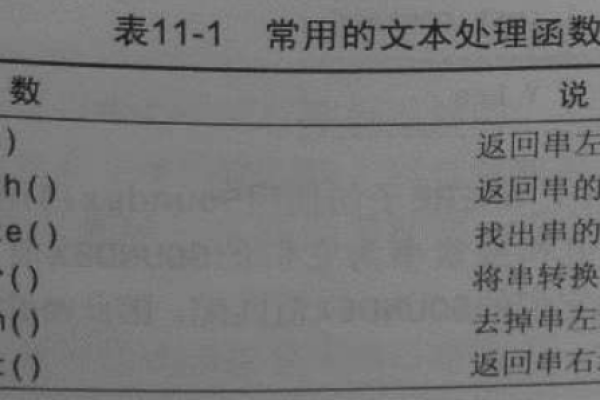

2、文件:文本文件(如 CSV、TXT)、电子表格(如 Excel)以及 JSON、XML 等格式文件广泛存在,使用编程语言(如 Python 的 pandas 库)读取文件,能轻松处理本地存储的数据,从包含市场调研问卷结果的 CSV 文件中获取受访者反馈数据。

3、网络爬虫:对于公开网页上的数据,网络爬虫技术可自动抓取,利用 Python 的 Scrapy、BeautifulSoup 等框架,遵循网站的爬虫规则,能采集新闻资讯、电商产品信息等,但需注意遵守网站的使用条款和法律法规,避免过度爬取造成服务器负担或侵犯隐私。

4、API:许多在线服务提供应用程序编程接口(API),如社交媒体平台的微博、推特 API,天气数据的 API 等,通过向 API 发送请求并按照规范解析返回数据,能实时获取动态更新的数据流,为数据分析提供新鲜素材。

二、数据清洗

原始数据往往存在噪声、缺失值、重复数据等问题,数据清洗旨在提升数据质量,确保后续分析的准确性,主要步骤包括:

1、缺失值处理:可采用删除含有缺失值的记录、插补法(如均值、中位数填充数值型缺失值,众数填充类别型缺失值)等策略,在一份学生成绩表中,若部分学生的某科成绩缺失,可根据该科成绩的平均分进行填充。

2、异常值检测与处理:借助统计方法(如箱线图识别离群点)或基于业务规则判断异常值,对于异常值,可修正错误数据、删除明显不合理记录或将其视为特殊情况单独分析,在员工薪资数据中,若出现远超平均水平且不符合公司薪酬体系的极高薪资记录,需进一步核实与处理。

3、重复数据处理:通过比较数据的关键字段,去除完全重复或部分重复的记录,保证数据集的唯一性,在客户订单数据中,可能存在因系统故障等原因导致的重复下单记录,需准确识别并剔除。

4、数据类型转换与标准化:统一数据格式,如将日期格式统一为“YYYY-MM-DD”,对数值型数据进行归一化或标准化处理,使不同量级的数据具有可比性,便于后续分析与建模。

三、数据分析

经过清洗的数据进入分析阶段,根据数据特点和研究目的选择合适的分析方法:

1、描述性统计分析:计算均值、中位数、标准差、频率分布等统计指标,快速了解数据的集中趋势、离散程度和分布形态,以电商平台销售数据为例,通过描述性统计可知晓各类商品的平均销量、销售额波动情况以及不同品类商品的市场占有率。

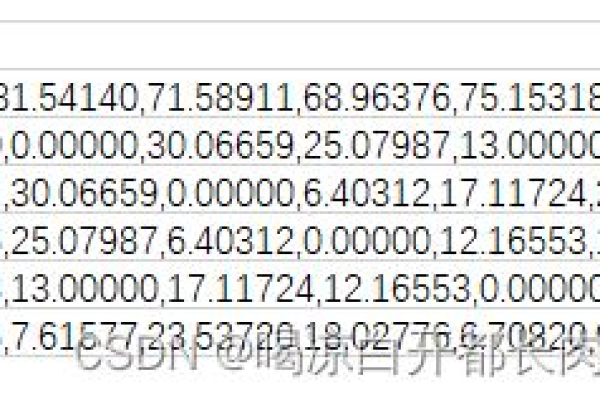

2、相关性分析:探究变量之间的线性关系强度与方向,常用的相关系数有皮尔逊相关系数(适用于连续变量)、斯皮尔曼等级相关系数(适用于有序分类变量),在医疗研究中,分析患者年龄、生活习惯与疾病发病率之间的相关性,为疾病预防提供依据。

3、聚类分析:将数据对象分组,使得组内对象相似度高、组间差异大,K-Means 聚类算法常用于客户细分,依据消费行为、收入水平等特征将客户划分为不同群体,以便制定针对性营销策略。

4、回归分析:建立因变量与自变量之间的数学模型,预测因变量的变化趋势,如在房地产市场中,以房屋面积、房龄、周边配套设施等因素为自变量,房价为因变量建立回归模型,预估房产价格走势。

四、数据可视化

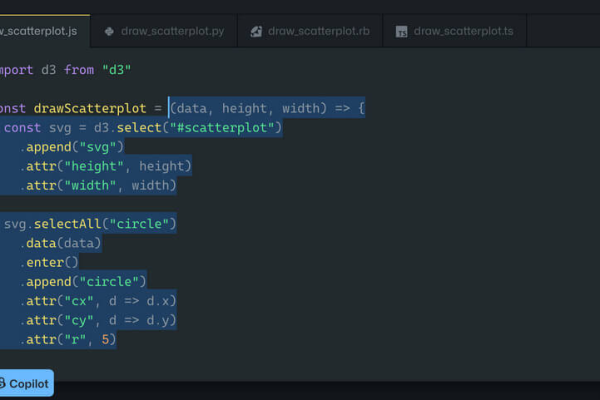

可视化是将抽象数据转化为直观图形或图像的过程,帮助用户更高效地理解数据内涵、发现规律与洞察,常见可视化图表及适用场景如下:

| 可视化图表 | 适用场景 | 示例说明 |

| 柱状图 | 比较不同类别数据大小,展示数据分布 | 对比各季度产品销售额,直观呈现季度间销售差异 |

| 折线图 | 展示数据随时间或其他连续变量变化趋势 | 分析股票价格在一段时间内的波动走势 |

| 饼图 | 显示各部分占总体比例关系,突出占比份额 | 呈现公司不同业务板块营收占总营收的比重 |

| 散点图 | 探索两个连续变量之间的关系,发现数据聚集模式 | 研究城市人均收入与房价之间的关联 |

| 地图可视化 | 展示地理空间数据的分布与差异,适用于地域分析 | 呈现全球碳排放来源地区分布 |

五、相关问答FAQs

问题一:如何选择合适的数据可视化图表?

答:选择可视化图表需综合考虑数据类型、分析目的与受众需求,若想展示数据大小对比,柱状图较合适;若是体现时间序列变化,折线图为佳;反映部分与整体比例关系用饼图;探索变量关系选散点图;涉及地理空间数据则优先考虑地图可视化,要考虑受众背景知识与接受程度,确保图表简洁明了、易于理解。

问题二:在数据清洗过程中,如何处理大量缺失值且不丢失过多信息?

答:面对大量缺失值,可先分析缺失机制,判断是随机缺失还是系统性缺失,若为随机缺失,多重插补法是一种有效方式,它通过考虑变量间的相关性生成多个可能的插补值,综合多次插补结果进行分析,能在保留数据变异性的同时填补缺失值,减少信息损失,也可根据业务逻辑和专家经验对缺失值进行合理推测与填补。